AI活用ブログ

AI活用ブログ 社外秘をクラウドに渡さない!Secure Minionsが示す次世代AI運用像

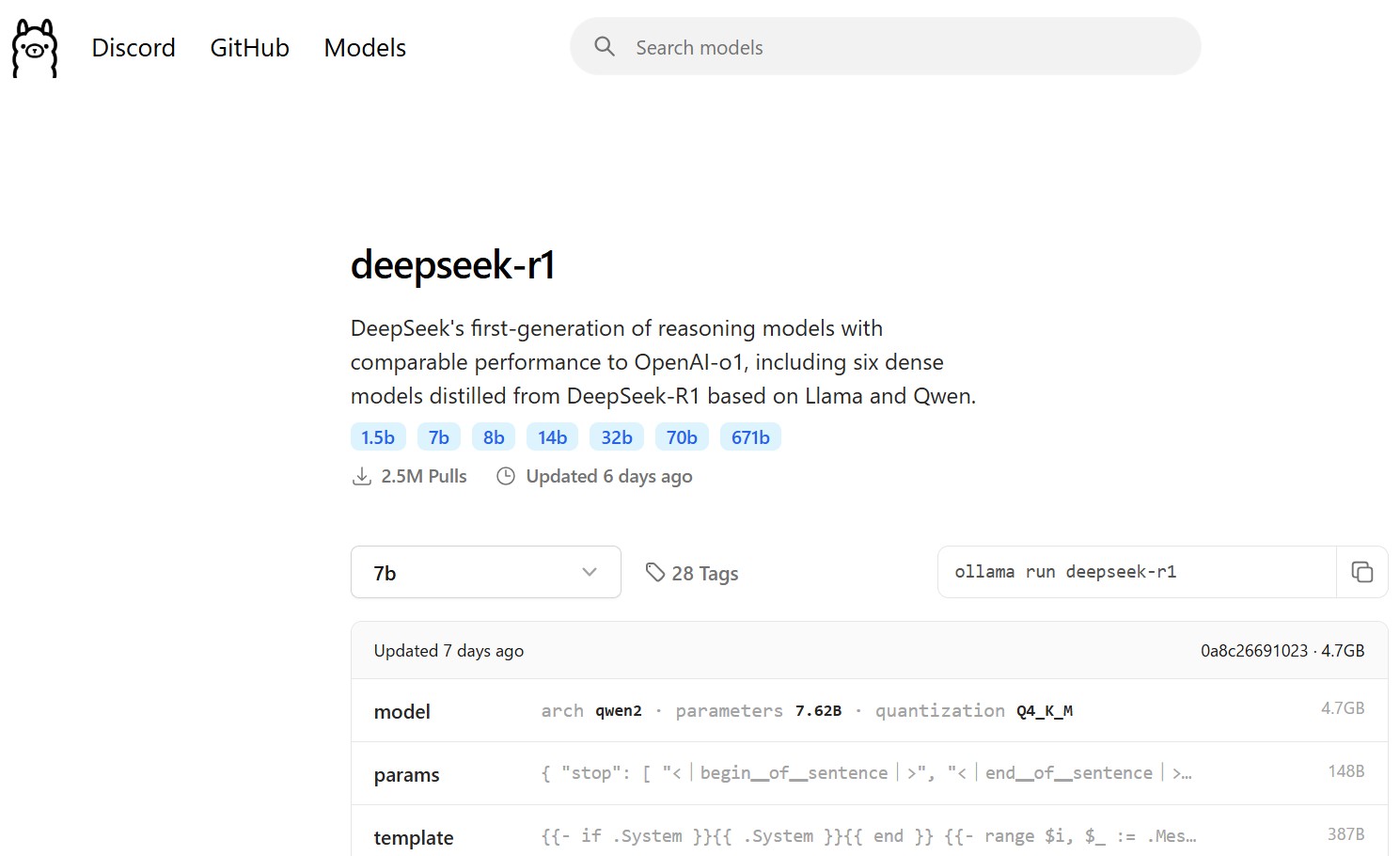

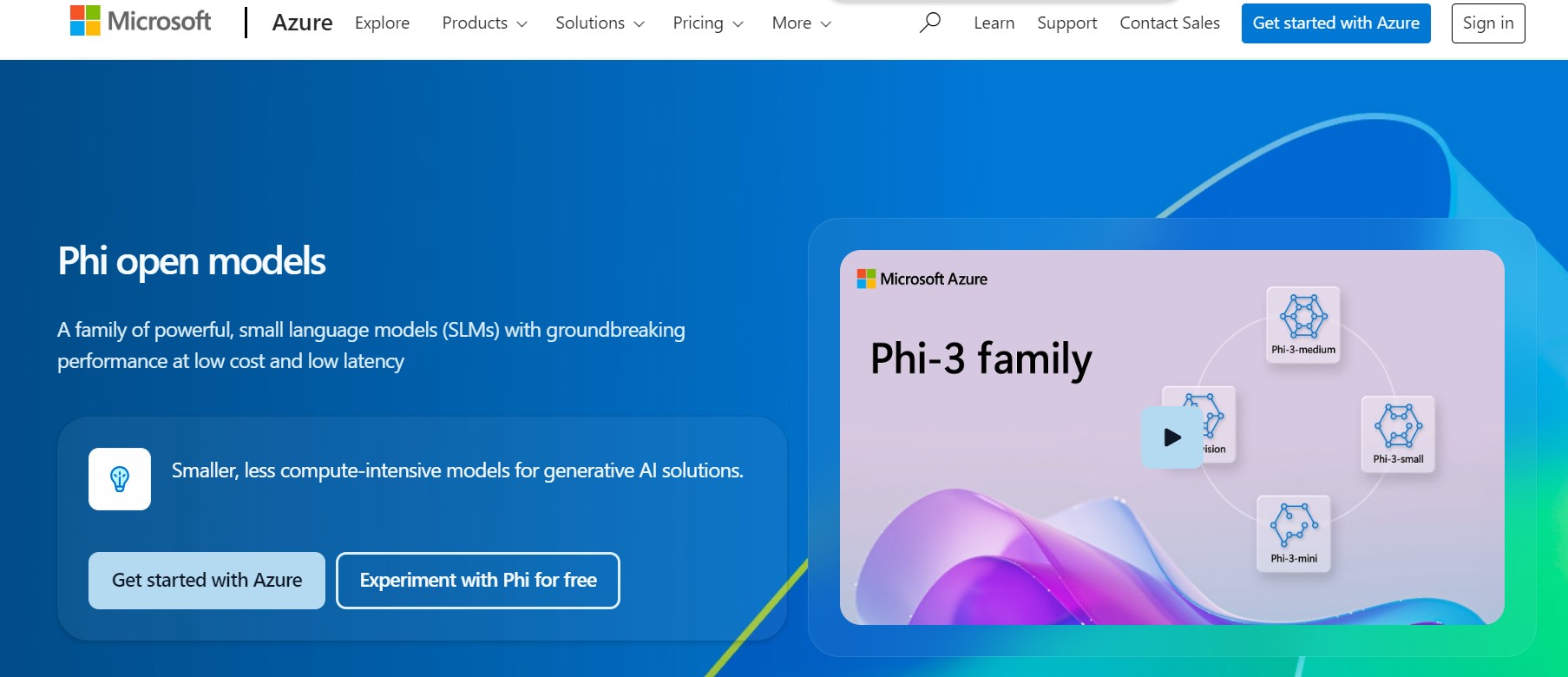

Ollama+H100で叶う“見せないAI活用”── コスト5分の1・精度98%の衝「機密資料をAIに食べさせたいが、クラウドに流出するのは怖い」──そんな葛藤を抱える読者に朗報です。本稿では、スタンフォード大学が開発した新プロトコル「Se...

AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ  AI活用ブログ

AI活用ブログ