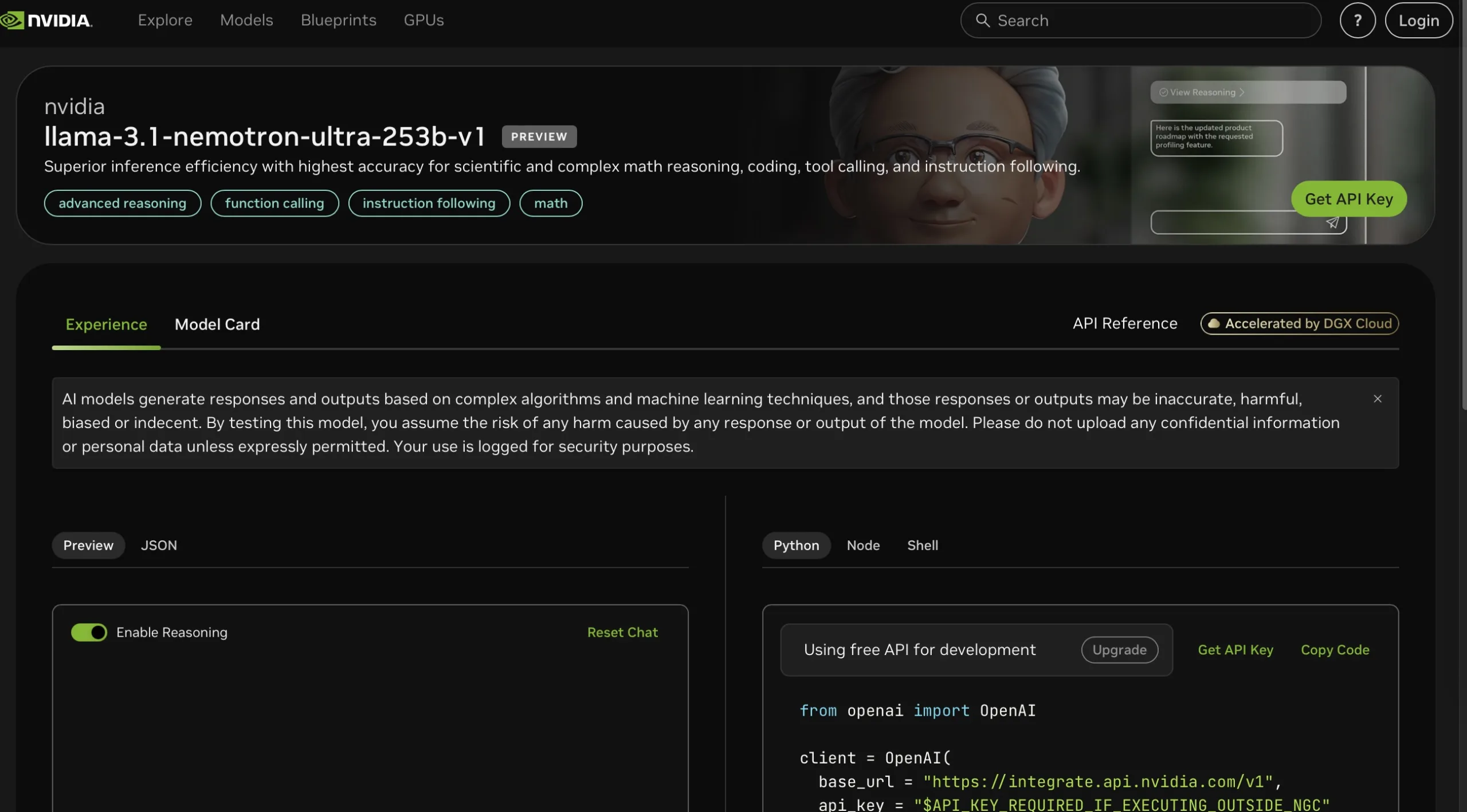

AIモデルの最前線に立つNvidiaが再び注目を集めています。新たに登場した「Llama-3.1 Nemotron Ultra」は、AIモデルの競争において一歩先んじた存在となっています。

この記事では、「Llama-3.1 Nemotron Ultra」がどのようにして既存の技術を上回り、どのようにして開発者や企業のニーズに応えているのかを詳しく解説します。

Nvidiaが挑む次世代AIモデル開発

Nvidiaが発表した「Llama-3.1 Nemotron Ultra」は、AI業界に新たなパラダイムをもたらしています。このモデルはMetaが開発したLlama-3.1-405B-Instructをベースとしながらも、Nvidia独自の技術的革新により、とくに推論性能において顕著な進化を遂げています。

同モデルの最大の強みは、高度な推論能力と精密な指示追従機能の両立にあります。これによりAIアシスタントの応答精度と実用性が大幅に向上し、企業や開発者が直面していた従来の課題を解決に導きます。この技術的飛躍を支えているのは、Nvidiaが長年培ってきたGPU技術の専門知識と、AIモデルの性能最適化に対する継続的な研究開発の成果です。

特筆すべきは、Llama-3.1 Nemotron Ultraがデータセンター運用においてコスト効率と性能のバランスを実現している点です。高度な機能を維持しながらも計算資源を効率的に活用することで、AIシステムの導入・運用コストを抑制し、より広範な実用展開を可能にしています。

効率性を追求したアーキテクチャ設計

Llama-3.1 Nemotron Ultraの成功の鍵は、その効率的なアーキテクチャにあります。このモデルは、AI構造の最適化を自動的に行う「Neural Architecture Search(NAS)」プロセスを通じて精密にカスタマイズされています。

具体的には、情報処理の一部工程を省略して効率化する「スキップアテンション層」、複数の処理を一体化して計算コストを削減する「融合フィードフォワードネットワーク(FFN)」、そして処理の重要度に応じて圧縮率を調整する「可変FFN圧縮比率」といった革新的な構造が導入されています。

これらの技術革新により、モデルの性能を維持しながらも、メモリ使用量と計算負荷を大幅に軽減することに成功しています。

強化された推論能力:マルチフェーズポストトレーニング

このモデルの推論能力は、マルチフェーズポストトレーニングプロセスによってさらに向上しています。Nvidiaは、数学、コード生成、チャット、ツール使用といった多様なドメインでの監督下での微調整を行い、その後、グループ相対ポリシー最適化(GRPO)を用いた強化学習を実施しました。

これにより、指示追従と推論性能が一層強化されています。さらに、知識蒸留フェーズを65億トークンにわたって実施し、追加の88億トークンでの継続的な事前訓練を行いました。

トレーニングデータセットには、FineWeb、Buzz-V1.2、Dolmaといったソースが含まれており、ポストトレーニングのプロンプトと応答は、公開コーパスや合成生成法から引き出され、モデルが推論モードを区別する方法を学習しました。

多様なドメインとベンチマークでの向上した性能

Llama-3.1 Nemotron Ultraは、推論モードでの運転時に顕著な性能向上を示しています。例えば、MATH500ベンチマークでは、標準モードでの80.40%から推論モードで97.00%に性能が向上しました。

同様に、AIME25ベンチマークでは16.67%から72.50%に、LiveCodeBenchスコアは29.03%から66.31%に倍増しました。ツールベースのタスクや一般的な質問応答(GPQA)においても、推論モードでの性能向上が確認され、たとえば、GPQAでは推論モードで76.01%を記録し、推論なしの56.60%を大きく上回りました。

これらのベンチマークは、最大32,000トークンのシーケンス長で行われ、精度を確保するために各テストは最大16回繰り返されました。

DeepSeek R1との競争:半分のサイズでの圧倒的性能

Llama-3.1 Nemotron Ultraは、DeepSeek R1との比較においても優れた性能を示しています。

DeepSeek R1は、6710億ものパラメータを持つ最先端のMoEモデルですが、Llama-3.1 Nemotron Ultraはその半分以下のパラメータ数でありながら、GPQAやIFEval指示追従といったタスクで競争力のある結果を出しています。

たとえば、GPQAにおいては、Llama-3.1 Nemotron Ultraが76.01%のスコアを達成し、DeepSeek R1の71.5%を上回っています。このように、Nvidiaの新モデルは、パラメータ数を大幅に削減しながらも、高い性能を維持しており、AIモデルの設計や開発における新たなアプローチを示しています。

AI業界におけるLlama-3.1の位置付けと今後の展望

Llama-3.1 Nemotron Ultraの登場は、AI業界におけるNvidiaの影響力をさらに強化するものです。このモデルは、AI開発者や企業が求める高い性能とコスト効率を両立したソリューションを提供し、AI技術の普及と進化を加速させる役割を果たしています。

今後、Nvidiaがどのようにしてこのモデルをさらに進化させていくのか、また、他の企業がどのようにしてこの技術革新に応えていくのかが注目されます。AI技術が進化する中で、NvidiaのLlama-3.1 Nemotron Ultraは、次世代のAIモデル開発の基盤となる可能性を秘めています。

まとめ:NvidiaのLlama-3.1 Nemotron Ultraは、AI技術革新の新たな一歩

NvidiaのLlama-3.1 Nemotron Ultraは、AIモデルの新たな可能性を示す重要なステップです。効率的なアーキテクチャ設計と強化された推論能力により、既存の技術を凌駕する性能を発揮しています。

DeepSeek R1との競争においても、その優れた性能が証明されており、今後のAI技術の方向性を大きく左右する存在となるでしょう。Nvidiaの革新は、AI業界全体に新たな基準を設定し、さらなる技術の発展を促進することでしょう。