本記事ではPhi-4-miniの特徴やインストール手順、ハードウェア要件などを一気に紹介します。本記事の内容によって、自分のPCでプライバシーを守りながら強力なAIを使いこなす方法がわかるでしょう。「ローカルで動かすなんて難しそう」と思う方ほど、その手軽さに驚くはずです。

この記事の内容は上記のGPTマスター放送室でわかりやすく音声で解説しています。

小型AIモデルPhi-4-miniとは?

Microsoftが2025年2月26日にリリースしたPhi-4-miniは、3.8Bパラメータの小型言語モデル(SLM)です。

通常、より大きなパラメータ数を持つモデルほど高度な性能を期待できると言われますが、Phi-4-miniはその常識を覆すほどの高い推論能力を持ち、数学的推論や論理的推論、コーディングといったタスクで優れた結果を出すと報告されています。

とくにMATHなどのベンチマークでは80.4%という高スコアを記録しており、一部では2倍のサイズを持つモデルと同等以上の性能を示すことが確認されています。これは、公開ドメインの文書から合成データ、学術書、Q&Aデータセットまで、多様で高品質なデータを学習していることが大きな要因とされています。

ローカルでの利用がもたらすメリット

- プライバシーの確保:クラウドサービスを介さずローカルで推論を行うため、入力データが外部サーバに送信される心配がありません。機密情報の取り扱いにも安心です。

- コスト削減:一度モデルをダウンロードしてしまえば、月額利用料やAPI使用料などが発生しません。長期的に見ると、クラウドベースのサービスよりも低コストで運用できます。

- 軽量かつ高速な推論:大規模モデルほどのリソースが不要で、普通のラップトップでもある程度快適に動作します。GPUがあればさらに高速化が期待できます。

LM Studioを使ったインストール

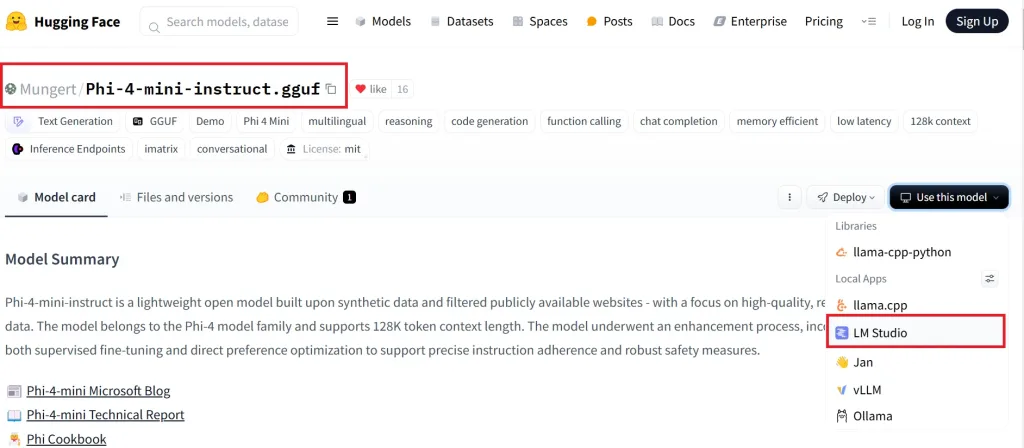

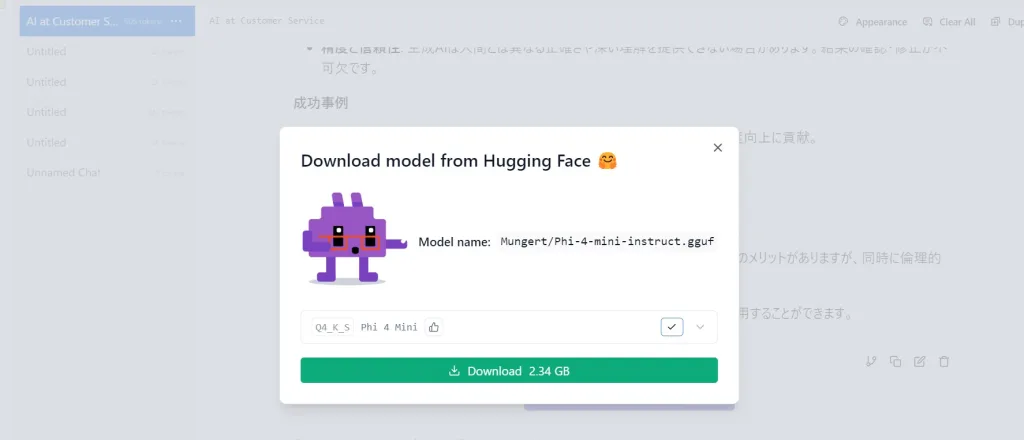

GGUF形式となった「Mungert/Phi-4-mini-instruct.gguf」というモデルをインストールします。

上記が動かない場合は、「bartowski/microsoft_Phi-4-mini-instruct-GGUF」だと動きます。

「Use This model」から、LM Studioでインストールします。ダウンロードサイズは2.34GBです。

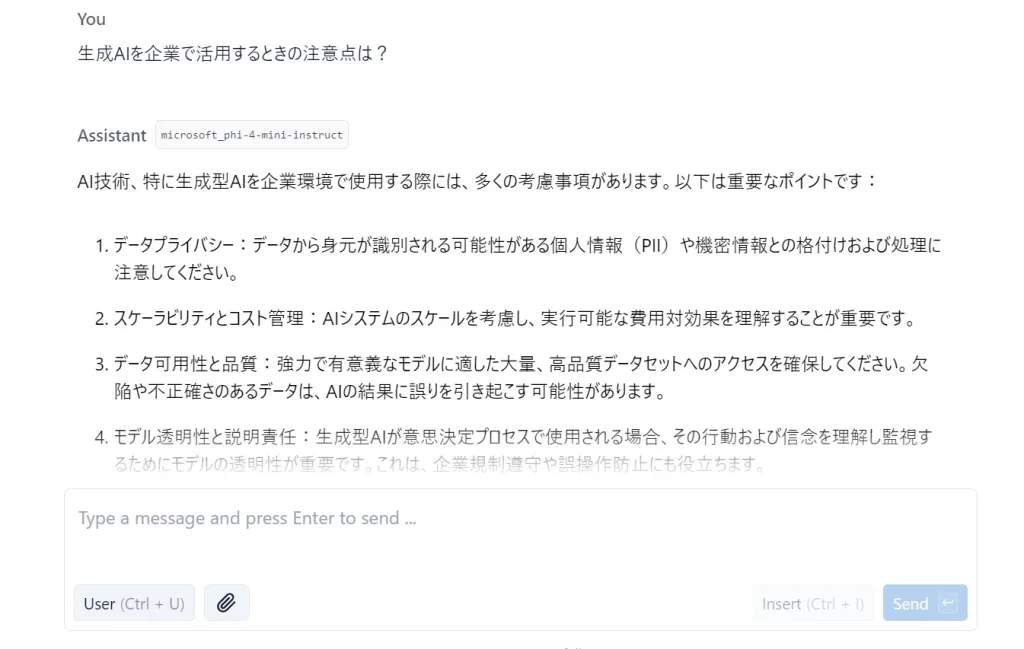

GPUを搭載していないノートPCでも、それほど遅くないスピードで文章を作成してくれます。

Ollamaを使ったインストールと使用方法

1. Ollamaのインストール

- Windowsの場合: Ollama公式サイトからインストーラーをダウンロードし、実行ファイルをインストールするだけで完了します。

- macOSの場合: ダウンロードしたファイルを解凍し、アプリケーションフォルダにドラッグ&ドロップ。

- Linuxの場合: ターミナルで以下を実行します。

nginxcurl -fsSL https://ollama.com/install.sh | sh

2. バージョンの確認

Phi-4-miniはOllamaのバージョン0.5.13以降で動作がサポートされています。Ollamaのリリースページなどで最新バージョンを確認し、必要に応じてアップデートしましょう。

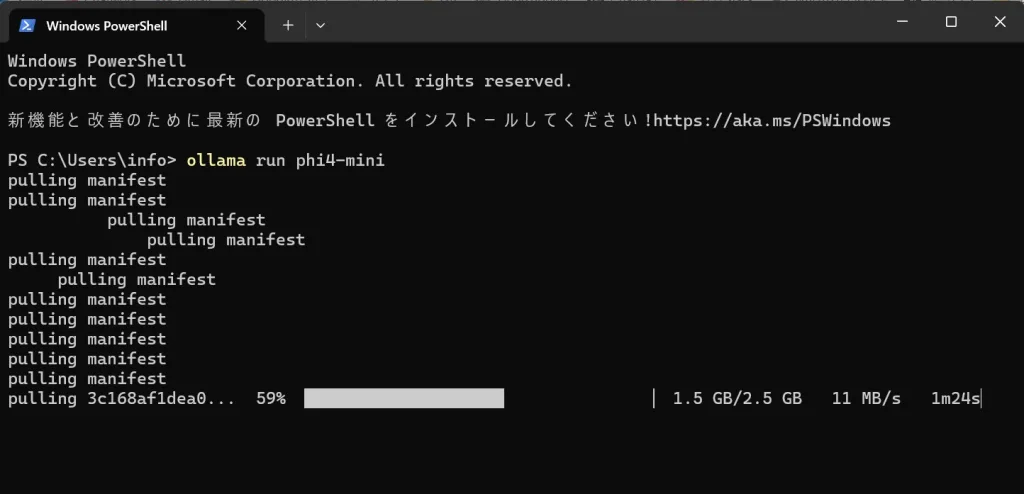

3. モデルのダウンロード

ターミナル(またはコマンドプロンプト)を開き、下記コマンドを入力します。

ollama pull phi4-mini

これでモデル本体がダウンロードされます。

4. モデルの実行

ダウンロード完了後、以下のコマンドを実行してモデルを起動し、インタラクションを開始できます。

ollama run phi4-mini

これでターミナル上で質問やコマンドを入力し、Phi-4-miniと対話できるようになります。

ハードウェア要件

- 推奨GPUメモリ: 8GB以上

- 最小RAM: 8GB

- CPUのみの運用: 可能だが推論速度は低下の恐れあり

Phi-4-miniは3.8Bパラメータを持ち、BF16精度を使用しているため、単純計算でもモデルウェイトに約7.6GBが必要です。

推論時には追加のメモリも使用するため、GPUを搭載していると快適に動作します。もし古いGPU(例:V100)を使用する場合は、attn_implementation="eager"の設定が必要になる場合があります。

Phi-4-miniの意外な注目ポイント

- 省リソースながら高性能:

- 3.8Bパラメータという小さなサイズでありながら、大規模モデルと肩を並べる推論能力を持つ点は驚きです。特に推論や数学、コーディングなど、知識を大量に詰め込むよりも「推論力」が重要なタスクで威力を発揮します。

- 初心者でも扱いやすい:

- Ollamaを使えば、モデルのダウンロードや実行はコマンドライン数行で完了します。これまでは「専門家向け」と思われがちだったローカルAIが、一気に身近な存在になるでしょう。

- 多言語対応の可能性:

- トレーニングデータの8%程度に多言語データが含まれるため、英語以外にもある程度対応が期待できます。ただし、本格的な多言語対応を求める場合は専門の多言語モデルのほうが優位なケースもあります。

Phi-4-mini:まとめ

Phi-4-miniは、軽量モデルでありながらも優れた推論性能を示す注目のオープンソースAIです。Ollamaの活用でインストールや実行が容易になり、プライバシーを確保しながら自由にAIを活用できる点が大きな魅力といえます。

今後さらにバージョンアップやコミュニティによる改善が見込まれ、個人や小規模チームが手軽に高度な推論を行うための選択肢として広がっていくでしょう。