「もっと手軽に、あの高性能AIを使えたらいいのに…」

そう思ったことはありませんか? 実は、そんな夢を叶えるかもしれない、AI軽量化の最新技術が開発されたのです。それが今回ご紹介する「TAID(Temporally Adaptive Interpolated Distillation)」、日本語で言うと「時間適応型補間蒸留」です。

この記事を読めば、TAIDが一体何なのか、なぜ画期的なのか、そして私たちの未来にどんな影響を与えるのか、非エンジニアの方にもきっとご理解いただけるはずです。

TAIDの応用例

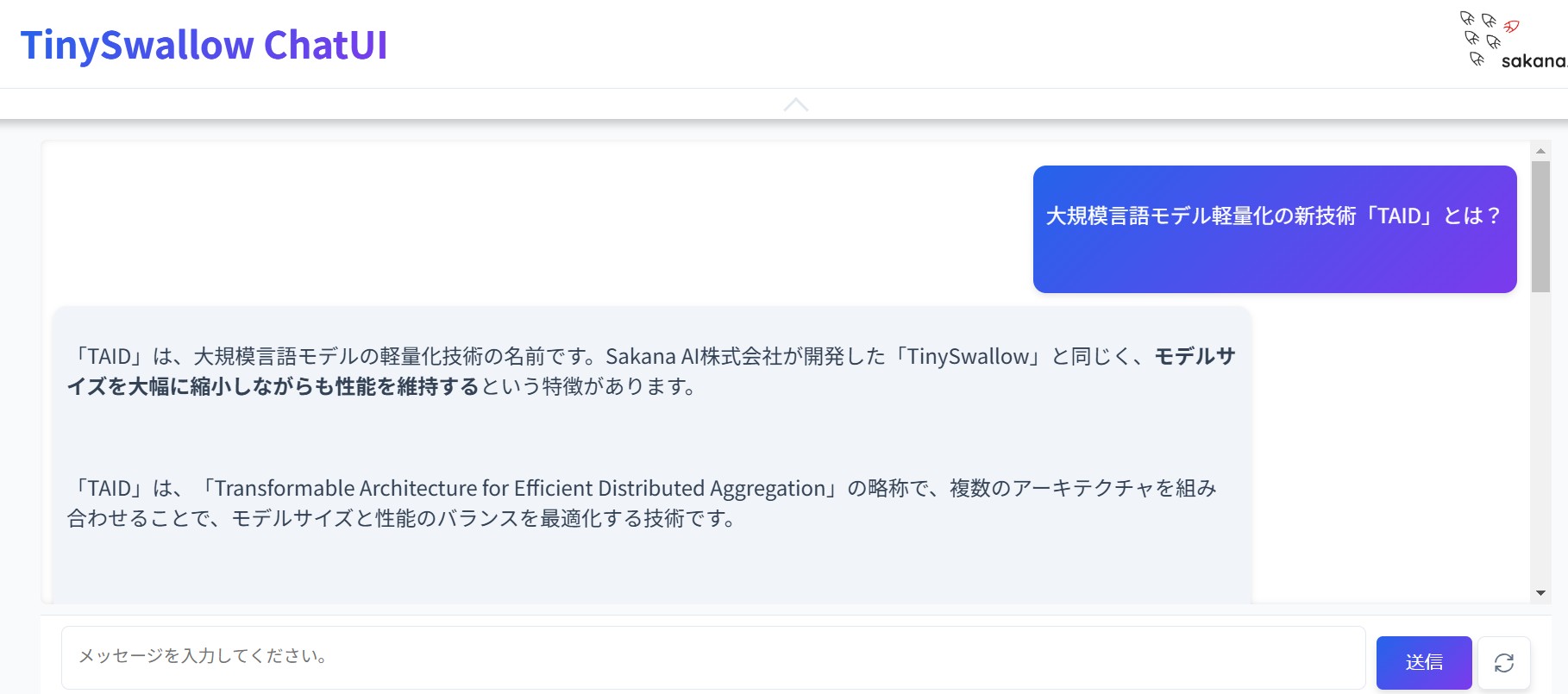

Sakana AI社によって、日本語の小規模言語モデル「TinySwallow-1.5B」が開発され、同規模のモデルの中で最高性能を達成しました。

このモデルは、32Bパラメータの大規模言語モデル(LLM)からTAIDを用いて知識転移を行い、約1/20の規模である1.5Bパラメータに圧縮されています。

「TinySwallow-1.5B」は、小規模ながらも高いパフォーマンスを維持しており、外部APIを利用することなく、スマートフォンやPC上で直接チャットを実行できる点が特徴です。現在、ウェブアプリを通じてブラウザ上で動作するチャットアプリが公開されており、実際の使用感を試すことができます。

デモ: https://pub.sakana.ai/tinyswallow/

知識の「蒸留」でAIをコンパクトに

TAIDを理解する上で、まず知っておきたいのが「知識蒸留(Knowledge Distillation)」という技術です。これは、まるで熟練の職人(教師モデル)の技を、見習い(生徒モデル)に効率的に伝授するようなもの。巨大で高性能なAIモデル(教師モデル)から、その知識や能力を抽出・圧縮し、小型で軽量なAIモデル(生徒モデル)に移し替える技術なのです。

知識蒸留のメリットは明らかです。AIモデルを小さくすることで、動作に必要な計算資源やエネルギーを大幅に削減できます。

これにより、スマートフォンやエッジデバイスなど、限られた環境でも高性能なAIを利用できるようになるのです。しかし、知識蒸留には課題もありました。

知識蒸留の課題:先生と生徒の「ギャップ」

従来の知識蒸留では、教師モデルと生徒モデルの間に大きな「ギャップ」があると、上手く知識を伝えられないという問題がありました。

1. 能力ギャップ

教師モデルは非常に賢く、生徒モデルはまだまだ未熟。例えるなら、大学教授の知識を小学生に教えるようなものです。いきなり高度な内容を詰め込もうとしても、生徒はパンクしてしまいます。

2. モード平均化とモード崩壊

教師モデルは色々な知識を持っていますが、生徒モデルはキャパシティが小さいため、全てを完璧にコピーすることは困難です。

無理に全部を平均的に学ぼうとすると、どれも中途半端になってしまう「モード平均化」や、逆に一部の知識に偏ってしまい、他の重要な知識を見落としてしまう「モード崩壊」といった現象が起こりがちでした。

これらの課題が、知識蒸留によるAI軽量化の壁となっていたのです。

TAID:賢い家庭教師が「ギャップ」を埋める

そこで登場したのが、新しい知識蒸留技術「TAID」です。TAIDは、これらの課題を克服するために、まるで優秀な家庭教師のようなアプローチを採用しました。

TAIDの最大の特徴は、「時間適応型」という名前の通り、生徒モデルの成長に合わせて、教え方を柔軟に変える点です。

1. 中間的な先生を用意

TAIDは、教師モデルと生徒モデルの間に、時間とともに変化する「中間的な先生」 を用意します。最初は生徒モデルに近い、易しい先生からスタートし、生徒の理解度に合わせて徐々に教師モデル(本物の先生)に近づけていくのです。

2. 段階的なレベルアップ

生徒モデルは、まず易しい中間的な先生から基礎を学びます。そして、徐々に難易度を上げていくことで、無理なく、着実に教師モデルの知識を吸収していくことができます。

3. モード崩壊を防ぐ

TAIDは、最初から教師モデルの全てをコピーしようとするのではなく、生徒モデル自身の個性や得意分野を尊重しながら、徐々に教師モデルの知識を統合していきます。これにより、モード崩壊を防ぎ、バランスの取れた学習を促すことができます。

TAIDは、まさに生徒モデルと教師モデルの「ギャップ」を埋める、賢い家庭教師のような役割を果たすのです。

実験で証明されたTAIDの驚くべき効果

研究チームは、TAIDの効果を様々な実験で検証しました。その結果、TAIDは従来の知識蒸留技術を大きく上回り、より高性能で軽量なAIモデルを生成できることが明らかになりました。

特に注目すべきは、教師モデルと生徒モデルの能力ギャップが大きいほど、TAIDの効果が顕著になる点です。これは、TAIDがまさに「ギャップ」を埋めることに特化した技術であることを示しています。

さらに、TAIDを活用して開発された「TAID-LLM-1.5B」と「TAID-VLM-2B」という2つの軽量AIモデルは、それぞれ言語モデルと vision-language モデルの分野で、既存の最先端モデルを凌駕する性能を達成しました。これは、TAIDが単なる理論だけでなく、実用的な効果も非常に高いことを証明しています。

TAIDが拓く、AIの民主化

TAIDの登場は、高性能AIをより身近な存在にするAIの民主化を大きく前進させる可能性があります。

- エッジAIの進化:

- スマートフォンやウェアラブルデバイスなど、リソースが限られた環境でも高度なAIが動作するようになり、場所を選ばずにAIの恩恵を受けられるようになります。

- 省エネルギーAI:

- AIモデルの軽量化は、AIの運用コスト削減だけでなく、消費エネルギー抑制にも貢献し、持続可能な社会の実現にも繋がります。

- AIの裾野を広げる:

- より多くの人々が、高性能AIを手軽に利用できるようになることで、AI技術の社会実装が加速し、新たな産業やサービスが生まれる可能性も広がります。

TAIDは、AI技術の可能性をさらに広げ、私たちの生活をより豊かにしてくれる、そんな期待を抱かせてくれる革新的な技術と言えるでしょう。

まとめ:TAIDはAIの未来を塗り替えるか?

今回の記事では、大規模言語モデル軽量化の最新技術「TAID」について、その革新性や可能性を解説しました。TAIDは、知識蒸留における長年の課題であった「先生と生徒のギャップ」を克服し、より高性能で軽量なAIモデル開発を可能にする画期的な技術です。

TAIDのような技術革新によって、AIはスーパーカーから、もっと手軽で燃費の良い、誰もが運転できる 「AI版の大衆車」 へと進化していくかもしれません。そして、AIがより身近になることで、私たちの生活は、より便利で、より豊かなものへと変わっていくはずです。TAIDが切り開くAIの未来に、大いに期待しましょう。