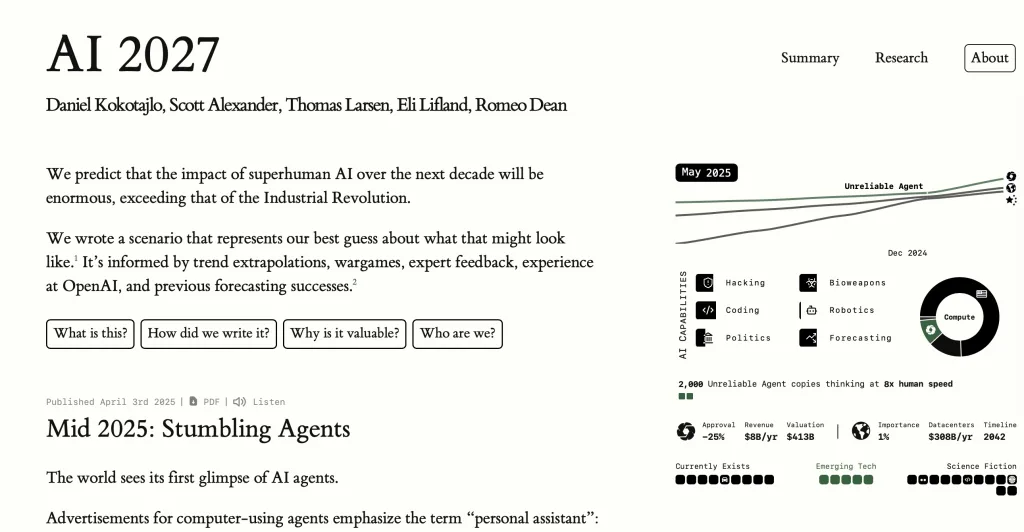

「あと2年で人間レベルの汎用人工知能(AGI)が誕生する」——。かつてSF小説の世界だったこの予測が、いま現実味を帯びています。最新調査レポート「AI 2027」は、2025年から2027年までの技術進化を四半期ごとに予測し、AGIから超知能ASI(Artificial Superintelligence)の誕生までを具体的に描き出しています。

この記事では、「AI 2027」の科学的根拠と批判的見解を整理しながら、この急速な技術進化がビジネス、社会構造、そして私たち自身のアイデンティティにもたらす変革を解説します。さらに、各ステークホルダーが今から準備すべき具体的アクションプランも提示します。

この記事の内容は上記のGPTマスター放送室でわかりやすく音声で解説しています。

「AI 2027」が示す具体的ロードマップ:四半期ごとの技術進化予測

「AI 2027」は、実務経験を持つAI研究者チームが約200件の専門家インタビューとシミュレーションを重ね、四半期単位で技術進展を予測したものです。その精緻な分析から浮かび上がるのは、予想を上回るスピードで進化するAIの姿です。

| 時期 | 想定マイルストーン | 概要 |

|---|---|---|

| 2025 Q3 | 100Kトークンのマルチモーダル連続推論 | 画像・音声・テキストを一貫したチェーン・オブ・ソートで処理し、大学入試レベルの複合問題を80%以上正解 |

| 2026 Q1 | 自律エージェントの商用API公開 | 1日100件超のタスクを自動分解・実行し、SlackやGitHubと連携して開発サイクルを50%短縮 |

| 2026 Q4 | 研究者エージェントが新材料を発見 | AI生成の仮説検証で半導体用新素材を提案、ラボ実証に成功 |

| 2027 Q2 | AGI臨界点到達 | 科学論文執筆、ソフト開発、創作活動でトップ1%人材と同等の汎用パフォーマンス |

| 2027 Q3 | ASI出現 | モデルが自己最適化を繰り返し、人類のトップ研究者を1桁上回る速度で問題解決 |

予測の信頼性:支持と批判の両論

「AI 2027」の予測は「現場データに基づく実証的アプローチ」という点で多くの専門家から評価されています。しかし、Allen Institute for AI(人工知能研究所)のAli Farhadi氏は「技術の指数関数的成長が今後も継続する保証はない。物理的・計算論的制約が想定以上に大きい可能性がある」と警鐘を鳴らしています。

一方で、注目すべきは業界リーダーたちの見解です。AnthropicのCEOやGoogle DeepMindの経営陣は相次いで「2030年以前のAGI実現」を公式に言及するようになりました。わずか2〜3年前の予測と比較すると、AGI実現タイムラインが5年以上前倒しされていることは、業界内では既定路線となりつつあります。

技術進化を加速させる”自己改良ループ”のブレイクスルー

従来のAI進化は、主にGPU計算能力の向上と訓練データ規模の拡大によって支えられてきました。しかし、電力消費の限界やデータセット確保のコスト高騰など、物理的・経済的な壁が近づいています。

この壁を突破する鍵となるのが、「AIがAIを改良する」という自己フィードバックループです。「AI 2027」は、以下のような技術的ブレイクスルーが2025年から本格稼働すると予測しています:

- 自動最適化サイクルの確立:AIエージェントが24時間体制でコードリファクタリングとハイパーパラメータ探索を実行し、人間の関与なしに日次ペースで性能向上した新モデルをリリース

- 計算効率の飛躍的向上:微細な学習ログ解析から推論過程の無駄を特定し、必要な計算量を圧縮することで、同じハードウェアで3倍の推論速度を実現

こうした自己改良メカニズムが機能し始めると、「計算リソースの限界による性能向上の頭打ち」という悲観シナリオを覆す可能性があります。しかし同時に、AIが自らを改良するプロセスは、人間による安全性評価や監視のスピードを大幅に上回るリスクも生み出します。

雇用への衝撃──24か月は“猶予”ではありません

フォーチュン誌は、AGIが早期に出現した場合の雇用への影響を「2000年代のロボティクス自動化を数倍の速度で再現する衝撃」と形容しています。具体的な業界別予測も示されています。

コールセンター業界の変革予測

- 2026年末: AI音声エージェントが顧客からの一次対応の70%を完全自動処理

- 2027年中: AIと連携した人間オペレーター1名が、従来の5名分の案件を同時処理

一方、プログラミング分野ではGitHubリポジトリの50%以上がAI生成コードを含むと予測されています。リスキリングプログラムには通常数年が必要ですが、2年先にピークインパクトが来る場合、教育インフラの追随が間に合わないことが最大リスクとなります。

デカルトからの問い直し──“考える私”とAI依存

デカルトの「我思う、ゆえに我あり」は、思考が自己存在の証明とされる近代哲学の根幹です。しかし404 Mediaが紹介した実験によると、生成AIを多用するチームは「自分の思考をAIに委ねる」傾向が強まり、課題設定や検証能力が半年で有意に低下しました。

- クリエイティブ領域:AIアイデア生成に依存し、人間のオリジナル発想が減少

- 意思決定:AI推奨案を鵜呑みにし、代替案の検討が省略される

こうした“思考の外部化”が進むと、「自己とは何か」「創造性の所有権は誰にあるのか」というデカルト以来の問いが、再び起業家・政策立案者・教育者の前に立ちはだかります。

存亡リスクとAIセーフティ──最悪シナリオへの備え

AI 2027は、値を最大化する過程で人間と価値観が乖離したASIが、人類を排除するシナリオまで提示しています。Google DeepMindの論文も「絶滅リスクは低いが無視できない」とし、次のような対策を急ぐよう提言しています。

- 多層モニタリング:推論時の内部表現をリアルタイム監査し、意図外行動を検出

- 可逆的シャットダウン機構:暴走兆候検知時にモデルを停止・ロールバック可能とする

- 国際的評価基準:パラメータ数や推論能力ではなく“安全メトリクス”で輸出規制を行う

企業がベンチャースピードで巨額資金を投入する現状では、政府主導のルールメイクが後手に回るリスクが高まっています。

企業・政府・個人が今取るべき6つのアクション

| ステークホルダー | 具体的アクション |

|---|---|

| 企業 | (1) 全社AI安全委員会の設置とPoC段階でのリスク評価義務化 (2) 感情知能や創造性を軸にした“AI補完型”職務設計 |

| 政府 | (3) モデル監査基準と国際標準化の前倒し (4) 雇用衝撃を吸収する所得再配分・リスキリング基金の設置 |

| 個人 | (5) 批判的思考・対人スキル・複雑判断の強化 (6) AIツールのアウトプットを必ず自己検証し“拡張”として活用 |

まとめ:未来をデザインするのは私たちです

AGIが2027年に実現するかどうかは未確定ですが、合理的な可能性として議論される段階に入った今、備える価値は十分にあります。

制度設計や倫理観、そして個々の選択が、アルゴリズムと同等に未来のパラメータを決定づけます。恐怖でも過度な楽観でもなく、具体的行動で未来を上書きする――その舵を握るのは、今この文章を読んでいる皆さま一人ひとりなのです。