急速に進化を続けるAIの世界において、新たに登場した「QwQ-32B」は、企業や開発者にとって画期的な選択肢となり得るモデルです。本記事を読むことで、最先端の推論モデルを活用し、生産性や問題解決能力を飛躍的に向上させる方法が見えてきます。

QwQ-32Bとは何か?

QwQ-32Bは、中国の大手EC企業アリババが開発・提供するオープンソースの大規模言語モデル(LLM)ファミリー「Qwen」の一角を担う推論特化型モデルです。

QwQは「Qwen-with-Questions」の略称で、初期版ではすでに32億(※正しくは「32B=320億」)規模のパラメータと3万2千トークンを扱える長いコンテキストが注目を集めていました。今回リリースされたQwQ-32Bは、その推論能力をさらに高めるために強化学習(RL)を活用し、複雑な問題の解決性能を底上げしています。

QwQ-32Bの特徴

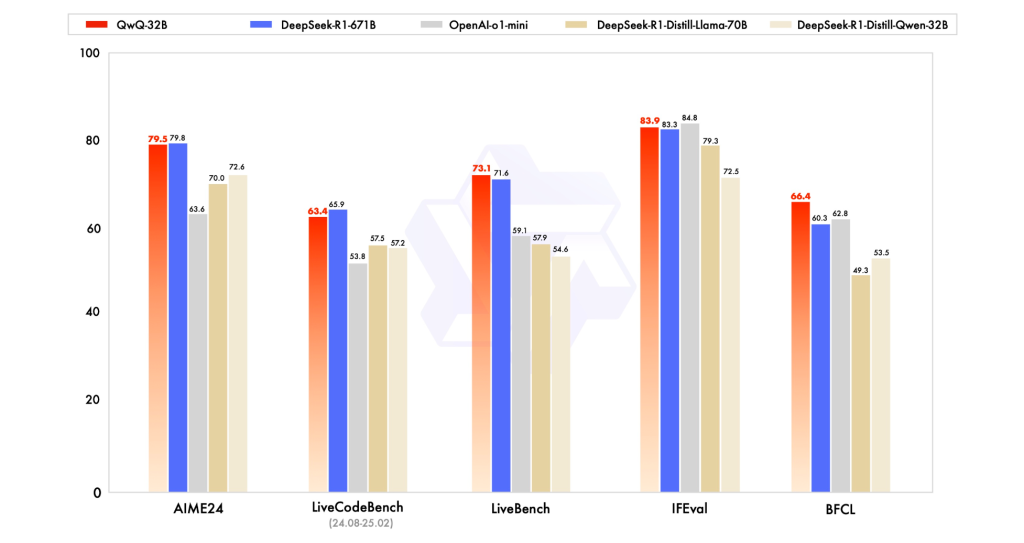

QwQ-32Bの最大の特徴は、大規模なパラメータを持ちながらもDeepSeek-R1クラスのモデルと同等の性能を示す一方、はるかに少ない計算資源で動作できる点にあります。

多段階の強化学習アプローチや、数々のアーキテクチャ的工夫によって実現されており、限られたGPUリソースしか利用できない企業や開発者にとって大きなメリットとなっています。

QwQ-32Bを無料で試すには?

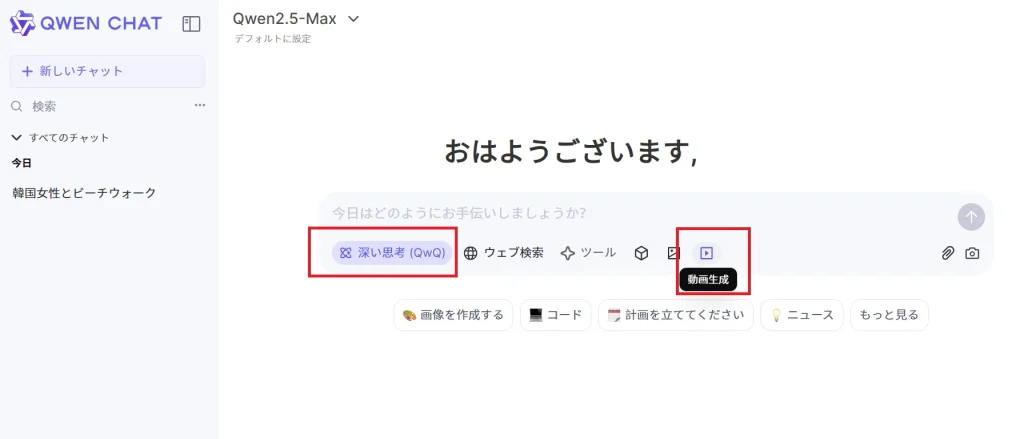

QwQ-32Bを試すには、Qwen Chatのサービスを利用してみてください。詳しい解説は以下の記事にあります。深い思考(QwQ)モードをOnにすると、QwQ-32Bを使うことができます。

Apache 2.0ライセンスで商用利用も可能

QwQ-32BはApache 2.0ライセンスで公開されているため、研究目的だけでなく商用利用も含めた幅広い用途に対応できます。これにより、自社製品に組み込んだり、特定業務領域向けにファインチューニングを行ったりと、自由度の高い展開が可能です。

さらに、Hugging FaceやModelScopeといったプラットフォームからも利用可能で、エンジニアリングに必要な導入コストを大幅に削減できます。また、個人ユーザー向けにもQwen Chatを通じたアクセスが提供されており、誰でも手軽に最新の推論性能を体験できる点も魅力です。

QwQ-32Bの開発背景

従来のLLMの課題

QwQが登場する以前の大規模言語モデルは、パラメータ数をひたすら増やす「スケーリング」で性能向上を目指してきました。しかし、モデルサイズを拡大するほど学習コストや運用コストが膨れ上がり、コスト対効果の観点から限界が見え始めていたのも事実です。

推論モデルの台頭

こうした背景から、いわゆる「推論モデル(Reasoning Model)」が注目を集めるようになりました。

推論モデルは、推論時に自ら質問を投げかけたり、回答候補を検証したりといった自己反省・自己評価のプロセスを組み込むことで、精度を高めるアプローチを取ります。QwQ-32Bはまさにこのカテゴリに属し、複雑な数式計算やプログラミングタスクなどに強みを発揮します。

強化学習による性能向上

QwQ-32Bの学習プロセスは、大きく二段階の強化学習ステップに分かれます。

- 数学・コーディング特化の学習:数式回答の正確性を評価する「正答検証器」と、コーディングタスクの正否を判定する「コード実行サーバ」を活用し、誤答を最小限に抑えつつモデルをトレーニングします。

- 汎用能力の強化:一般的なリワードモデル(報酬モデル)やルールベースの検証システムを用いて、数学やコーディング以外のタスクに対しても的確に対応できるよう調整します。この段階では人間の指示に対する応答精度や、言語的な自然さの向上も重視されます。

企業にとっての導入メリット

運用コストの低さ

DeepSeek-R1のような競合モデルと比較すると、QwQ-32Bは必要とするGPUメモリ量が大幅に少なく、推論処理に必要なリソースを24GB程度に抑えられる場合もあります。

一方、DeepSeek-R1はフル稼働には複数の高性能GPUを束ねる必要があり、推論コストも高額です。

ドメイン特化のチューニング

Apache 2.0ライセンスのもと、自社のデータや要件に合わせたカスタマイズが可能です。金融モデリングや顧客サポート、戦略立案など、さまざまなビジネス領域で効果的に活用できる柔軟性が魅力といえます。

セキュリティとオフライン運用

「中国企業製のモデル」という点を懸念する声もあるかもしれませんが、Hugging Faceなどからモデルデータをダウンロードしてオフライン運用が可能です。外部APIにアクセスしない環境で運用すれば、機密データや顧客情報が外部に流出するリスクも最小限に抑えられます。

初期反響と導入事例

公開直後から、多くのAI研究者や開発者がソーシャルメディアで好意的な感想を投稿しています。

とくに「推論スピードが非常に速い」「モデルサイズが小さいにもかかわらずDeepSeek-R1に匹敵する性能を出す」といった評価が目立ち、Hugging Faceのエンドポイントを使った簡易デプロイも好評です。

エージェント機能と今後の展望

QwQ-32Bは単にテキスト生成や質問応答を行うだけでなく、状況に応じて推論プロセスを動的に調整できる「エージェント機能」も備えています。推論を重ねながら必要な情報を取得し、自ら考え方を修正していく能力は、将来的な人工汎用知能(AGI)への布石といえるでしょう。

今後は、より高度な強化学習手法やエージェント技術との統合が進み、より長期的・複雑なタスクに取り組めるモデルへと進化していくと予想されます。

QwQ-32B:まとめ

QwQ-32Bは、少ないリソースで高い推論性能を発揮できる大規模言語モデルとして、エンタープライズから個人ユーザーまで幅広い層の注目を集めています。

Apache 2.0ライセンスのオープンソース提供、強化学習による柔軟性と正確性、そして汎用的なエージェント機能の実装など、次世代AIに求められる要素を多く備えています。競合が激化するAI市場において、「使いやすさ」「コスト効率」「拡張性」を重視するのであれば、QwQ-32Bは有力な選択肢の一つとなるでしょう。

参考)QwQ-32B: Embracing the Power of Reinforcement Learning