ByteDanceのSeed-OSS-36Bが示す“長文×推論”の新定番

「社内の1,000ページ超のマニュアルやログを丸ごと読ませて、しかも“きちんと考えて”答えてほしい」──そんな現場の夢に、ひとつの答えが出た。

ByteDanceのSeed-OSS-36Bは、聖書約1,600ページ分にあたる512Kトークンの長文を扱いながら、推論やコーディングでも最新オープンソース勢の最有力に躍り出た。しかもApache-2.0で商用OK。この記事では、モデルの構成・性能・導入方法を要点と落とし穴まで含めて整理し、あなたのプロジェクトでどう生かすかの道筋を示す。

何が「新しい」のか:36B、512K、そしてApache-2.0

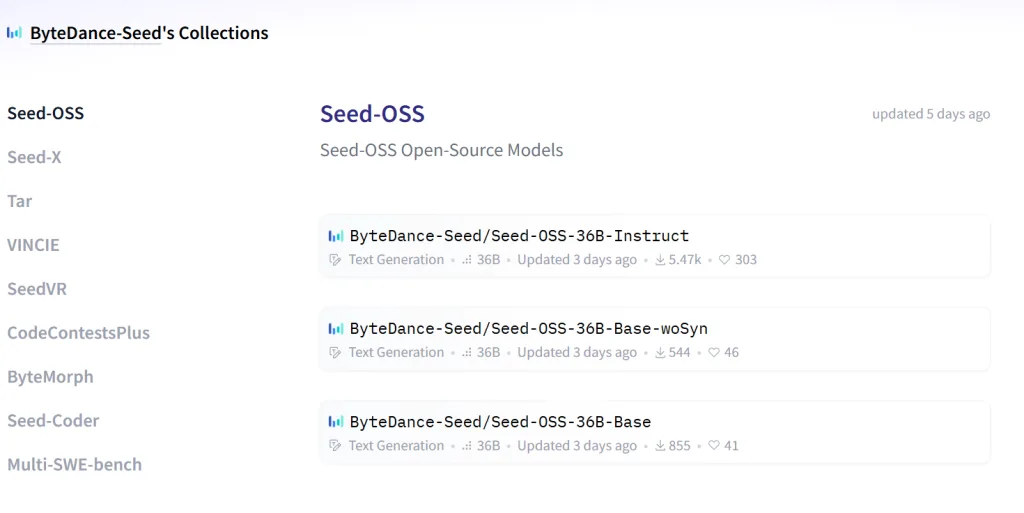

Seed-OSS-36Bは、36Bパラメータ/64層、RMSNormやSwiGLU、RoPE、GQAといった実績ある設計を採用し、語彙は約15.5万、コンテキスト長はネイティブに512K。公開はHugging Faceで、企業利用を含む改変・再配布が可能なApache-2.0ライセンスだ。

ByteDanceのSeedチームは2023年結成で、研究と実装の両輪を掲げている。まずここで押さえるべきは、「長文×推論」を前提にした設計と、法務・調達をシンプルにするライセンスの組み合わせにある。

512Kは何に効くか?GPT-5比「2倍」の文脈と実務インパクト

512Kは、OpenAIの最新ファミリー(GPT-5)比で「約2倍」と報じられており、実に聖書一冊強(約1,600ページ)を一度に処理できる規模だ。これにより、監査ログやコールセンタ記録、規程集、契約束一式といった「縦にも横にも長いデータ」を前処理で切り刻まずに投げられる。

ドキュメントQAの精度だけでなく、抜粋の“文脈ズレ”による事故も減り、レビューや調査の手戻りが小さくなる。規模の利益は推論でも効く。大量の前提資料を保持したまま「一回のターンで」検討を深められるため、手続き的なやり取りを減らし、担当者の待ち時間とAPI往復を同時に圧縮できる。

3つのバリアント:用途別に“土台”を選ぶ

Seed-OSSの構成は、以下の3系統。

- Base(合成データあり)

- Base-woSyn(合成データなし)

- Instruct

合成データありのBaseは標準ベンチマークで一段高いスコアを出し、ゼロショットでの“そのまま使える”性質が強い。

一方、woSynは合成指示の影響を避けた“きれいな土台”で、研究用途や追加事前学習(continued pretraining)に向く。

Instructは指示追従の後処理込みで、エージェント実装や業務タスクへの即応性を重視する。導入側の判断軸はシンプルで、「すぐ成果を出す=Base/Instruct」「評価や社内学習のベースラインを固める=woSyn」だ。

Thinking Budget:推論量をダイヤルで回すという発想

Seed-OSSがユニークなのは、回答までに費やす“思考トークン”を明示的に制御できる点だ。簡単なタスクは0(ダイレクト回答)で高速に、難問は512や1K、4K…と段階的に“考える長さ”を増やして品質を取りにいく。

推奨は512の倍数で、512未満なら0に寄せるのが設計意図。推論の長さと品質のトレードオフをUIやポリシーで運用できるため、SLAやコスト制約の厳しい現場では扱いやすい。A/Bで“適正思考量”を決めておけば、ピーク時の遅延やGPU利用の暴れを抑えつつ、必要な場面でだけ深い思考を解放できる。

ベンチマークの位置づけ:数学・コード・長文でSOTA級

公開スコアでは、InstructがAIME24で91.7%、BeyondAIMEで65、LiveCodeBench v6で67.4を記録し、オープンソースSOTA級の成績を示している。長文ベンチRULER(128K)でも94.6と最高水準。

Baseでは合成データありの変種がMMLU-Pro 65.1、MATH 81.7などを示し、逆にwoSynはGPQA-Dで優位に出る場面がある。要は「より強い即戦力」か「研究フレンドリーな中立土台」かで、好成績の出方が変わると理解すべきだ。いずれも36Bクラスでは十分に競合力がある。

デプロイのしやすさ:Transformers/vLLM、4bit/8bit量子化、そしてライセンス

導入面では、Transformersでの推論手順や4bit/8bitの量子化オプション、vLLMによるAPIサーバの構築例までがモデルカードにまとまっており、少人数チームでも大規模モデルの実験に入れる“段取りの良さ”が光る。

Apache-2.0は社内外の商用利用に適しており、API課金やベンダーロックのリスクを回避したいチームには魅力的だ。まずは8bitで試し、ロードマップ次第で4bitや分散推論へ広げる──そんな漸進導入が取りやすい点が、Seed-OSSの実務的な強みである。

企業が今やるべき評価設計:ユースケースと運用の写経

最後に、評価と導入の型を提示したい。第一に長文を活かす案件を選ぶ。監査・法務レビュー、ナレッジ横断QA、長期の顧客接点(ケース履歴)など、「切り刻むほど性能が落ちる仕事」を優先する。第二に、Thinking BudgetをSLA/コストに合わせて段階化し、プロンプトと一緒に“運用の一式”として版管理する。第三に、Base/woSyn/Instructのどれで始めるかを、ゼロショット品質と内製学習の計画で決める。

最後に、Apache-2.0の自由度をいかし、PIIや機密は自社境界内で扱う前提を崩さない。ここまで設計して初めて、「512Kで読んで、必要なだけ考える」というSeed-OSSの強みが、現場のROIに転化する。

参考)https://huggingface.co/collections/ByteDance-Seed/seed-oss-68a609f4201e788db05b5dcd