本記事では、Teslaのヒューマノイドロボット「Optimus」を例に挙げながら、“視覚データがAIの認識や推論をどう変えていくのか”を探ります。

視覚情報を取り込みながら学習を進めるAI

ChatGPTなどの生成系AIは、膨大なテキストデータを学習することで驚くほど多彩な文章生成能力を獲得してきました。

しかし、人間が日々の生活で利用している五感のうち、視覚・聴覚・触覚・嗅覚・味覚すべてを通じて世界を理解していることを考えれば、テキストのみで学習するAIは、どうしても世界認識モデルが限定的になりがちです。

そこで注目されるのが、自動運転車やヒューマノイドロボットなど、カメラによって視覚情報を取り込みながら学習を進めるAIの可能性です。こうしたAIは、視覚を活用することで、単なる「タスク遂行マシン」から「推論マシン」へと進化する潜在力を秘めています。

テキスト情報の限界とAGI(汎用人工知能)の目標

ChatGPTのような言語モデル(LLM)は、大量のテキストを基盤に学習を行います。そのデータは、ウェブページや書籍、学術論文、プログラムコードなど多岐にわたり、数十億〜数兆という膨大なパラメータを用いて人間のような文章生成や理解を可能にしています。

しかしながら、人間は文字情報だけで思考しているわけではありません。五感のうち、とくに視覚は圧倒的な情報量を持ち、環境との相互作用によって知識を深めていきます。五感の総合的な体験と比較すると、テキストのみを学習データとして扱う現在のAIモデルには自ずと限界があるのです。

そのため「人間のように理解し推論できる人工知能=AGI」を目指すうえで、視覚を中心とした複数の感覚データが不可欠であると考えられています。

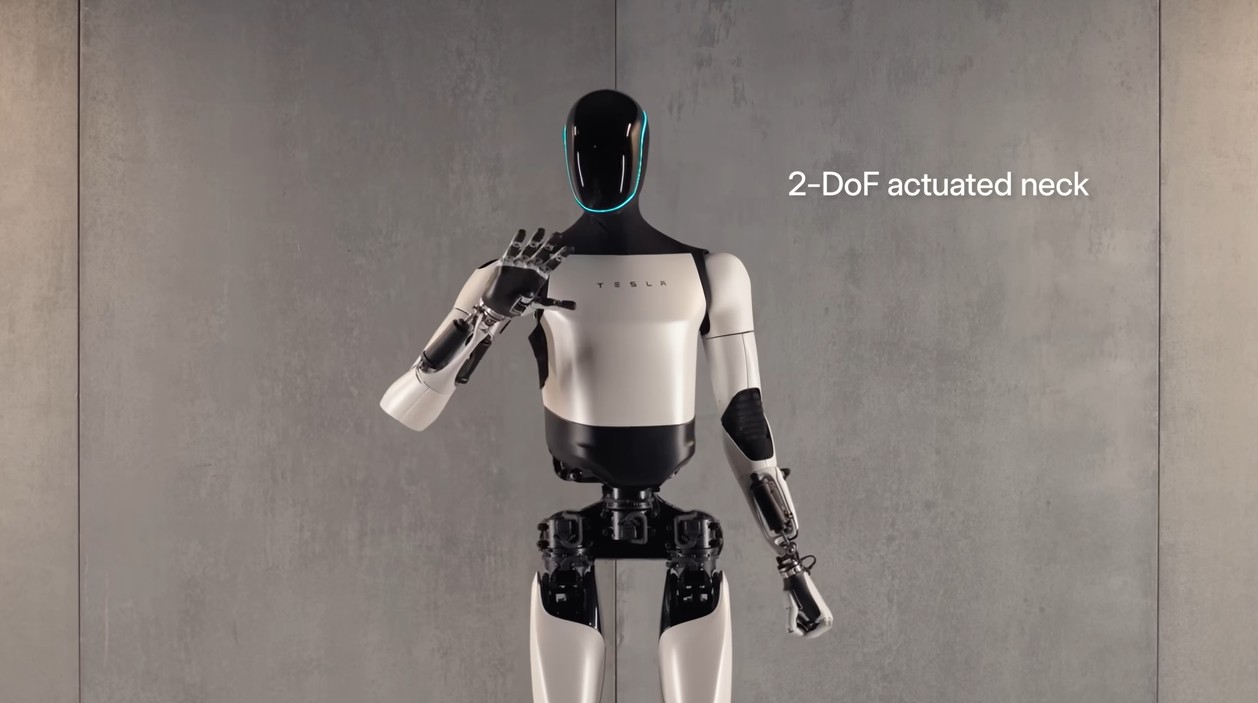

「見る」AI:Teslaのアプローチ

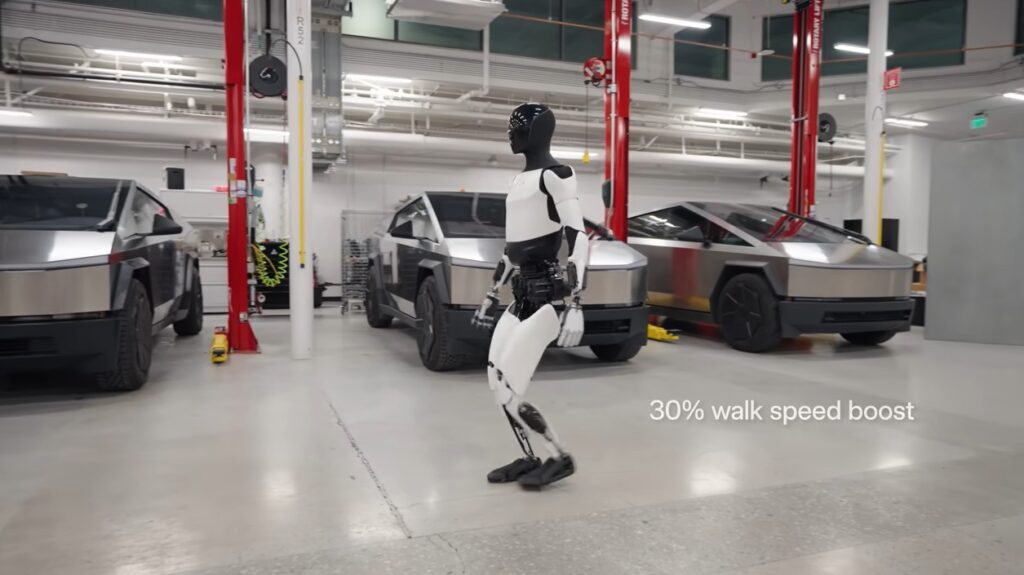

テキストベースのAIを手がけるxAI(Elon Musk氏が立ち上げた別企業)とは対照的に、Tesla AIは自動運転(FSD)やロボット(Optimus)のために「視覚認識とプランニング」を中心に据えたシステムを開発しています。

- Tesla AI

- 4輪のロボット(車両)と2足のロボット(Optimus)を制御するビジョンベースのAI

- 車載カメラやロボットのカメラからの映像を処理し、自律走行や作業計画を立案

- xAI

- LLM(大規模言語モデル)を中核にしたAI開発

- 「Grok」などのAIアシスタントをX(旧Twitter)に搭載

- Teslaへ技術ライセンスを行い、音声インターフェイス(音声→テキスト→音声)を実装

Tesla車とOptimusにはxAIの言語処理能力が統合され、人が声で指示したり対話したりできるようになります。そして、ロボットはその指示をもとに現実世界での作業を実行するのです。

視覚データの圧倒的な情報量

人間の五感のなかでも、視覚は圧倒的な情報量を取り扱っています。

- 視覚:10,000,000ビット/秒

- 聴覚や触覚:1,000,000ビット/秒

- 嗅覚:100,000ビット/秒

- 味覚:1,000ビット/秒

人間の脳は、網膜や各種神経を通して毎秒膨大なデータを受け取り、必要な情報に圧縮・優先度付けを行っています。この視覚の圧縮と抽象化こそ、人間が環境を把握・学習・推論する上で大きな役割を担っています。

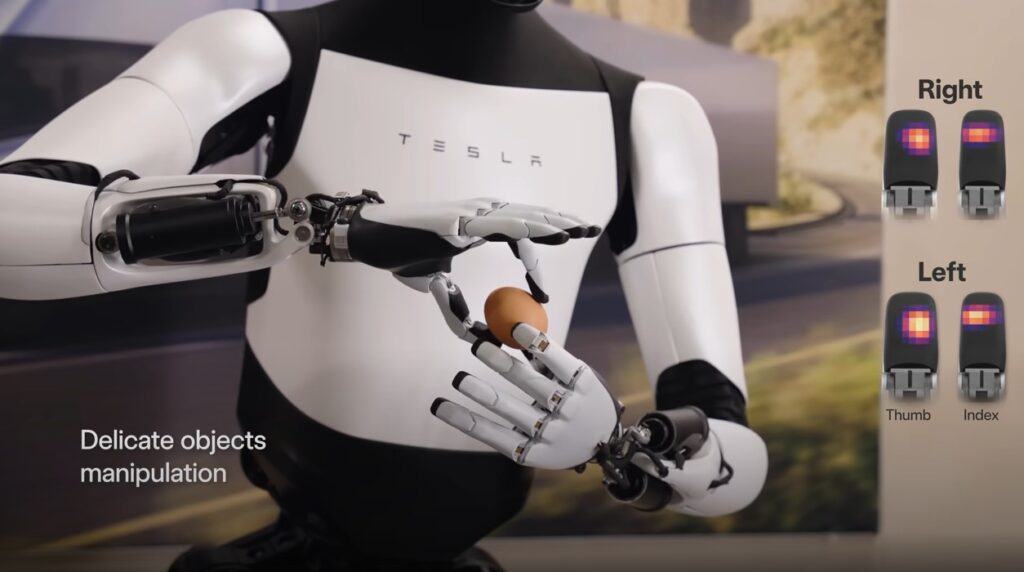

Optimusにも複数のカメラが搭載されており、高解像度かつ30〜60fps(またはそれ以上)で環境を“見る”ことができます。多くのロボットがそうであるように、彼らはテキストAIには存在しないような「高密度な視覚データ」を現場でどんどん集められるのです。

ロボットによる「深い観察」とスケーラブルな実験

視覚データを活かすAIロボットの強みは、単なる観察の量が多いだけでなく観察を実験に活かすことができる点にあります。たとえばFSDの開発では、走行データを膨大に収集し、危険なパターンを検証しながらモデルをアップデートするサイクルを繰り返してきました。

Optimusでも同様に、現場で新しい物体や作業手順を見つけたら、その場で学習し、必要に応じて試行錯誤を重ねることで最適解を見いだす可能性があります。これは人間が工夫や経験で仕事を改善していくプロセスに近いものです。

■ 例:葉っぱを数えるロボット

学校の理科研究で「木の葉が何枚出てきたか」を日々観察するのは、最初は簡単でも、葉の数が増えるにつれて人間では大変になってきます。ところが、ロボットなら一瞬で正確に数えられますし、さらに複数の場所で同時に計測することもできます。

これらを気温や湿度、日照時間などのデータと合わせれば、葉の成長メカニズムをより精密に解き明かせるでしょう。大規模な観察と実験が手軽に行えるようになることで、人類の科学研究が飛躍的に進むかもしれません。

■ 例:街を清掃しながら統計をとるロボット

街を掃除するOptimusが、同時に通行人の数や年齢層、衣服のブランド、利用するお店などをカウント・分類し続けるとしたらどうでしょう?都市計画からビジネス動向まで、より正確なデータを基にした意思決定が可能になります。

もちろんプライバシーやセキュリティの問題は大きいですが、視覚AIロボットが提供する「超大規模でリアルタイムな観察データ」は、これまで得られなかった知見をもたらすに違いありません。

中央集約型 vs 分散型(ハイブリッド)の学習

AIモデルの学習方式には、大きく分けて「中央集約型」と「分散型」があります。

- 中央集約型

- 大量のデータをクラウドやデータセンターに一極集中させ、強力なコンピュータリソースでモデルを学習

- 完成したモデルを車両やロボットにOTA(Over The Air)更新

- FSDの方式が典型例

- 分散型

- ロボットや端末(エッジ)側で学習や微調整を行う

- 観察→実験→学習のサイクルをその場で実行できるため、リアルタイムにモデルが進化

- 通信環境に依存しないため、即時のフィードバックが可能

Optimusを含むロボット開発では、このハイブリッド型が有望とされています。日常のちょっとした学習(例:リンゴの皮を剥くか剥かないかなどの判断)をローカルで行い、重要な知見はクラウドで集約してグローバルモデルをアップデートする──この流れは人間同士が知識を共有し進歩していく過程にも似ています。

推論マシンとしてのOptimusの未来

Optimusは人型ロボットであり、人間のように振る舞うことが期待されます。最初は生産性向上のための「タスク遂行マシン」として導入されるでしょうが、大量の視覚データとリアルタイムな学習によって、いずれは推論と判断ができるマシンへと進化する可能性が高いのです。

- 視覚情報が生み出す豊富な文脈

- どのような物体があり、どう動き、どんな特徴を持っているのかを把握

- 一度に多数のパターンを見分け、長期的な変化や因果関係も分析

- 学習サイクルの高速化

- 新しい課題を見たら、試行錯誤で素早く対応法を見つける

- 必要ならクラウドを通じて他のロボットに学習成果を共有

- AGIへの布石

- 視覚主体のロボットがテキストベースの知識だけでは到達できない実世界の洞察を獲得する

- この実世界の理解が、真の汎用性(AGI)につながる

Tesla Optimusが切り開く新たな可能性:まとめ

文字データだけでなく映像や物理的な操作を通じて学習するロボットは、テキスト中心のAIが到達し得ない「深く、立体的な理解」を得られると考えられます。とくに、世界中の道路を走る自動運転車や、様々な場所で実際に作業を行うロボットが自律的にデータを集めることで、その優位性はより明確になるでしょう。

TeslaのOptimusやFSDは、その先陣を切る存在といえます。膨大な視覚情報を取り込み、リアルタイムに学習・推論しながら人間社会に溶け込んでいくロボットが増えれば、私たちの生活や産業構造は大きく変わるはずです。その未来では、人が一日がかりでやっとできる観察や研究を、ロボットが一瞬でこなし、さらに“最適解をどう導くか”をリアルタイムに考えてくれる──そんな世界がすぐそこまで来ています。

視覚データが紡ぎ出す新たなAIの進化に、ますます注目が集まることでしょう。

参考)Tesla Optimus: I know what I see