オープンソースの大規模言語モデル(LLM)市場は急速に発展し、Microsoft、Google、Meta、アリババなど大手テック企業から次々と新モデルが登場しています。この「群雄割拠」状態は選択肢の豊富さを意味する一方で、「実際のビジネスではどのモデルを採用すべきか」という読者からの問い合わせが急増しています。

本記事では、最新のオープンソースLLM4種類(Microsoft「Phi-4」、Google「Gemma3」、Meta「Llama3.3」、アリババ「QwQ」)と業界最大級のDeepSeek R1を、同一条件下で実際に稼働させ比較検証しました。とくに以下の4つの観点から各モデルの実力を徹底評価しています。

- 必要計算リソースと導入コスト

- 複雑問題に対する応答精度

- 実用的な処理速度

- 日本語対応とコード生成能力

ビジネスでのAI導入を検討されている方々に、最適なモデル選択の指針となる情報をお届けします。

この記事の内容は上記のGPTマスター放送室でわかりやすく音声で解説しています。

今すぐ使える言語モデルはどれ?オープンソースLLMレビュー

オープンソースの言語モデルは、次から次へと新作が発表され、市場はまさに群雄割拠の状態です。読者から「どれを使うべきか」という問い合わせが多いのも当然でしょう。ここでは、最近試したモデルを比較しながら、その特徴をご紹介します。

評価方法:統一テストによる公平な比較検証

各モデルの真の実力を測定するため、単なるベンチマークスコアではなく、実用的な課題での性能を評価しました。中でも特に重視したのが以下の統一テストです。

1. 高度な推論力テスト:天文学的問題

「ある満月の夜、空を見上げると、月のすぐそばに火星が見えた。その時、地球と火星の距離は遠いのか近いのか?」

この問題は、単なる知識の再現ではなく、天体の位置関係を理解し論理的に推論する能力が問われます。満月時の地球・月・太陽の位置関係と、そこに火星が見える状況を正確に解釈できるかがポイントです。

2. 実用性評価の観点

- 必要メモリと実行環境:各モデルを動作させるために必要なGPUメモリと計算リソース

- 応答速度:実用的な質問に対する回答生成までの時間

- 日本語対応レベル:日本語での質問理解と自然な回答生成能力

- コード生成能力:p5.jsを使った魚群シミュレーションコードの生成テスト

1:DeepSeek R1-1776

| パラメータ数 | 約6,700億 |

|---|---|

| 必要メモリ | 1.5TB以上のGPUメモリ(ローカル実行は非現実的) |

| 開発元 | DeepSeek社(中国) ※R1-1776版はPerplexity AI社が調整 |

| 想定用途 | 高度な汎用知識応答・推論。R1-1776は検閲を排した全方位的な情報提供 |

特徴

- 現行最大級(約6,700億パラメータ)のモデルで、知識のカバー範囲と推論能力が極めて高い。

- 中国のAI企業DeepSeekが開発した基盤モデル(DeepSeek-R1)を米国企業が再調整し、検閲のない「R1-1776」としてオープンソース公開。

- 多言語データで学習済み(主に中国語・英語)で、政治・歴史などセンシティブな質問にも詳細な回答が可能。

- 豊富な世界知識と論理思考力を持ち、学術的な質問や高度な分析タスクにおいてもトップクラスの性能を発揮。

評価結果

- 天文学的問題への回答: 非常に詳細かつ正確な解説を生成。例えば、高度な天文学の質問に対し論文レベルの回答を返すことができた。一方で出力までに約60秒を要し、応答生成は大規模モデルゆえかなり遅い。

- 処理速度: 単一GPUでは事実上動作しないため、常に大規模クラスタ環境での利用が前提となる。高速な演算環境下でも応答に数十秒〜分単位を要し、リアルタイム対話には不向き。

- 日本語対応: 日本語での回答も可能だが、英語に比べると若干表現のぎこちなさが見られる。主要な知識は保持しているものの、日本語特有のニュアンス理解は限定的。

- コード生成テスト: 複雑なプログラミング課題にも概ね対応可能。テストでは基本的なアルゴリズムのコードを出力できたが、細部に誤りが含まれる場合があり、完全な正答には追加の指示や修正が必要となった。

総評

DeepSeek R1-1776は、現時点で最高峰クラスの汎用AIモデルであり、複雑な問題に対しても人間の専門家に匹敵する解答を生成できる点が大きな強みです。

ただ、その巨大小ゆえ運用コストと応答時間の面で実用上のハードルが高く、リソースが潤沢な研究機関や特定分野の高度分析用途に限られるでしょう。総じて、最大限の性能が求められる場面では圧倒的な力を発揮しますが、近年は軽量モデルの台頭によりその優位性を活かせるシナリオは限定されつつあります。

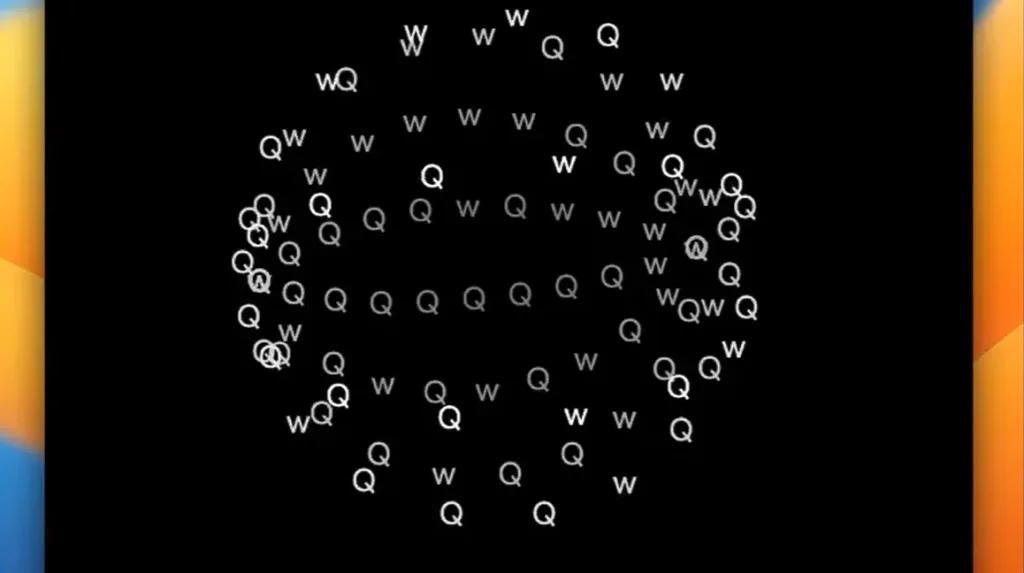

2:アリババ QwQ

| パラメータ数 | 約320億 |

|---|---|

| 必要メモリ | 約24GBのGPUメモリ(高性能GPU1台で実行可能) |

| 開発元 | アリババグループ(中国) |

| 想定用途 | 大規模モデルに匹敵する高度推論を低リソースで実現。企業向けAIアシスタントや高度な問題解決型サービスへの応用 |

特徴

- わずか320億という比較的小規模なモデルながら、高度な論理推論能力を持ち、超大規模モデル(DeepSeek R1など)に匹敵する性能を発揮。

- 必要VRAMは24GB程度と非常に軽量で、個人が利用できるGPU環境でも動作可能。これにより、高性能AIをより低コストで運用できる。

- 数学推論に特に優れ、難関ベンチマークテスト(MATH-500)で90.6%の正解率を記録(GPT-4クラスのモデルを上回る実績)。

- プログラミングコードの学習も取り入れており、コード生成やデバッグ支援など実践的タスクにも対応できる汎用性を備える。

評価結果

- 天文学的問題への回答: 複雑な質問に対して段階的に推論を試みたものの、テストでは回答に誤りが見られました。推論過程が長く(回答生成に約3分要したケースあり)、特定の専門知識分野では解答の正確性にばらつきがあります。

- 処理速度: 推論中に試行錯誤を行うためか、回答生成に時間がかかる傾向があります。ただしモデル自体が小型なため、ハードウェア要件に対する実行速度は許容範囲であり、工夫次第で応答時間の短縮も可能です。

- 日本語対応: 中国語・英語を主に学習していますが、日本語の質問にも一応対応可能です。基本的な内容は理解できますが、表現やニュアンスに若干の不自然さが残るため、日本語での高度な対話には追加チューニングが望ましいでしょう。

- コード生成テスト: プログラミング課題に対して正確なコードを比較的素早く生成しました。テストケースでは要求通りの解答コードを一回の試行で出力し、高いコード理解・生成能力を示しています。

総評

QwQ-32Bは、小規模ながらも一部のベンチマークで従来の巨大モデルを凌駕する注目のモデルです。数学やプログラミングといった論理性が要求される分野で高い能力を発揮する一方、専門知識の解答精度には課題も見られます。

軽量であるため自社サーバーや手元のハードウェアでも扱いやすく、コストを抑えて高度なAI機能を導入したい企業にとって魅力的な選択肢と言えるでしょう。

3:Meta Llama3.3

| パラメータ数 | 約700億(3.3版最大モデル) |

|---|---|

| 必要メモリ | 約140GB程度(FP16時、モデルサイズにより変動) |

| 開発元 | Meta社(米国) |

| 想定用途 | オープンソースの汎用言語モデルとして研究・開発用途全般。独自拡張や専用タスク向けのファインチューニングを想定 |

特徴

- Meta社がオープンソースで提供する基盤モデルであり、モデルの重みや実装が公開されているため、コミュニティによる改良や多様な応用が可能。

- 先進的な学習手法によりモデル効率が向上し、約700億パラメータの最新版(Llama3.3)で、以前の約4,050億パラメータモデル(Llama3.1)に迫る性能を実現。

- 複数のモデルサイズ(数十億〜数百億パラメータ級)が提供され、用途に応じて選択可能。加えて、対話向けに調整されたチャットモデルやコード特化型モデルなどの派生版も公開されている。

- 広範な知識と汎用能力を持ち、英語を中心に多数の言語での応答が可能(日本語についても基本的な会話程度は対応)。商用利用を含め、制約の少ないライセンス下で活用できる点も特徴。

評価結果

- 天文学的問題への回答: 高度な科学系の質問にも正確な回答を提示しました。テストでは天文学の専門的な問いに対し、的確な知識を用いた説明を行い、概ね正解を返しています。回答の詳細さはDeepSeek R1に僅かに及ばないものの、十分に信頼できるレベルです。

- 処理速度: 最新の70Bモデルでは単一GPUでの実行が難しいため、高性能GPUを複数用いた環境での利用が推奨されます。応答時間はモデルサイズに比例しており、最大モデルでは数十秒程度の遅延が見られましたが、小型モデルを選択することで応答を大幅に高速化できます。

- 日本語対応: 日本語については限定的ながら回答可能で、一般的な質問であれば理解して返答できます。ただし表現はやや直訳調になる傾向があり、微妙なニュアンスや敬語表現では専門の日本語調整モデルに劣ります。

- コード生成テスト: 一般的なコーディング問題に対して解答コードを生成できました。基本的なアルゴリズムの実装は示せるものの、最適化やエッジケースの処理に甘さが見られる場合があり、専用のコード特化モデル(例:Code Llama)に比べると精度は劣ります。

総評

Llama3.3はオープンかつ柔軟な高性能モデルとして、研究者や開発者に幅広い可能性を提供します。大規模モデルとしての性能は商用の最先端モデルに迫るものがありながら、オープンソースであるため自社ニーズに合わせた改変や専門分野への特化が行いやすい利点があります。

とはいえ、最大モデルの運用には依然として相応の計算資源が必要であり、用途に応じて小型版や派生モデルを使い分ける戦略が求められます。総じて、コミュニティ主導で発展するプラットフォームとして信頼性と拡張性が高く、長期的な視点での導入メリットが大きいモデルです。

4:Google Gemma3

| パラメータ数 | 約270億(最大モデル) |

|---|---|

| 必要メモリ | 約50GB(FP16時、GPU1台で実行可能) |

| 開発元 | Google DeepMind(米国) |

| 想定用途 | 高速・軽量な多言語対応モデルとして、オンデバイスAIやリアルタイム対話システムへの組み込み、分散型環境での利用を想定 |

特徴

- Googleの次世代モデル「Gemini」の技術を基に開発された軽量版で、テキスト処理に特化したオープンモデル。最大でも約270億パラメータと比較的小規模で、効率性を重視している。

- 非常に長いコンテキスト長(最大約128,000トークン)を扱えるよう設計されており、長文の文章解析や長時間の対話にも対応可能。

- 100言語以上の大量データで学習しており、多言語での自然な文章理解・生成を得意とする。特に英語以外の言語リソースが豊富な点で、他の英語主体モデルとの差別化を図っている。

- 実運用を意識したチューニングが施されており、回答の一貫性や無害性(ハラスメントや不適切発言の抑制)に配慮した応答を生成する。オープンソースで提供され、企業や開発者が自由にサービスに組み込める点も魅力。

評価結果

- 天文学的問題への回答: 専門的な科学質問にも簡潔ながら正確な回答を返しました。天文学に関するテスト質問では、要点を押さえた回答を約10秒程度で生成し、大きな誤りはありませんでした。ただし説明の深さは上位モデル(例:DeepSeek R1)に比べて簡潔です。

- 処理速度: 4つのモデル中もっとも応答が速く、軽量モデルの利点が顕著です。高性能GPU1台でリアルタイムに近いレスポンスが得られ、問い合わせへの待ち時間は極めて短く済みました。大規模データ処理においても安定した高速性を維持します。

- 日本語対応: 学習言語に日本語も含まれているため、日本語の質問にも自然に回答できました。文法や表現も適切で、日本語における応答品質は今回のモデル群の中でも良好な部類です。ただし高度な敬語表現や微妙なニュアンスの再現は完璧ではない可能性があります。

- コード生成テスト: プログラミングに関する問いには基本的なコードを生成できるものの、複雑な要求では不完全な回答となりました。テストでは単純なコードスニペットの作成はできましたが、アルゴリズムの詳細な実装やデバッグ能力は限定的であり、コード生成性能は他のモデルに比べ控えめです。

総評

Gemma3は、性能と効率のバランスに優れた実用志向のモデルです。高い応答速度と比較的低い計算資源で動作する点は、リアルタイム性が要求される対話システムや、クラウドに頼らないオンデバイスAIで大きな利点となります。多言語対応力も高く、日本語を含むグローバルなユーザー層に対して有用な応答を提供できるでしょう。

ただし、モデル規模が小さい分、専門知識の深い分析や創造的な文章生成では超大規模モデルに及ばない場面もあります。総じて、限られたリソース環境で信頼性のあるAI機能を実現したい場合に最適な選択肢です。

5:Microsoft「Phi-4」— 小型ながら驚異的な性能

| パラメータ数 | 14B(140億) |

| 必要メモリ | 9.1GB |

| 開発元 | Microsoft Research |

| 想定用途 | Copilot+ PC、エッジデバイス |

特長

- コンパクトなサイズながら、優れた応答精度と処理速度を実現し、実用レベルの性能を発揮。

- Microsoftが次世代のCopilot+ PCやエッジデバイスでの使用を想定して開発した軽量モデル。

- 必要メモリは約9.1GBと非常に少なく、一般的なGPU環境でもスムーズに動作可能。

- 高い日本語理解・生成能力を備えており、ローカル環境やオフライン運用にも適している。

- コード生成や実務レベルのタスクにも対応できるバランス型のオープンソースLLM。

評価結果

- 天文学的問題への回答:「地球と火星は比較的近い距離にある」という正解を的確に導き出し、現象の仕組みも簡潔かつ正確に説明。科学的な知識と論理性を兼ね備えた出力が可能。

- 処理速度:非常に高速で、応答生成までの待ち時間が短く、リアルタイム対話にも適している。今回のテスト対象の中でもトップクラスの軽快さを実現。

- 日本語対応:自然な日本語での質問・応答が可能。文法や表現の正確性も高く、日本語環境での実用性が十分に確認された。

- コード生成テスト:p5.jsによる魚群シミュレーションの指示に対して、初回で完全に動作するコードを出力。小規模モデルでありながら、実用レベルのプログラミング能力を有する。

総評

Phi-4は、必要リソースの少なさと高い性能のバランスが取れた「コスパ最強」のモデルといえます。特に限られたリソースでサービスを運用したい場合や、ローカル環境での使用に最適です。大規模モデルに匹敵する回答品質と、軽快な動作性能を両立させている点は高く評価できます。

各モデルの基本スペック比較

| モデル名 | パラメータ数 | 必要GPU メモリ | 開発元 | 主な特徴 |

|---|---|---|---|---|

| DeepSeek R1-1776 | 約6,700億 | 1.5TB以上 | DeepSeek社 (Perplexity AI調整) | 最大級の知識量と推論能力、検閲なし |

| アリババ QwQ | 約320億 | 約24GB | アリババグループ | 数学推論に優れた軽量高性能モデル |

| Meta Llama3.3 | 約700億 | 約140GB | Meta社 | 柔軟なオープンソースで改良可能 |

| Google Gemma3 | 約270億 | 約50GB | Google DeepMind | 多言語対応、長いコンテキスト処理 |

| Microsoft Phi-4 | 140億 | 9.1GB | Microsoft Research | 超軽量で高性能、エッジデバイス向け |

オープンソースLLMレビュー:まとめ

まとめると、現在もっともおすすめなのはMicrosoftのPhi-4かGoogleのGemma3です。必要メモリは9.1GBと17GBとコンパクトながら、回答精度やスピードのバランスが取れている点が魅力的。以前は大規模なパラメータ数を持つモデルが優秀というイメージがありましたが、今や小規模モデルでも難易度の高い質問に答えられる時代になっています。

実際に「月と火星が空で接近して見える状況は、地球から見て火星がほぼ太陽の反対側に位置する会合のタイミング」という天文的知識までカバーしているのには驚かされます。とくにphi4が生成するコードは、小規模ながら実運用にも耐えうる品質です。予算や環境に合わせてモデルを選ぶ際、phi4かgemma3をまずは候補に入れてみるとよいでしょう。

出典)週刊Life is beautiful 2025年3月18日号