最近のAI技術の進化スピードには、「ついていけない…」と感じる方も多いのではないでしょうか。しかし、新しいモデルを知り、その特性を理解することで、最先端のテクノロジーをいち早く活用できるようになります。

本記事では、OpenAIがリリースした最新のAI推論モデル「o3-mini」について、その魅力や使い方、競合状況との比較をわかりやすく解説します。数々のベンチマーク結果や価格面のメリットなど、気になるポイントをしっかり抑えられるので、読めば「AIをもっと活かしたい」という方へのヒントが見つかるはずです。

コスパ重視のAI時代へ!「o3-mini」がもたらす推論革命

OpenAIの最新推論モデル「o3-mini」の特徴

OpenAIが新たにリリースした「o3-mini」は、“推論特化型”のAIモデルです。従来の大規模言語モデルとは異なり、回答の際に自らを精査・検証(ファクトチェック)するプロセスを踏むことが特徴となっています。

とりわけ数学や物理、プログラミングといったSTEM分野での正確性を重視した設計がなされているため、より信頼度の高い結果を出せることが期待されています。

「o3-mini」のメリットと背景

- 精度重視の推論プロセス

大半の言語モデルは高速応答を重視するあまり、不正確な情報を返してしまうリスクがあります。しかし「o3-mini」は、あえて推論プロセスを挟むことで誤答を減らす工夫がなされています。 - スピードとコスト面のバランス

OpenAIの先行モデル「o1」シリーズと比較して、「o3-mini」は低コスト・高速処理を実現。外部テストでは、「o1-mini」よりも回答の質を優先しながらも約24%高速という結果を出しています。 - 競合状況

近年、中国のDeepSeekなどがAI開発を加速させており、OpenAIの競争力が注目を浴びています。そんな中で登場した「o3-mini」は、コストパフォーマンスの高さを前面に打ち出しており、DeepSeekの「R1」モデルと比べても魅力的な価格設定がなされていることも話題の一因です。

o3-miniの料金・利用方法

料金体系

- API利用料金

- 入力トークン(キャッシュ済): 100万トークンあたり0.55ドル

- 出力トークン: 100万トークンあたり4.40ドル

(1トークン=約0.75ワードの計算)

これは「o1-mini」の63%安、DeepSeekの「R1」とも十分に競合できる水準です。

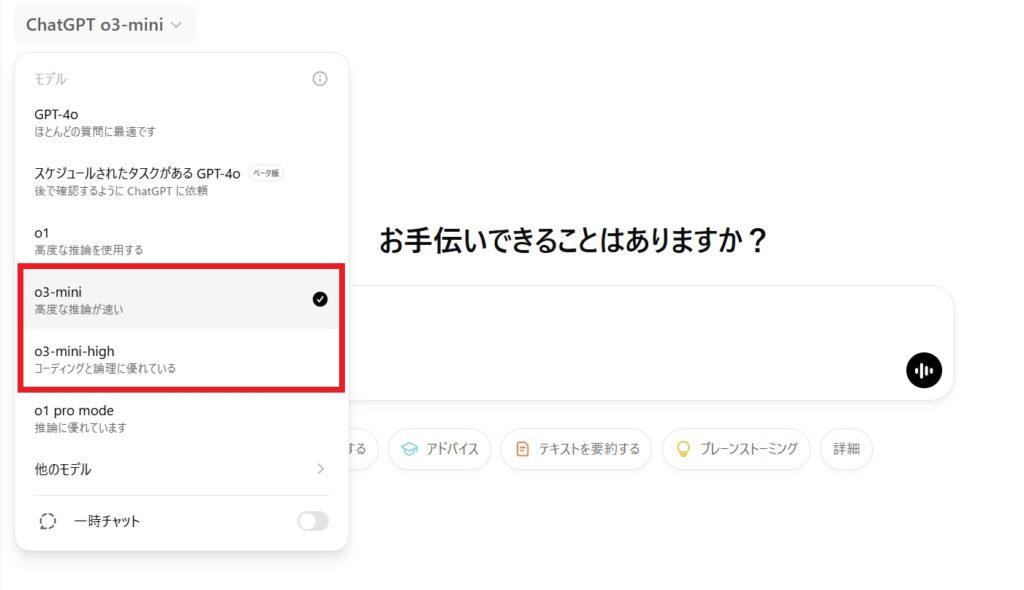

ウェブ版ChatGPTでの利用

- 無料ユーザー

「Reason」ボタンから利用可能。回答を再生成することで「o3-mini」の推論結果が得られます。 - ChatGPT Plus / Teamプラン

1日あたり150クエリまでの上限が設定されていますが、通常ユーザーより高い優先度・速度で利用可能。 - ChatGPT Pro

無制限のクエリ数が提供されるほか、今後は「ChatGPT Enterprise」「ChatGPT Edu」向けにも1週間以内に展開予定とのこと。

推論レベルの選択

- Low / Medium / High

「o3-mini」は、ニーズに応じて3段階の推論強度を切り替えられます。- Low: 高速化重視だが精度はやや低下

- Medium: バランス重視(ChatGPTでのデフォルト設定)

- High: 推論に時間がかかるが、より高精度

o3-miniで具体的な推論の質問を試してみた

問題文:

状況設定: Aさん、Bさん、Cさん、Dさんの4人がいる部屋に、1つの金庫があります。 金庫を開けるには特定のコードが必要で、そのコードを知っているのは4人のうちの1人だけです。 4人の中には1人だけ嘘をついていることがわかっています。

質問と回答者の発言:

Aさんは「Bさんがコードを知っている」と言いました。

Bさんは「Cさんがコードを知っている」と言いました。

Cさんは「Dさんがコードを知っている」と言いました。

Dさんは「私がコードを知っている」と言いました。

問題の提示:

誰が嘘をついているかを特定してください。

ちなみに、過去に同じ問題を試したところ、ChatGPT o1-preview では間違った答えを出しました。o3-mini pro は39秒ほど思考して、正しい答えを出しました。

以下、o3-mini highの回答

以下の条件を整理してみます。

- 部屋には A, B, C, D の4人がいます。

- 金庫を開けるコードを知っているのは4人のうち「1人だけ」です。

- 4人の発言のうち「1人だけ」が嘘(=発言が事実と異なる)であり、残りは正しいとします。

各人の発言は次の通りです。

- A: 「Bさんがコードを知っている」

- B: 「Cさんがコードを知っている」

- C: 「Dさんがコードを知っている」

- D: 「私がコードを知っている」

また、発言の真偽は以下のように解釈できます。

- A の発言が正しければ、B がコードを知っている。

- B の発言が正しければ、C がコードを知っている。

- C の発言が正しければ、D がコードを知っている。

- D の発言が正しければ、D がコードを知っている。

ただし、コードを知っているのは1人だけでなければなりません。

ここで「たった1人が嘘をついている」という条件のもとで各場合を検討してみます。

1. A が嘘の場合

- A(嘘): 「Bがコードを知っている」は偽 → B はコードを知らない

- B(正直): 「Cがコードを知っている」は真 → C がコードを知っている

- C(正直): 「Dがコードを知っている」は真 → D がコードを知っている

- D(正直): 「私がコードを知っている」は真 → D がコードを知っている

結果として、B はコードを知らず、C と D の両方がコードを知っていることになり、コードを知っているのは2人となってしまいます。条件に反します。

2. B が嘘の場合

- A(正直): 「Bがコードを知っている」は真 → B がコードを知っている

- B(嘘): 「Cがコードを知っている」は偽 → C はコードを知らない

- C(正直): 「Dがコードを知っている」は真 → D がコードを知っている

- D(正直): 「私がコードを知っている」は真 → D がコードを知っている

結果として、A の発言から B が、C の発言から D がコードを知っていることになり、コードを知っているのは2人になってしまいます。

3. C が嘘の場合

- A(正直): 「Bがコードを知っている」は真 → B がコードを知っている

- B(正直): 「Cがコードを知っている」は真 → C がコードを知っている

- C(嘘): 「Dがコードを知っている」は偽 → D はコードを知らない

- D(正直): 「私がコードを知っている」は真 → D がコードを知っている

この場合、B と D について矛盾が生じます。B の発言により C がコードを知っている、かつ D の発言により D がコードを知っているので、2人がコードを知っていることになります。

4. D が嘘の場合

- A(正直): 「Bがコードを知っている」は真 → B がコードを知っている

- B(正直): 「Cがコードを知っている」は真 → C がコードを知っている

- C(正直): 「Dがコードを知っている」は真 → D がコードを知っている

- D(嘘): 「私がコードを知っている」は偽 → D はコードを知らない

この場合も、A, B, C の正直な発言からそれぞれ B, C, D がコードを知っているとされ、3人がコードを知っていることになってしまい、条件に反します。

結論

どの人物が嘘をついていると仮定しても、必ず「コードを知っている人数が1人である」という条件を満たすことができません。

つまり、「金庫を開けるコードを知っているのは1人だけ」「発言のうち1人だけが嘘」という条件のもとでは、矛盾が生じ、整合する解は存在しません。

答え:

与えられた前提条件のもとでは、誰が嘘をついているかを決定することはできず、問題文自体に矛盾があります。

o3-miniモデルのベンチマークと注意点

ベンチマーク結果

- 「AIME 2024」のテストでは、高推論設定(High)でDeepSeekの「R1」を上回る結果を出したものの、低推論設定(Low)ではR1に及ばないケースもあります。

- SWE-bench Verified(プログラミングテスト)では、High設定において「R1」を0.1ポイント上回るなど微差での勝負が続いています。

注意点

- 「o3-mini」は専門領域での精度向上が図られている一方、万能型の最上位モデルというわけではありません。

- 性能差は推論設定に左右されるため、速度を重視する場合と精度を最優先したい場合で使い分けが必要です。

- 「安全性(セーフティ)」については、OpenAI独自の“deliberative alignment”手法によって改善されたとされていますが、誤回答や問題のある回答を完全に排除できるわけではない点には留意が必要です。

o3-mini まとめ

「o3-mini」は、OpenAIの「o1」シリーズを補完・強化する形で登場した次世代推論モデルです。負荷とコストを抑えながら、数学やプログラミングなどの技術分野でより正確性の高い回答を得たいユーザーにとって、新たな選択肢として大いに期待が寄せられています。

一方で、競合モデルとの比較では、高い推論設定を使わないと性能がやや伸び悩むケースも報告されており、使いこなすには推論レベルの切り替えが鍵となりそうです。AI業界の熾烈な競争の中で、“コストパフォーマンス”と“信頼性”のバランスをどう取っていくかが、今後さらに注目されるでしょう。