ChatGPTを支える次の一手、OpenAIが描く垂直統合の未来図

「ChatGPT」は便利だけれど、その裏側ではどんな仕組みで動いているのか──そんな疑問をお持ちではありませんか?

実は今、OpenAIが直面している問題はGPU不足と莫大なコスト。こうした悩みに対処すべく、同社は大きく舵を切り、自前の半導体開発に乗り出しています。実はGoogle検索の10分の1規模でも数兆円のGPU投資が必要になる試算があるほど、そのスケールは想像以上です。

本記事を読むことで、OpenAIがなぜ“半導体内製化”を進めるのか、そのメリットや市場への影響を徹底解説。あなたがAIの最先端事情を理解し、未来のビジネスチャンスを掴むヒントが得られるでしょう。

OpenAIが半導体内製化を選ぶ背景

チップ不足と高コストの深刻化

OpenAI(ChatGPTの開発企業)は、AIに不可欠な先端GPUの供給不足と高騰する運用コストという問題に直面しています。NVIDIA製GPUに大きく依存しているため、サプライリスクとコスト負担が大きく、2023年には数十億ドル規模の赤字であったと報じられています。実際、「ChatGPTの推論コストは1クエリ当たり約5円」という試算もあり、ユーザが増えれば増えるほど運用負担が膨張するのです。

スケーラビリティと競争力の確保

今後さらにサービスを拡大するにあたり、外部の汎用GPUだけでは需要を満たしきれないリスクが高まります。また汎用品では、AIモデルに最適化したアーキテクチャの実装が難しいという課題もあります。

そこで他の大手テック企業(GoogleやAmazon)が進めてきたように、OpenAIも専用チップを自前設計し、性能と効率を最大化したい考えです。長期的なコスト圧縮だけでなく、NVIDIAなどサプライヤーに対して交渉力を高める狙いもあります。

内製チップの特徴と開発体制

AI専用アクセラレータの開発

OpenAIが注力するのは、GPUのような汎用グラフィックス処理ではなく、AI推論を高速化するカスタムASIC(専用チップ)です。大規模言語モデルの推論需要が今後さらに増すと見込まれるため、まずは効率的な推論特化型のチップに取り組むと伝えられています。一方、訓練性能も後々強化するロードマップが示唆されており、いずれは訓練~推論を一貫して内製チップでカバーする構想もあるようです。

専門エンジニアと技術要素

Google TPU開発のキーマンをはじめ、高速通信(SerDes)技術やメモリ帯域設計を熟知したエンジニアを集め、約20名規模のチームで進められています。最新ノード(5nmや3nm世代)による製造が計画されており、試作~量産には少なくとも1年半ほどかかる見通し。テープアウト工程だけで数千万ドルかかると言われるなど、巨額の投資が必要です。

主要パートナー企業との連携

TSMCでの先端プロセス製造

最先端チップの製造受託を担うのは、世界最大手のファウンドリTSMCです。OpenAIは同社と製造能力の確保をすでに交渉しており、2026年に量産を開始するスケジュールを狙っています。かつては自社工場ネットワークの構築を検討したものの、あまりに高額かつ時間がかかるため断念し、TSMCの設備を活用する柔軟策へシフトしています。

Broadcomとの協業

設計面ではBroadcomが中核パートナーです。Google TPUの共同開発にも関わった経験から、カスタムASIC開発や高速通信IPの提供に強みを持ちます。OpenAIとしては、内部に足りない設計リソースをBroadcomによって補い、TSMCとの連携もスムーズに進められるメリットがあります。

NVIDIAとの複雑な関係

OpenAIの最大のGPUサプライヤーは依然としてNVIDIAであり、今後数年は両社の協力体制が続く見込みです。NVIDIAの次世代GPUにも期待を寄せる一方、自社チップが完成すれば部分的に置き換わる可能性もあるため、関係性は「協調と競合」が入り混じった微妙なものとなっています。

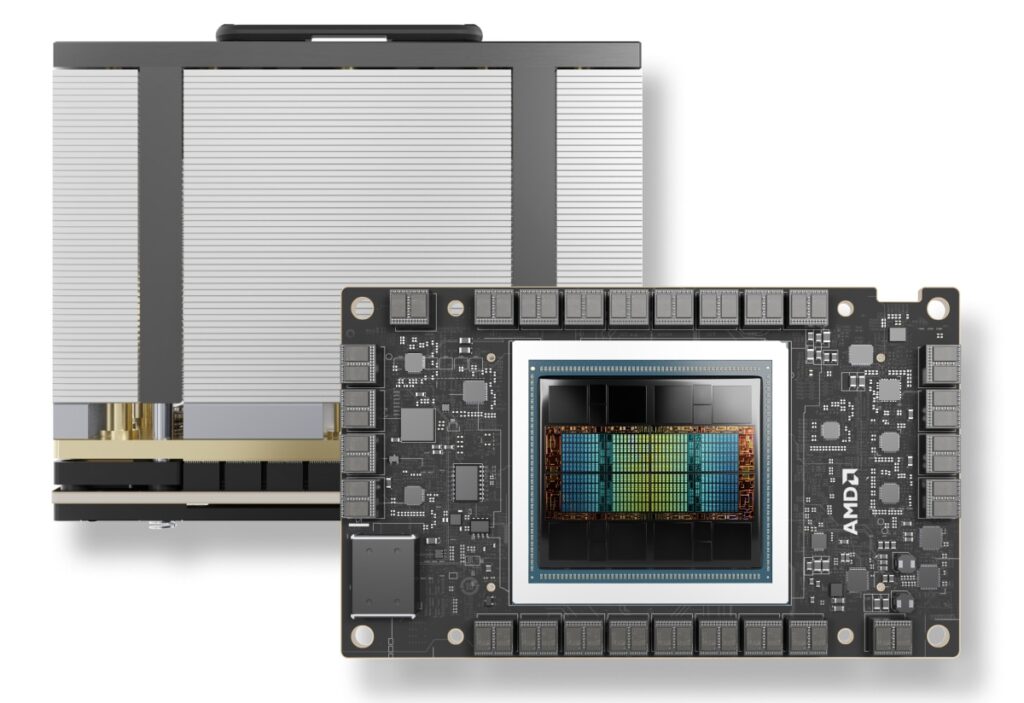

また、AMDの新型GPU「MI300X」も導入を始めるなど、OpenAIはNVIDIA一社依存から脱却すべくサプライヤーを複線化している段階です。

競合他社の動向とOpenAIの立ち位置

Googleは早くから自社TPU開発を進め、Amazon(AWS)もInferentiaやTrainiumといった独自ASICをクラウドに投入済み。Metaも独自チップの開発を試みていますが、初期プロジェクトが難航した事例もあります。OpenAIはマイクロソフトとの緊密な協力体制と、Broadcom・TSMCとの連携で迅速にキャッチアップを図る姿勢です。

ハードウェアとソフトウェアを一体で最適化できる垂直統合は、長期的な競争優位の鍵とされます。ただし初代チップの出来が完璧になる保証はなく、改良を重ねながら数世代かけて成熟を目指すのが現実的な道筋でしょう。

まとめと今後の展望

OpenAIの半導体内製化は、高騰するGPU費用を抑えるための“守りの戦略”であると同時に、ソフトウェアとハードウェアの融合で性能を極限まで高める“攻めの戦略”でもあります。

既存のGPUメーカーに依存しすぎない体制を作りながら、自社チップが完成してもすぐに完全移行するわけではなく「内製+他社製品」というハイブリッド路線を取る点は、極めて現実的といえるでしょう。もし2026年に量産チップが順調に登場すれば、AI業界に新たな勢力図の変化をもたらし、ユーザーにとってはより安価で高性能なAIサービスが手に入る可能性があります。

これからの数年間、OpenAIがどこまでハードウェア開発を進化させ、競合他社とどう渡り合うのか──その動向から目が離せません。