DeepSeek-R1が示す“純強化学習”の衝撃

はじめに:この記事を読むメリットとは?

- 「オープンソースのAIは、果たして商用モデルと同じくらい強力になりうるのだろうか?」

- 「大手企業が独占するAI市場で、新興企業が食い込むための秘策とは?」

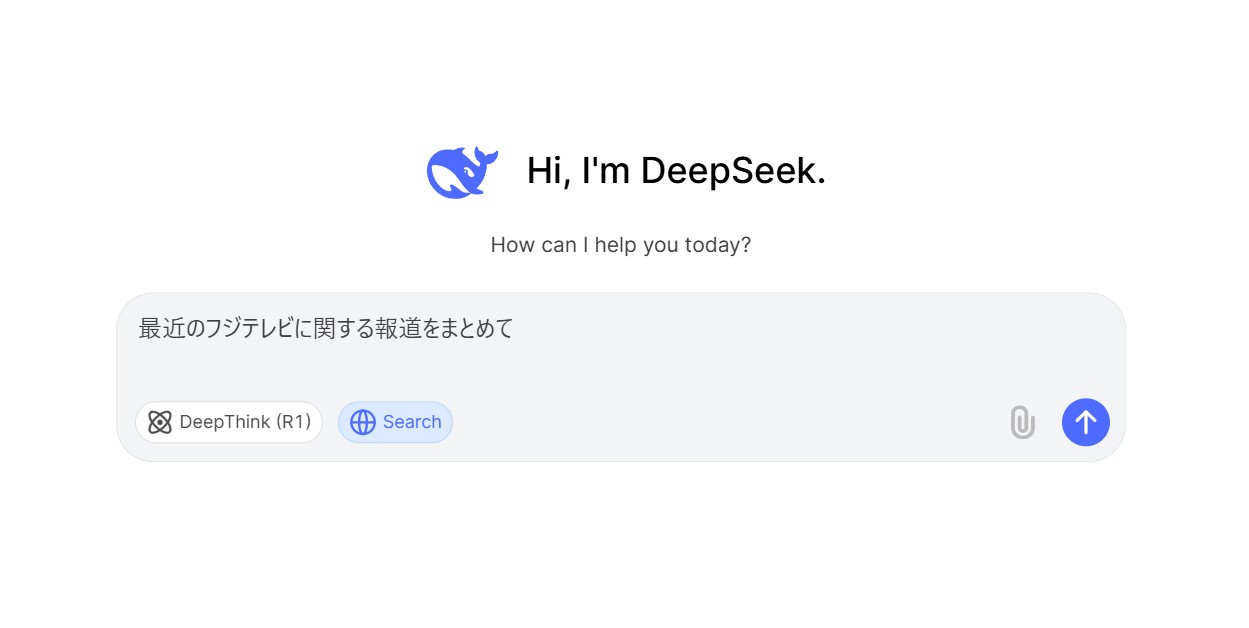

本記事では、こうした疑問に真っ向から挑む中国のAIスタートアップ・DeepSeekが公開した最新モデル「DeepSeek-R1」にスポットを当てます。

この記事を読むことで、

- 最新の純強化学習ベースLLMがOpenAI o1に迫る高精度を実現した仕組み

- 大手商用モデルに比べて最大95%もコストを削減できるオープンソースモデルのインパクト

- 大規模言語モデルの「思考過程(Chain-of-Thought)」にどんな可能性があるのか

- 実際に使えるリソース(Hugging Faceで公開されている重量級LLM)

などがわかり、エンジニアや研究者はもちろん、AIビジネスに携わる方にも大きな示唆を得られます。さらに、意外な事実としては「小規模モデルを蒸留して大規模モデルを上回る性能を引き出す」事例まで出てきており、「そんなことが本当にあるの?」と疑問を持ってしまう方もいるでしょう。

しかし、DeepSeekはそれを実際にやってのけています。本稿では、その詳細をわかりやすくまとめました。

OpenAIを猛追する中国スタートアップの挑戦

中国のAIスタートアップ・DeepSeekは、これまでも大手ベンダーに真っ向から挑むオープンソース技術を次々と発表しており、グローバルのAIコミュニティで注目を集めています。そして今回、同社の最新モデル「DeepSeek-R1」が発表されました。

DeepSeek-R1は、「大手企業の高性能モデルが独占気味になりつつあるのは本当か?」という疑問に対し、大きなインパクトを与えています。OpenAIが提供する最先端の推論モデル「o1」に匹敵する性能を実証しているのです。

驚くべきコスト削減

さらに驚くのは、そのコスト面。OpenAI o1は入力トークンあたり15ドル/百万トークン、出力トークンあたり60ドル/百万トークンという料金ですが、DeepSeek Reasoner(R1ベースの推論サービス)は入力0.55ドル、出力2.19ドルで利用可能だといいます。

要するに、90〜95%のコスト削減を実現しているわけです。「高性能=高コスト」という従来の常識を覆し、オープンソースモデルでも十分な品質を低価格で提供できることを示した点は、大きな注目ポイントでしょう。

DeepSeek-R1の性能は本当にo1に匹敵するのか?

DeepSeekは、数学・プログラミング・一般的知識を測定する複数のベンチマークでR1の実力を検証しており、その結果を公開しています。

- AIME 2024(数学コンテスト): DeepSeek-R1は79.8%、o1-1217は79.2%

- MATH-500(数学問題集): DeepSeek-R1は97.3%、o1-1217は96.4%

- Codeforces(プログラミングコンテスト): DeepSeek-R1はレーティング2,029、ヒトの上位96.3%を上回る

- MMLU(学問分野の総合知識): DeepSeek-R1は90.8%、o1-1217は91.8%

数学やコーディング、汎用知識といった多角的な指標で見ると、ほぼ同レベルか一部でR1が上回る結果が出ており、オープンソースモデルの実力が着実に高まっていることがわかります。

「純強化学習」を軸とした学習プロセス

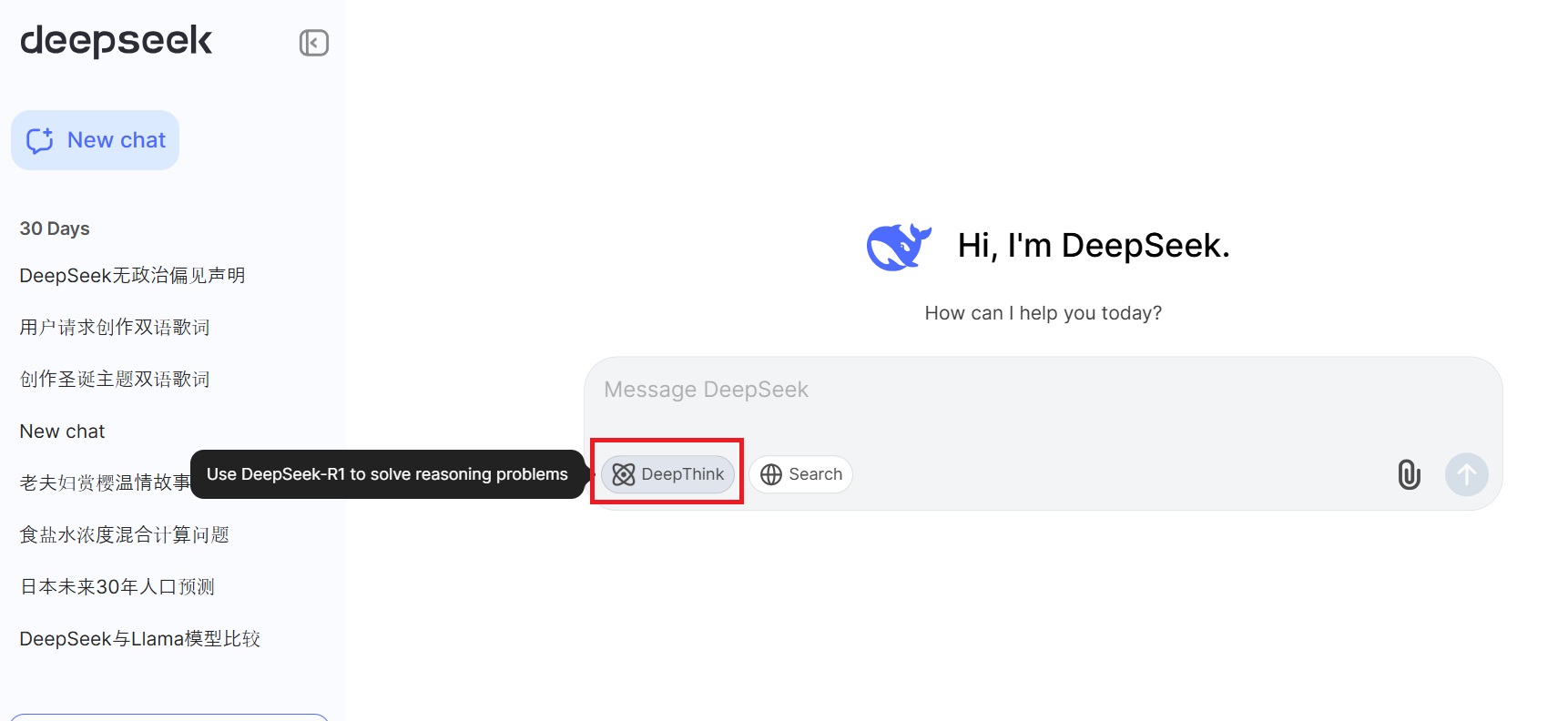

DeepSeek-R1が注目されるもうひとつの理由は、モデルの学習プロセスです。OpenAIのo1と同様に「Chain-of-Thought(思考プロセスの連鎖)」を活用し、強化学習によってモデル自身に試行錯誤を促します。

とくにDeepSeek-R1は、スーパーバイザード・ファインチューニング(SFT)と強化学習を段階的に組み合わせており、以下のようなステップを経ています。

- DeepSeek-V3-baseをベースモデルとして準備

- 純強化学習による自己進化(DeepSeek-R1-Zero)

- 教師データを使わずに試行錯誤を重ね、難易度の高い問題でも自力で解法を発見

- AIME 2024のスコアがわずか15.6%から71.0%へ、さらに多数決による集計で86.7%に到達

- 追加のスーパーバイザード・ファインチューニングと強化学習の併用

- 読みやすさや言語混在などの問題を解消するため、SFTデータを追加

- ライティングやQA、自己認識などの多様なタスクに対応させつつ、再度強化学習で微調整

- 最終チェックポイントをDeepSeek-R1として公開

この段階的アプローチによって、高度な推論能力と読みやすい出力テキストの両立を達成したのがR1の強みと言えます。

蒸留による小型モデルの“意外な活躍”

さらにDeepSeekは、R1を使った蒸留(大規模モデルで習得した知識を小規模モデルに移植する技術)にも成功しています。

実際に、Qwen-1.5Bといった小規模モデルをR1で蒸留したところ、「GPT-4o」や「Claude 3.5 Sonnet」など、より大規模なモデルを一部の数学ベンチマークで上回ったという結果も出ているのです。

「そんなに小さいモデルで大丈夫なの?」と不安に思う向きもありますが、この結果は“モデルの賢さ”は単純なパラメータ数だけでは決まらないことを示しています。

DeepSeekが完全オープンソースを選ぶ理由

DeepSeekは、これらのモデルと訓練手法をすべてオープンソースで公開しています。Hugging Face上でMITライセンスのもと、モデルウエイトとコードベースを誰でも利用可能です。

「大手商用モデルを使いたいけれど、高コストがネック」という課題は、多くの企業や開発者が直面しているでしょう。その点で、性能はほぼ同等でありながら圧倒的に安価なR1や、さらに圧縮された蒸留モデルは、まさに一つの“福音”といえます。

また、オープンソースとして公開されている点はコミュニティの検証が進みやすく、信頼性や拡張性が高まりやすいという大きなメリットもあります。

まとめ:AGI時代へ向けたオープンソースの逆襲

DeepSeek-R1の登場は、AI業界におけるオープンソースモデルの地位をさらに高める可能性を秘めています。

オープンソース化によるコミュニティ主導のイノベーションが、より多様な応用や高速な改善サイクルをもたらすのは想像に難くありません。これから「高度な推論ができるAIを低コストで使いたい」というビジネス課題や研究ニーズは一層高まっていくでしょう。

DeepSeek-R1の出現によって、「オープンソースでどこまで行けるのか?」という問いへの答えが少しずつ現実味を帯び始めています。かつて「それは無理でしょ」と言われていた分野にオープンソースの追い風が吹いている今、この流れから目を離さないようにしましょう。