危険を見逃さない:ChatGPTを安心して使うための実践ガイド

「ChatGPTは便利だけれど、本当に安全なの?」と疑問に思ったことはありませんか。最近では、誤情報の出力や機密情報の流出など、意外な落とし穴が報告されるケースも増えています。

本記事では、ChatGPTのセキュリティに関する具体的な対策や過去のインシデントを分かりやすく解説し、読者の「知らなかった!」を解消できるよう構成しました。企業だけでなく個人でも、うっかりリスクを招かないためのポイントを網羅しています。読んでおくだけで、一歩先の安心を手に入れられるはずです。

ChatGPTのセキュリティリスクとOpenAIの対策

ChatGPTは、自然言語処理の進歩を象徴する革新的なサービスですが、その利便性とともに「データ漏洩」「不正確な出力によるリスク」「サイバー攻撃の媒介」などの懸念も取り沙汰されています。

OpenAIはこれらに対処するため、以下のような仕組みを整えています。

- データの暗号化と保護

- AES-256を使った静止時のデータ暗号化

- TLS 1.2+による通信時の暗号化

- SOC 2/3やGDPRなどのプライバシー規制に準拠

- 企業向けSAML SSOやデータ保持期間制御

- モデルの安全性確保

- 人間のフィードバックを活用した強化学習(RLHF)

- コンテンツモデレーションによる不適切な出力のフィルタリング

- 定期的なモデル更新とバグ修正

- サムズアップ/サムズダウンボタンでのユーザーフィードバック機能

- 最大20,000ドルのバグ報奨金プログラムによる迅速な脆弱性修正

- ユーザー教育と責任

- 機密情報を入力しないよう明示的に推奨

- 出力内容の正確性を常に確認し、必要に応じて専門家に相談

- ChatGPTを利用する際のベストプラクティスを文書化・案内

過去のセキュリティ事故が示す危険性

2023年3月の会話履歴漏洩バグ

2023年3月、ChatGPTが一時的にダウンし、別ユーザーの会話履歴が閲覧できてしまうバグが報告されました。支払い情報が漏れる可能性も懸念され、OpenAIは原因を迅速に調査し修正を実施。結果的に大きなトラブルは回避されましたが、インシデントは「どんなに優れたサービスでも常に万全ではない」ことを浮き彫りにしました。

機密情報の入力による漏洩事例

サムスンの従業員がソースコードや会議メモをChatGPTに入力したことで、企業内部のデータが外部に流出するリスクを招いた事例も報告されています。ユーザー側の利用ガイドライン遵守が不十分だと、思わぬ形で情報が第三者に渡ってしまう危険性があるのです。

ChatGPTのセキュリティ機能と対策の詳細

| カテゴリ | 詳細 | 具体例 |

|---|---|---|

| データ保護 | AES-256での静止時暗号化、TLS 1.2+での転送時暗号化、 SOC 2/3準拠など | 企業版ではSAML SSOによる認証やデータ保持期間の制御を提供 (企業データはトレーニングに使用されない) |

| モデルの安全性 | RLHF(人間のフィードバックによる強化学習)、 コンテンツモデレーション、定期更新 | 不適切なリクエスト(差別的、違法など)を自動で拒否し、 継続的にモデル精度を改善 |

| バグ修正と監視 | バグ報奨金プログラム(最大20,000ドル)、 継続的な監視とインシデント対応 | 2023年3月の会話履歴漏洩後、原因を調査し迅速に修正 |

OpenAIはこれらの対策を講じることで、ChatGPTの利用に伴う事故リスクを最小限に抑えようとしています。しかし、完璧な防御体制を構築することは難しく、定期的なアップデートとユーザーからのフィードバックが欠かせません。

ユーザーが取るべきセキュリティ対策

- 機密情報を入力しない

個人情報や企業の社外秘データをむやみに入力するのは厳禁です。必要に応じてモデルの学習利用をオフにするなど、設定を細かく確認しましょう。 - 出力の正確性を常に検証する

ChatGPTはときに誤った情報を生成する可能性があります。医療や法律など重要な分野の情報を得る場合は、必ず専門家の監修やレビューを受けることが望ましいです。 - フィードバックを積極的に提供

間違いや不適切な出力を発見したら、サムズダウンで報告するなど、ユーザー自身がプラットフォーム改善に協力することで、安全性の向上につながります。

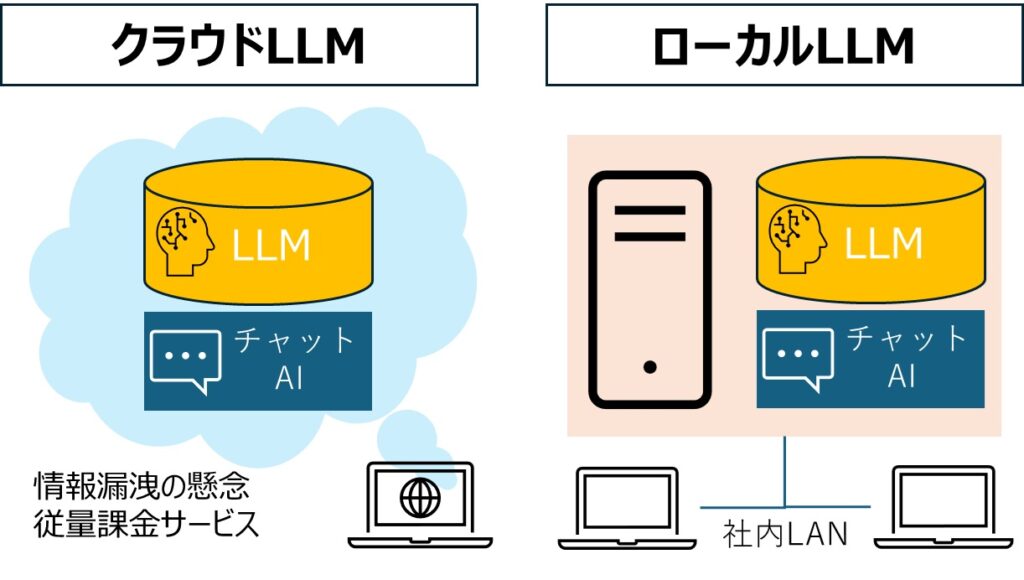

ローカル環境での生成AI(LLM)の導入

ローカル環境にLLM(大規模言語モデル)を導入することで、クラウド環境に比べてデータ漏洩リスクや外部依存を軽減できるというメリットがあります。

選定と導入の計画

- モデルの種類・ライセンスの確認

- オープンソースモデル(例:LLaMAベース、GPT4All、BLOOMなど)の場合、ライセンス形態や再配布ルールを確認。

- 商用ソリューション(例:企業向けのオンプレミス型LLMサービス)の場合、サポート体制やアップデートポリシーをチェック。

- ハードウェア要件の確保

- 大規模モデルの推論や学習には高いGPUリソースや大量のメモリが必要となる場合が多い。

- 導入前に、運用コスト(電力消費、冷却設備など)や保守費用を試算し、将来的な拡張も見越しておく。

ローカル環境で動くLLMについてもっと知りたい方は以下をご覧ください。

ChatGPTの利用において、組織向けの追加対策

- エンドポイント保護の強化

EDR(エンドポイント検知応答)やNGAV(次世代アンチウイルス)の導入により、ChatGPTから生成されたコードの誤用やマルウェア感染を検知します。 - リスク評価と継続的な監査

AIの導入プロセスにおいてセキュリティ監査を実施し、脆弱性を早期に発見・修正できる体制を整えましょう。 - 代替ソリューションの活用

IBM watsonxなど、データ所有権とプライバシーに配慮したAIプラットフォームを検討することで、より高いセキュリティ基準を満たすことができます。

結論

ChatGPTは強力なAIアシスタントとして多くの可能性を秘めていますが、その利便性を最大限活かすには、ユーザー側もセキュリティリスクを理解し、ベストプラクティスを守ることが不可欠です。

OpenAIは暗号化やモデレーションをはじめとする多角的な対策を実施していますが、完璧でない以上、利用者自身による注意や組織的なセキュリティ対策がさらに重要となります。信頼性の高いプラットフォームを選定し、最新のセキュリティ情報をキャッチアップしながらChatGPTを活用することで、リスクを最小限に抑えつつAIの恩恵を享受できるでしょう。