生成AIの活用が進む中、ChatGPTを業務に取り入れる企業が増えています。しかし、その利便性の裏には、情報漏洩やサイバー攻撃といったリスクも存在します。本記事では、2025年5月時点での最新動向を踏まえ、企業がChatGPTを安全に利用するためのポイントを解説します。ChatGPTをビジネスに活用したい方は、是非一読ください。

この記事の内容は上記のGPTマスター放送室でわかりやすく音声で解説しています。

1. ChatGPT利用における主なセキュリティリスク

1.1 機密情報の漏洩リスク

ChatGPTに入力されたデータは、OpenAIのサーバー上で処理・保存される可能性があります。とくに、個人情報や企業の機密情報を入力することで、意図せずに情報漏洩のリスクを高めることになります。実際、過去にはChatGPTの利用を通じて、企業の機密情報が外部に漏洩した事例も報告されています。

実際に起きた事例

2023年3月の報道によると、韓国のサムスン電子でChatGPTに入力した機密情報が流出してしまう事件が起こりました。また、過去にはChatGPT Plus会員の約1.2%の個人情報が流出する事例も発生しています。

1.2 マルウェアやフィッシングのリスク

ChatGPTを装った偽のアプリやウェブサイトが出回っており、これらを通じてマルウェアに感染するリスクがあります。また、ChatGPTを利用して生成されたコードやリンクが、悪意のあるものである可能性も否定できません。

ChatGPTを装ったアプリ

PCのブラウザを使って、ChatGPTの公式サイトにアクセスして利用するのは問題がありません。ただ、ChatGPTのスマートフォンアプリになりすますマルウェアがいくつか存在しているようです。これらのアプリをダウンロードしてしまうと、マルウェア感染してしまいます。

プログラミングコードのパッケージからのマルウェア感染

ChatGPTではプログラミングコードも生成できます。プログラミングでコードを使用する場合、使用言語で利用する「オブジェクト」や「関数」の宣言などをまとめたものを「パッケージ」と呼びますが、このパッケージを経由してマルウェア感染してしまう可能性もあるようです。

1.3 不正アクセスとアカウント乗っ取り

ChatGPTのアカウントが不正アクセスの対象となるケースも増えています。特に、単一のパスワードで複数のサービスを利用している場合、1つのサービスで情報が漏洩すると、他のサービスにも影響が及ぶ可能性があります。

対処法

対処法としては、SSOを利用して、アカウントを保護することです。また、ChatGPTでは2要素認証にも対応しています。2要素認証に利用するワンタイムパスワードアプリ(Google Authenticatorアプリ、Microsoft Authenticatorアプリ等)をスマートフォンにインストールして、2要素認証を導入してみましょう。(アカウントによっては2要素認証に対応していない場合があるようです)

1.4 プロンプトインジェクション攻撃

プロンプトインジェクションとは、ユーザーの入力に悪意のある命令を含めることで、AIの出力を意図的に操作する攻撃手法です。2025年には、この手法が進化し、より巧妙な攻撃が報告されています。特に、間接的なプロンプトインジェクションにより、AIが外部の悪意ある指示に従ってしまうリスクが指摘されています。

1.5 画像解析によるプライバシー侵害

ChatGPTの最新モデルでは、画像解析機能が強化され、写真から位置情報や個人情報を推測する能力が向上しています。これにより、SNSなどに投稿された画像から、個人の居場所や生活環境が特定されるリスクが高まっています。

ChatGPTの使用を禁止している企業も多い

ChatGPTを上手に活用すれば、業務の効率化が図れます。しかし、リスクを考慮した結果、ChatGPTの使用を禁止している企業も少なくありません。

日本国内の企業でも全体の約72%が既にChatGPTを禁止、または今後の禁止を検討しているようです。しかし、もしも安全に使えるのなら、ChatGPTをビジネスに取り入れたい企業も多いのではないでしょうか?

企業が講じるべきセキュリティ対策

2.1 正規のChatGPTサービスの利用

ChatGPTを利用する際は、OpenAIが提供する公式のウェブサイトやアプリを使用することが重要です。非公式のサービスやアプリは、セキュリティリスクが高まる可能性があります。

2.2 社内ガイドラインの策定と教育

ChatGPTの利用に関する社内ガイドラインを策定し、従業員に対して適切な教育を行うことが必要です。特に、機密情報の取り扱いや、AIへの入力内容に関するルールを明確にすることで、リスクを軽減できます。

2.3 アクセス制御と監視体制の強化

ChatGPTの利用状況を監視し、不正なアクセスや異常な利用を早期に検知できる体制を整えることが重要です。また、アクセス権限を適切に管理し、必要最小限の権限付与を徹底することも効果的です。

2.4 オプトアウト設定の活用

OpenAIでは、ユーザーが自身のデータをAIの学習に使用しないよう設定するオプトアウト機能を提供しています。企業としては、この設定を活用し、機密情報がAIの学習データとして使用されないよう対策を講じることが推奨されます。

以上のような総合的な対策をすれば、比較的安全にChatGPTを利用できるでしょう。

ChatGPT Enterpriseの導入とその利点

OpenAIは、企業向けに「ChatGPT Enterprise」を提供しており、以下のようなセキュリティ機能が強化されています:

- エンドツーエンドの暗号化

- 詳細なアクセス制御と監査ログの提供

- GDPRやCCPAなどのプライバシー規制への準拠

- データの保存期間や利用範囲のカスタマイズ

これらの機能により、企業はChatGPTをより安全に業務に取り入れることが可能となります。

ローカルLLMの活用によるセキュリティ強化

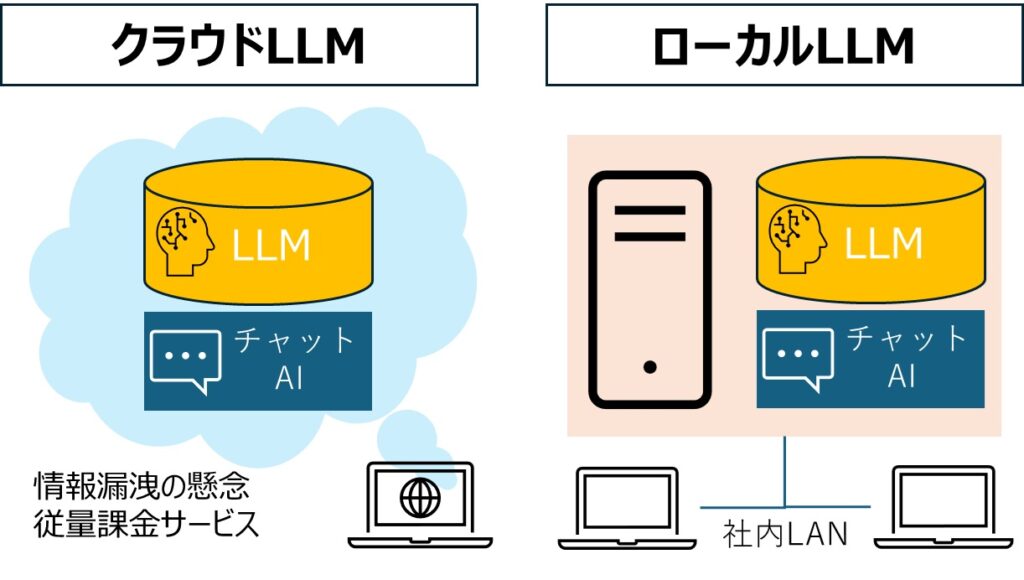

クラウドベースのAIサービスに不安を感じる企業は、ローカルで動作する大規模言語モデル(LLM)の導入を検討することも一つの選択肢です。ローカルLLMを活用することで、データが外部に送信されることなく、社内ネットワーク内でAIを活用することができます。本当に安心・安全に生成AIをビジネスで活用したいのであれば、ローカルLLMをおすすめします。

ローカルLLMを使えば、社内ネットワーク内で生成AIを利用することができるので、クラウド型の生成AIを使うより情報漏洩のリスクを軽減することができます。ローカルLLMについてもっと知りたい方は、以下をご覧ください。

企業で使うChatGPT:まとめ

ChatGPTは業務効率化や情報収集において強力なツールですが、その利用には慎重なセキュリティ対策が求められます。企業としては、最新のリスク情報を把握し、適切な対策を講じることで、安全にChatGPTを活用することが可能となります。