本記事では、AI研究の最新動向から、いわゆる「ハルシネーション(幻覚)」の現状と対策を徹底解説します。この記事を読めば、AIの弱点を理解した上で、ビジネスリスクを最小化しながら最大限の恩恵を得る方法が分かります。驚くべきことに、最新のAIモデルでは幻覚率が1.4%まで低減されたという研究結果も出ており、企業の対応策も日々進化しています。

AIの幻覚とは何か?現状を理解する

「AI幻覚」とは、AIが実際には存在しない情報や事実と異なる内容を、あたかも真実であるかのように出力する現象です。とくに大規模言語モデル(LLM)でこの問題が顕著となっています。IBMの研究によれば、AI幻覚は主に偏った訓練データや敵対的攻撃によって引き起こされるとされています。

ハルシネーションは改善傾向

最新の研究データによると、AI幻覚は完全には排除できていないものの、確実に改善されています。Natureの2025年1月の記事では、OpenAIのGPT-4の幻覚率は1.8%、さらに新しいモデルであるo1-miniでは1.4%まで低減されていることが報告されています。比較として、GPT-3.5では幻覚率が3.5%でした。これは顕著な進歩と言えるでしょう。

しかし、医療ジャーナル「Critical Care」の報告にあるように、医療分野などの専門領域では幻覚問題はいまだに重要な課題です。専門知識が必要な分野では、AIの生成内容をそのまま信頼することはリスクが高いと言えます。

幻覚を抑制する最新技術

研究者たちは幻覚を減らすために様々な手法を開発しています。代表的なものとして以下が挙げられます。

1. Chain-of-Thought(思考の連鎖)

Chain-of-Thoughtという手法は、AIに段階的な思考プロセスを促すプロンプト技術です。回答に至るまでの論理的なステップを明示させることで、推論の透明性を高め、幻覚を減少させます。

2. Retrieval Augmented Generation(RAG、検索拡張生成)

RAGは、AIの回答生成時に外部ソースから関連情報を検索・参照する技術です。WIREDの記事でも取り上げられているように、この方法によりAIの出力を事実に基づかせることで幻覚を抑制します。企業でも実装しやすく、実用性の高いアプローチとして注目されています。

3. 新しい検出アルゴリズム

TIMEの記事によれば、科学者たちは幻覚を79%の精度で検出できる新しいアルゴリズムを開発しました。このような検出技術を活用することで、AIが生成した情報の信頼性を事前に評価することが可能になります。

4. ドメイン固有の微調整

特定の専門分野に関する高品質なデータでモデルを微調整(ファインチューニング)することで、その分野における精度を向上させ、幻覚を減らす効果があります。企業が自社の業界特有の知識をAIに学習させることで、リスク管理を強化できます。

企業が行うべきAIの幻覚(ハルシネーション)への対応

AIの幻覚への対応は、企業の業種や業界、AI活用シーンによって異なりますが、基本的にはリスク管理の観点から無視できない問題です。

高リスク分野でのハルシネーションへの対応

医療、法律、金融、安全性に関わる業務など、誤情報が重大な影響を及ぼす可能性がある分野では、とくに慎重な対応が求められます。

こうした領域では人間の専門家が生成された文章を実際にファクトチェックするのが一番ですが、その方法が困難な場合は、出典を確認し一次情報と照合することです。また、複数の信頼できる情報源でクロスチェックし、情報の正確性を確保します。

低〜中リスク分野でのハルシネーションへの対応

マーケティングコンテンツの作成や顧客サポートなど、一定のチェック機構があれば許容できる領域では生成AIに備わっている検索機能やリサーチ機能を活用すると良いでしょう。

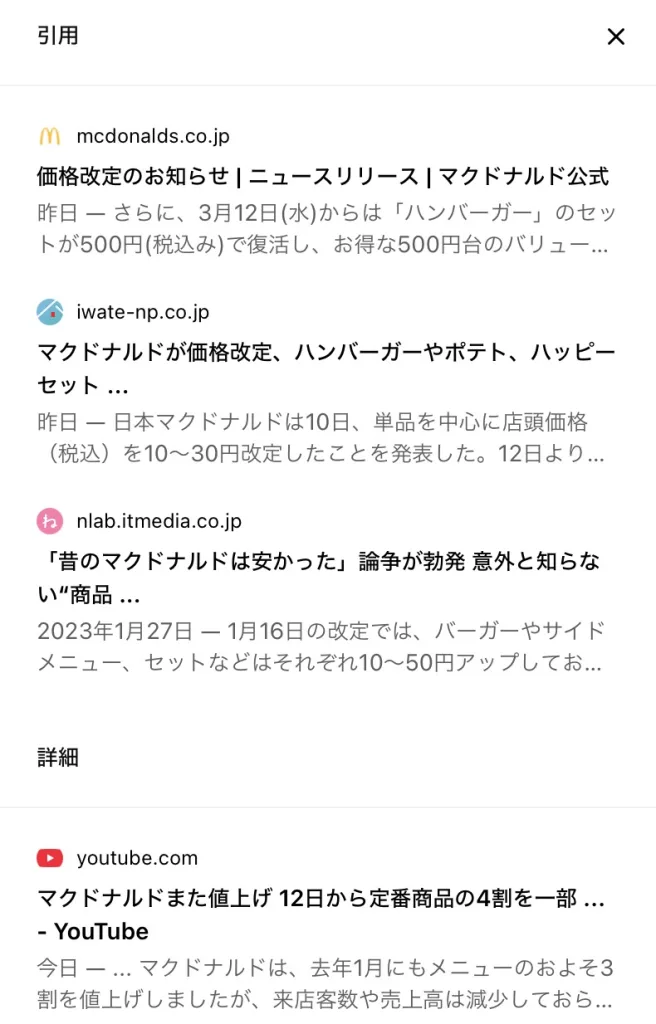

たとえば、ChatGPT-4oの検索機能を使うと、どのソースを参考にして文章を生成したのかがわかります。ChatGPTが文章を生成した際に「情報源」を提示してくれるので、その情報を確認します。

元の記事を詳しく見ることで、かなり精度の高いファクトチェックを行えるでしょう。以下の画像は2025年3月にマクドナルドの値上げに関する文章を生成した際に、ChatGPTが参考にした元記事のリストです。

これらの記事を複数確認すれば、大部分のハルシネーションを防ぐことができます。

最新のハルシネーション抑制技術

また近年では、Retrieval Augmented Generation (RAG)や Chain-of-Thought (思考の連鎖)などの技術がハルシネーション抑制に活用されています。

RAGはAIが外部データを参照しながら事実に基づく回答を生成し、誤情報を抑制できます。Chain-of-ThoughtはAIに段階的な推論を行わせ、誤答を減らす方法です。

また、Salesforceのブログでは生成AIの幻覚を防ぐ4つの方法として以下の方法を挙げています。

- データ品質の向上

- プロンプトの最適化

- 人間によるレビュー

- モデルの継続的な改善

企業にとっての最善の対処方法

幻覚によるリスクを最小化するために、企業が実施すべき具体的な対策をまとめます:

1. 高品質なデータの活用

バランスの取れた多様なデータセットでモデルをトレーニングすることで、幻覚を減らせます。自社の業務データを活用したファインチューニングも効果的です。

2. ファクトチェックと検証メカニズムの導入

AI生成コンテンツの正確性を確保するため、自動および手動の検証プロセスを組み込みます。AIの出力をクロスチェックするアプローチが提案されています。

3. ユーザー教育の実施

社内外のAIユーザーに対して、AIの限界や不確実性について教育し、批判的思考を促します。情報を盲目的に信じるのではなく、検証する習慣づけが重要です。

4. プロンプトエンジニアリングの最適化

AIに指示を出す際の文言(プロンプト)を工夫することで、より正確な回答を引き出せます。Lakeraのガイドでは、明確で具体的な指示、段階的な思考を促す問いかけなどが効果的とされています。

5. 継続的なモニタリングと改善

AI技術は急速に進化しています。最新の研究動向を追跡し、自社のAI活用方針を定期的に見直すことが重要です。

AIのハルシネーション(幻覚)との賢い付き合い方:まとめ

AIのハルシネーション(幻覚)は確実に改善されつつありますが、完全に排除することは現時点では難しいと言えます。「AIの幻覚を完全に止めることはできないが、損害を制限する技術はある」のが現状です。

企業がAIを活用する際には、その限界を理解した上で、リスクと効果のバランスを考慮した戦略を立てることが重要です。とくに重要なのは、AIをブラックボックスとして扱うのではなく、検証可能な形で活用することでしょう。