Google Geminiが変える“リアルタイム検索”の世界

スマートフォンで動画を撮影しながら、「今まさに映っている画面」を使ってAIに相談できるとしたら……一見SFのようですが、実はもう現実の技術です。

服を選ぶときの悩みや、動画の内容を詳しく知りたいときなど、ふとした瞬間に「こんな機能があったらいいのに」と思ったことはありませんか?

今回の記事では、Googleの新しいAIアシスタント「Gemini」が実現した“画面と動画を同時に活用できる”革新的な機能をご紹介。この記事を読めば、あなたが日常的に感じる疑問や課題を解決する新たなアプローチが見つかるかもしれません。

MWC 2025で発表! Google Geminiの新機能とは?

2025年2月下旬にスペイン・バルセロナで開催された世界最大級のモバイル見本市「MWC 2025」。このイベントでGoogleは、AIアシスタント「Gemini」に加わる新機能を披露し、来場者の注目を集めました。

キーワードは「Screenshare(スクリーンシェア)」と「リアルタイム動画検索」。これらはユーザーがスマートフォンの画面や録画中の動画といった“今、目の前にある情報”を直接Geminiに共有し、その場で疑問を解決できるようにする機能です。

「Screenshare」— スマホ画面をAIと共有して質問できる

まず「Screenshare」では、スマートフォンの画面をGeminiに直接見せながら質問ができます。例えばオンラインショッピング中に気になる商品があれば、写真や商品ページを見せつつ「これに合うファッションアイテムは?」と尋ねることが可能です。

実際、MWC 2025のデモでは、ワイドめのデニムパンツを選ぶ場面で「このパンツと合うコーディネートはどんなものがある?」とGeminiに聞くシーンが紹介されました。AIの答えは即座に画面上に表示され、ユーザーはショッピングの参考にできるのです。

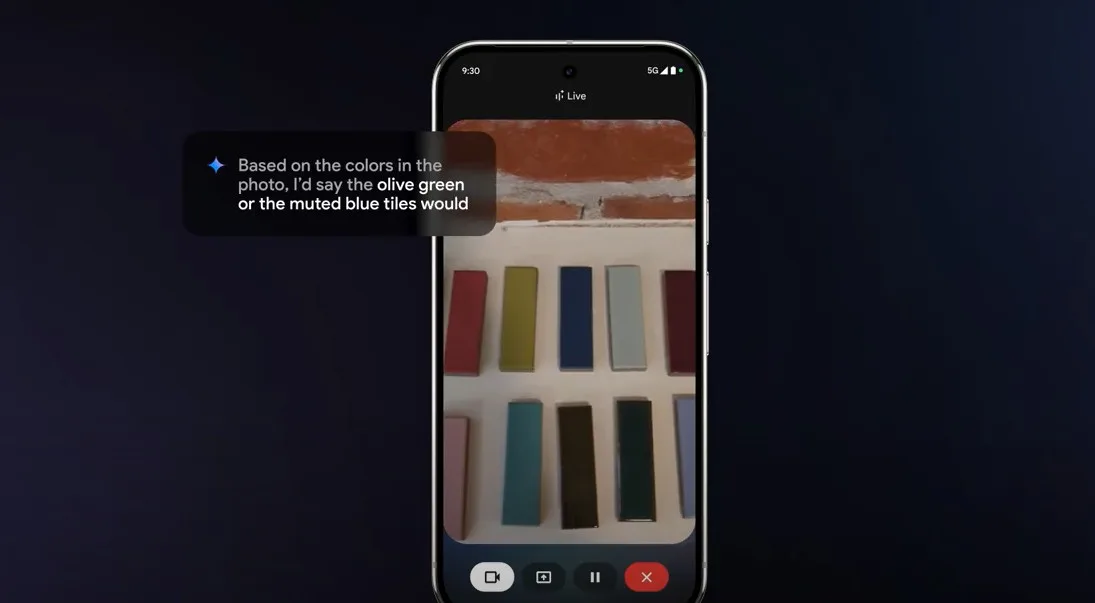

「リアルタイム動画検索」— 撮影しながらその場でAIに質問

次に「リアルタイム動画検索」では、撮影中の動画をそのままGeminiと“共有”しながら質問できます。これは以前からGoogleが予告していた機能で、昨年のGoogle I/Oでも一部の概要が示唆されていました。

従来のテキスト検索では、撮影した動画を後で整理してから検索する手間がありましたが、この機能によって撮影の合間に気になったことをすぐ尋ねられるようになります。

たとえば旅行先で風景を撮りながら、「この建築物はいつ建てられた?」「周辺のおすすめスポットは?」など、リアルタイムで疑問を解消できるわけです。

いつから使える? 利用対象と今後の展開

これらの機能は、Geminiの上位プラン「Gemini Advanced」の利用者向けに、Google One AI PremiumプランのAndroidユーザーに対して今月中にも提供が始まる予定とのこと。さらに今後のアップデートで、他のプラットフォームへの展開や機能拡充も期待されています。

実際に使い始めることで、動画や画面を通じた質問がどれほど生活や仕事を効率化してくれるのか、多くのユーザーがその恩恵を受ける日は近いでしょう。

新しい検索体験を試してみよう!

もし気になる方は、この機能が提供されるタイミングでAndroid端末を用意し、Gemini AdvancedとGoogle One AI Premiumへの加入を検討してみてください。テキストだけではなく“視覚情報”を使った新しい検索体験は、あなたのスマートフォン活用を大きく変えるかもしれません。

参考)YouTube動画