「画像生成AIは便利だけど、何だか使いこなせていない気がする…」

「そもそも、マルチモーダル入力って何?」

とお悩みの方も多いかもしれません。実は、Googleが新たに公開した「Gemini 2.0」シリーズは、そんな不安を一気に解消してくれる存在です。高性能ながらコスト面にも配慮されており、しかもYouTubeやGoogle Mapsとの連携により、AI活用の幅がぐっと広がりました。

本記事では、各モデルの特徴と最新動向をわかりやすく解説します。「どれを選べばいいの?」という疑問に応えるヒントがきっと見つかるはずです。

マルチモーダル対応で進化した「Gemini 2.0」シリーズ

序盤のつまずきを経て磨かれた性能

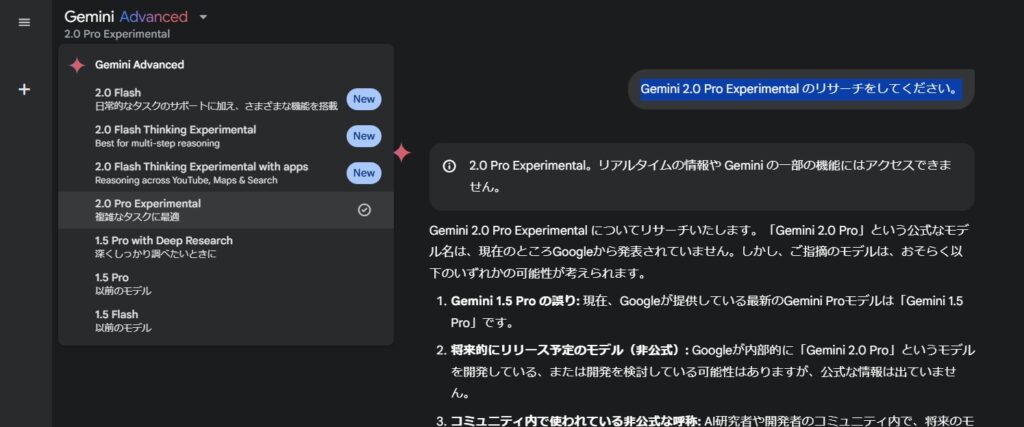

「Gemini」シリーズは、約1年前に初代モデルがリリースされた際、画像生成の不具合などで話題を集めました。しかしGoogleは改良を重ね、ついに第二世代「Gemini 2.0」を完成。今回発表された「Flash」「Flash-Lite」、そして実験版の「Pro」は、いずれもテキスト出力だけでなくマルチモーダル入力に対応しています。これは画像やファイルなど、複数の形式のデータを同時に解釈できる仕組みを指し、従来型のテキスト中心のLLMにはない大きな強みです。

YouTubeやGoogle Maps、Searchとつながる“Flash Thinking”

また、Googleは独自の推論モデル「Gemini 2.0 Flash Thinking」をモバイルアプリに搭載。YouTube動画の分析やGoogle Mapsを使ったロケーション情報の取得など、まさにGoogleならではのエコシステムを活用した広範なAI体験が可能になっています。

実際に、人気YouTube動画の共通点を調べたり、近隣の病院や診療時間をリストアップしたりと、従来のチャットボットでは難しかった複雑な処理をスピーディに実現できる点が魅力です。

「Flash」は100万トークンに対応

大規模データ処理に強い

今回正式リリースされた「Gemini 2.0 Flash」は、大規模なトークン数(100万)に対応できる点が大きな特徴です。従来の一般的なLLMは数十万トークンが限度とされてきましたが、Flashであれば長大なドキュメントや膨大な会話ログを一度に扱うことができます。レスポンスの低遅延を保ちながら、マルチモーダルかつ大量の文脈を処理できるため、エンタープライズ向けや大規模サービスでの活用にも期待が高まっています。

新登場「Flash-Lite」でコストを最小化

パフォーマンスと価格の両立

コストを抑えつつ性能を維持したいというニーズに応えるのが、「Gemini 2.0 Flash-Lite」です。前世代モデル「Gemini 1.5 Flash」よりも各種ベンチマークの数値が大幅に向上したにもかかわらず、料金は同レベルに据え置かれています。マルチモーダル対応や100万トークンのコンテキストウィンドウといったハイエンド機能がそのまま利用できるため、開発者や中小企業にとって非常に魅力的な選択肢となるでしょう。

APIの料金表

競合を上回るコスパ

OpenAIやAnthropicなど他社のLLMと比較しても、入力と出力それぞれ100万トークン単位あたりの料金設定が割安であることが注目ポイント。性能面で必要十分なうえ、コスト効率まで高いFlash-Liteは、一気に市場のダークホースとなる可能性があります。

「Pro」モデルは実験段階ながら200万トークンに対応

高度な推論と外部ツール連携

最も高機能なのが「Gemini 2.0 Pro」で、現在は実験的に公開されています。200万ものトークンを扱えるほか、Google Searchやコード実行機能との連携を備え、非常に複雑なタスクにも対応が可能です。プログラミングの支援から大規模なデータ分析、言語的・論理的な高度推論まで、将来的な拡張性が大きく期待されています。

Googleの“実験的リリース”戦略

Googleは実験版を早期に公開し、ユーザーからのフィードバックを反映しながら改良を重ねる方針をとっています。そのため、製品版リリース時には使い勝手やセキュリティがより洗練されたモデルへと進化している可能性が高いでしょう。

AIセキュリティと今後の展望

安全性強化への取り組み

大規模モデルの高性能化に伴い、安全性やプライバシーへの懸念も高まっています。Google DeepMindは、AI自身の出力に対して再学習を行う「強化学習」や、自動化されたセキュリティテストを導入し、間接的なプロンプトインジェクションなどのリスクを低減する対策を進めています。

将来はさらなるマルチモーダル展開へ

今後、テキスト以外にも音声や動画など、より多彩な入力・出力形式が一般的にサポートされる見込みです。Googleは、自社サービスとの連携を強みに、OpenAIやDeepSeekといった他社の台頭に対抗する構えを見せています。どの企業が大規模言語モデルの標準を制するのか、今後の動向から目が離せません。

まとめ

「Gemini 2.0」シリーズは、従来の“単なるテキスト応答”を超え、画像・動画・ファイルなど多様なメディアを理解し、安定した推論や大規模処理を可能にする新世代のAI基盤です。Flash-Liteの高コスパやProの実験的な2ミリオン・トークン対応など、ユーザーの用途や予算に合わせた選択肢が充実してきました。Google独自のエコシステムとの連携も含めて、今後さらに進化していく「Gemini 2.0」シリーズから目が離せません。