本記事では、OpenAIが発表した新たな推論モデル「o3-mini」の特長と活用メリットを徹底解説します。驚くべきことに、o3-miniは同クラスのo1モデルより93%も安価でありながら、高度な推論とコーディング性能を実現しています。

さらに最大20万トークン(日本語テキストに換算するとおおよそ40万~80万文字程度)という大規模コンテキストウィンドウなど、強力かつ柔軟な機能を多数備えています。

o3-miniで実現する高速&経済的なAI推論活用術

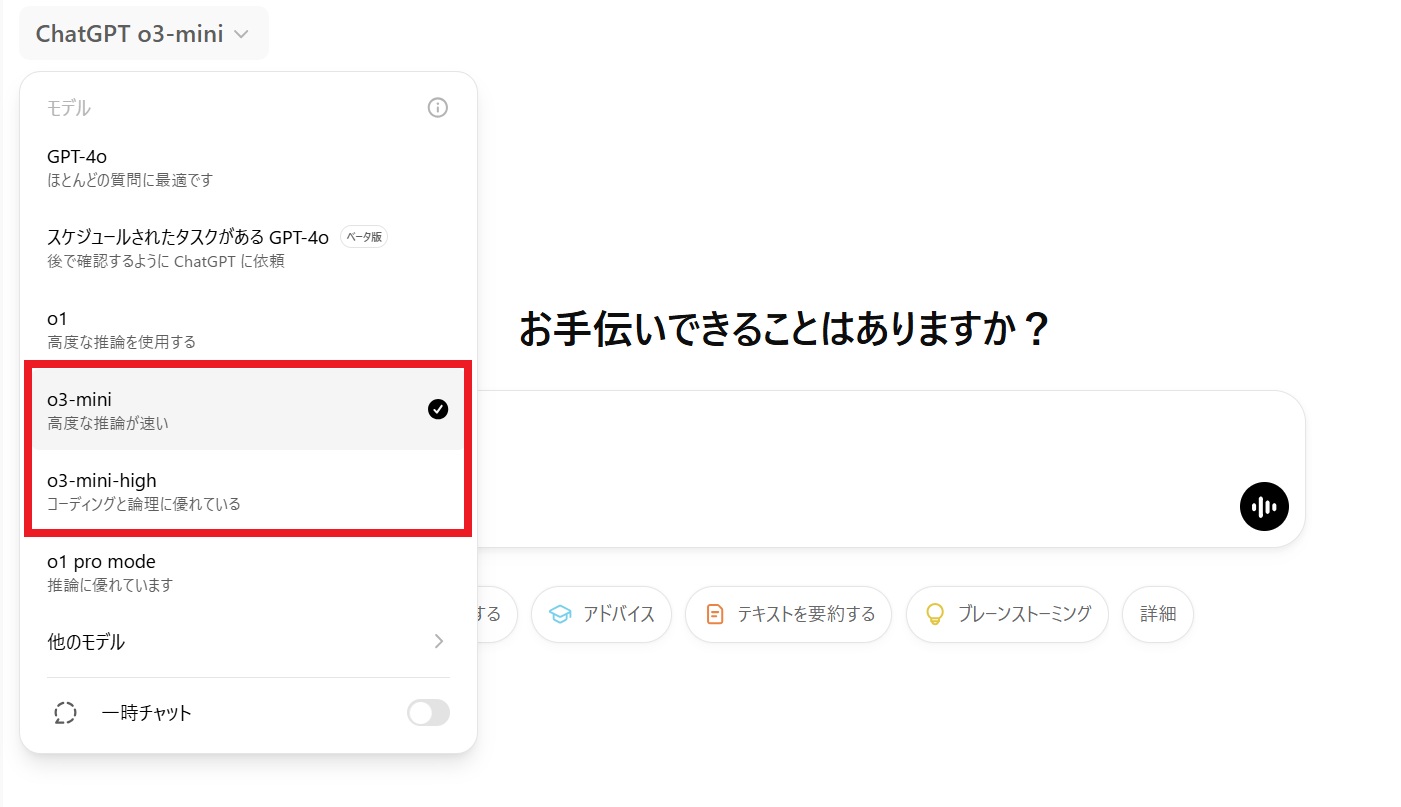

「o3-mini」が公開されたのは、2025年1月31日(米国時間)、日本では2025年2月1日です。このリリースにより、ChatGPTの無料ユーザーも含む全ユーザーおよびAPI利用者がo3-miniの先進的な推論能力を利用できるようになりました。そんなo3-miniを活用することで、あなたの開発プロセスがどのように進化するのか、一緒に探ってみましょう。

ChatGPT o3-miniとは?

ChatGPT o3-miniは、OpenAIが提供する最新の推論モデルで、コストと速度を両立しつつ、高い推論能力を備えています。

モデル名に含まれる「o3」は、推論シリーズの第三世代であることを示し、小型モデルながらも大規模な推論タスクに対応できる点が特徴です。特に科学・数学・コーディングなど、複雑な問題を解決する場面で力を発揮し、既存のo1モデルを上回るパフォーマンスが注目を集めています。

ChatGPT o3-miniの主要な特長

- 大幅なコスト削減

o3-miniは、o1モデルと比較して93%ものコスト削減を実現しています。より少ない予算で高度なAI推論を導入できるため、個人開発者から大企業まで幅広く活用できるのが魅力です。 - 高速かつ柔軟な推論

レイテンシ(応答速度)が低く、開発中の検証サイクルや本番運用時のユーザー体験が向上します。さらに推論努力度(Low/Medium/High)を選択できるため、タスクの複雑さや使用場面に応じて最適な推論を行うことが可能です。 - 豊富な開発者向け機能

- Function Calling: 必要な機能を直接呼び出せるため、スムーズなワークフローを構築。

- Structured Outputs: JSONなどの構造化データ形式で出力が得られ、後続処理を効率化。

- Batch API・Assistants API対応: 大規模開発や自動化に欠かせないバッチ処理が簡単に実装可能。

- ストリーミング対応: ユーザーにリアルタイムで結果を返し、より即時性が求められるアプリケーションにも最適。

- 巨大なコンテキストウィンドウと出力

最大200,000トークンのコンテキストウィンドウと、100,000トークンもの出力に対応。長文のドキュメント理解や大規模なコード生成が求められる場面で、スムーズな処理が期待できます。 - 生産性向上のためのガイドとサポート

GPTシリーズとはプロンプト設計が異なるため、OpenAIでは推論モデル専用の最適化ガイドを用意しています。これを活用することで、o3-miniのポテンシャルを最大限引き出せるでしょう。 - カットオフ

o3-miniモデルは2023年10月までのデータを学習しています。つまり、このモデルは2023年10月以降に起きた出来事や新しい技術・情報については知らない(学習データに含まれていない)ため、そういった内容を正しく扱うことが難しい場合があります。

他のモデルとの比較

以下は、ChatGPTの最新推論モデル「o3‐mini」と、従来のモデル(「o3‐mini‐high」「o1‐mini」「o1」「GPT‑4o」など)との主要スペック・特徴をまとめた比較表です。

各モデルは用途や得意分野、利用コストなどで差があり、プロジェクトの目的に応じた最適な選択が求められます。

| モデル | 応答速度 | 数学性能・推論精度 | プログラミング性能 | 最大トークン数 | 利用制限・料金例 | 主な用途 | 特徴・強み |

|---|---|---|---|---|---|---|---|

| o3‐mini | ⚡ 最速(約7.7秒) | 高い(o1‐mini~o1相当) | 高い(Eloスコア2130程度) | 100,000 | Pro:無制限/Plus・Team:1日150メッセージ程度 | STEM分野(数学・プログラミング・科学)、中小規模プロジェクト | 低コストで高速、エラー削減効果あり |

| o3‐mini‐high | ⏱ 中程度(やや応答に時間がかかる) | 非常に高い(87.3%正答率など、より複雑な推論対応) | 複雑な問題解決に優れる | 100,000 | Pro:無制限/Plus・Team:1日150メッセージ程度 | 高度な研究開発、専門的タスク(長文・複雑な問題解決) | o3‐miniよりさらに高精度な推論モード |

| o1‐mini | 高速(約10.16秒) | 中程度 | 中程度 | 65,536 | 1日50メッセージ程度 | 基本的な推論タスク、低コストの簡易プロジェクト | 軽量化を重視、リソースの限られた環境向け |

| o1 | 中程度 | 約83.3%正答率(数学・競技プログラミング等) | 上位10%程度の高性能 | 100,000 | 1週間あたり50メッセージ程度 | ビジネス文書、研究、幅広い汎用タスク | 汎用性が高く、深い推論に対応 |

| GPT‑4o | ゆっくり(複雑な処理の場合) | 中程度 | 中程度 | 12,800 | 無料ユーザー:3時間80回程度(利用回数に制限あり) | 汎用タスク、低コスト用途(無料プランも利用可能) | マルチモーダル対応、低料金で手軽に利用可能 |

補足説明

- o3‐mini

最新の「o3」シリーズの小型版として、特に数学・プログラミングなどSTEM分野での推論能力が大幅に向上している点が特徴です。高速な応答と低コストで利用できるため、教育機関や中小規模の開発プロジェクトでの採用が期待されています。 - o3‐mini‐high

o3‐miniの上位モデルで、さらに高度な推論が必要なタスクに対応。計算リソースは多く必要となるため、応答速度はやや落ちますが、より精度の高い解析が可能です。 - o1‐mini/o1

これまでの汎用推論モデルとして、多くのタスクに対応。o1‐miniは軽量で低コスト向け、o1はより広い用途に対応できる汎用性が魅力です。 - GPT‑4o

マルチモーダル対応や、無料プランでの利用が可能な点が特徴ですが、最大トークン数や応答速度の点では最新のo3シリーズに劣る部分があります。

この比較表をもとに、利用したいタスク(例:数学の問題解決、プログラミング支援、一般会話など)やコスト、利用制限に応じて最適なモデルを選択してください。

O3-miniの具体的な活用シーン

- コーディングアシスタント

大規模なコードベースを扱うプロジェクトで、リファクタリングや関数の提案を支援し、開発効率を大幅に向上させます。 - 数理問題の解決

数学的推論やアルゴリズムの設計において、複雑なステップを効率的に推論し、迅速な検証が可能になります。 - エージェント開発

タスクの自動化やプロセス効率化を目指すエージェントソリューションで、低コストかつ高性能なバックエンドとしてo3-miniを活用できます。

o3-mini まとめ

o3-miniは、高度な推論タスクを低コスト・高速で実行できるだけでなく、機能の柔軟性やサポート体制も充実しています。

とくに理系分野やコーディング分野では、その大きなコンテキストウィンドウと推論性能が大きく役立つでしょう。これまで予算面や速度面で導入を見送っていた方や、より優れたAIを探している開発者にとって、o3-miniは最適な選択肢となり得ます。