オープンソースLLMは急速に進化しており、単純なベンチマークスコアだけで優劣を判断することが難しくなっています。とくに企業利用においては、性能が高いことよりも、自社の環境や運用条件に適合するかどうかが重要です。

本記事では、2026年の最新情報を元にして、研究用途や個人開発者向けの「最強モデル比較」ではなく、企業が実際に導入し、継続利用できるかという視点を重視して評価を行います(この記事は2026年2月現在の情報を参考に制作しています)。

本記事で取り上げるオープンソースLLMについて

今回取り上げるのは、2026年2月現在に注目度が高く、かつ企業利用を前提に検討されることが多いオープンソースLLMの中から、以下の条件を満たすモデルです。

- 実運用レベルの性能を持つこと

- 商用利用が現実的であること

- 2026年以降もアップデートやエコシステムの継続が見込めること

また、紹介するモデルを5つに絞ることで、比較の分かりやすさと意思決定のしやすさを優先しています。

企業導入におすすめのオープンソースLLM5選

① gpt-oss 120b 20b(OpenAI)

gpt-ossは、ChatGPTが使えない企業にとって最も現実的なオープンソースLLMです。OpenAIがApache 2.0ライセンスで公開したことで、GPT系モデルを社内環境で運用する選択肢が現実的になりました。

主な特徴

gpt-ossには、大規模モデルのgpt-oss-120bと軽量モデルのgpt-oss-20bがあります。gpt-oss-120bはMixture of Experts構造を採用し、最大128kトークンの長文脈処理に対応します。一方のgpt-oss-20bは約210億パラメータ規模で、GPUリソースが限られた環境でも扱いやすい設計です。両モデルともツール呼び出しや構造化出力に対応しており、業務システムへの組み込みを前提としています。

性能の方向性

gpt-oss-120bは、数学推論、一般知識、コード生成といった幅広い領域で安定した性能を示します。一部ベンチマークではOpenAIの商用モデルo4 miniと同等クラスとされ、汎用LLMとして完成度の高いモデルです。gpt-oss-20bも軽量モデルとしては性能が高く、文書要約や社内Q&Aなどの用途で十分に実用レベルにあります。

実運用のしやすさ

gpt-ossは、ローカル環境やオンプレミス運用を前提に設計されている点が強みです。

- 社外にデータを出さずに運用可能

- RAGや社内データ連携と相性が良い

- 小規模導入から段階的に拡張しやすい

とくにgpt-oss-20bは、検証用途やスモールスタートに適しています。

ライセンスと商用利用

Apache 2.0ライセンスで提供されており、商用利用、改変、再配布に制限はありません。オープンソースLLMの中でも、法務面の扱いやすさは非常に高い部類です。

向いている企業や用途

- 外部AIサービスの利用が制限されている企業

- 社外に出せないデータを扱う業務

- 社内向けAIアシスタントや業務支援ツール

2026年を見据えた基準モデルとして、まず検討対象に挙げやすい存在です。

② Qwen 3(Alibaba Cloud)

Qwen 3は、高性能と実用性を両立した企業向け万能型オープンソースLLMです。性能面だけでなく、ライセンスと運用自由度のバランスが非常に良く、企業導入への検討人は欠かせない存在となっています。

主な特徴

Qwen 3は0.6Bから235Bまで幅広いサイズ展開を持つモデルファミリーで、MoE構造モデルと密結合モデルの両方が提供されています。フラッグシップモデルであるQwen3 235B A22Bは、コード生成や数学推論で最先端クラスの性能を発揮します。

最大の特徴は、思考モードを切り替えられるハイブリッド推論です。高速応答を優先する場面と、段階的に推論する場面を用途に応じて使い分けられます。

性能の方向性

Qwen 3は推論、コード生成、一般的な文章生成まで幅広く高水準です。とくに複雑な指示や多段階の思考が必要なタスクで強みを発揮します。119言語で学習されており、多言語対応や翻訳用途でも安定した性能を示します。グローバル展開を視野に入れる企業にとっても扱いやすいモデルです。

実運用のしやすさ

サイズ展開が豊富なため、検証環境から本番環境まで段階的に導入しやすい点が特徴です。

- 小規模モデルでPoCを実施

- 要件に応じて大規模モデルへ移行

- 推論精度と応答速度を用途別に調整

この柔軟性は、2026年以降の長期運用を考える企業にとって大きなメリットになります。

ライセンスと商用利用

Qwen 3はApache 2.0ライセンスで提供されており、商用利用や改変、再配布に制限はありません。オープンソースLLMとしては非常に扱いやすく、法務面での不安が少ない点が評価されています。一部の超大規模モデルは提供形態に制限がありますが、全体としては純粋なオープンソース戦略が採られています。

向いている企業や用途

- 推論精度と応答速度の両立を求める企業

- コード生成や業務ロジック支援を重視する開発部門

- 多言語対応が必要な業務やプロダクト

性能、柔軟性、ライセンスのバランスという点で、Qwen 3は2026年基準の有力候補と言えるモデルです。

③ DeepSeek-R1(DeepSeek)

DeepSeek-R1は、推論性能を最優先する企業や研究用途で注目される推論特化型オープンソースLLMです。2025年以降、オープンソースLLMが「汎用」から「役割特化」に分化する中で、推論分野の基準点となる存在です。

主な特徴

DeepSeek-R1は、MoE構造を採用したDeepSeek-V3をベースに、独自の強化学習手法によって推論能力を重点的に強化したモデルです。単なる応答生成ではなく、段階的に考え、検証しながら結論に至る挙動を重視して設計されています。

また、R1は単体モデルとしてだけでなく、知識蒸留の元モデルとしても活用されており、オープンソースエコシステム全体への影響力が大きい点も特徴です。

性能の方向性

DeepSeek-R1の最大の強みは、数学的推論や論理問題における高い精度です。AIMEやMATH系ベンチマークでは、GPT-4クラスや商用推論モデルに匹敵、あるいは上回る結果が報告されています。

一方で、汎用的な文章生成や会話の自然さよりも、正確な推論結果を出すことを重視する設計となっており、用途によって向き不向きがはっきり分かれます。

実運用のしやすさ

DeepSeek-R1は高性能な推論を実現する一方で、モデル規模は比較的大きく、運用には相応の計算資源が必要です。

- 高精度な推論タスクに特化した利用が前提

- 汎用チャット用途には過剰性能になりやすい

- 蒸留モデルを活用すれば軽量化も可能

「すべての業務を1モデルで賄う」よりも、役割を限定して使う運用が現実的です。

ライセンスと商用利用

DeepSeek-R1はApache 2.0ライセンスで公開されており、商用利用や改変、再配布に制限はありません。推論特化モデルとしては、法務面の扱いやすさも大きな利点です。

向いている企業や用途

- 数学、論理、評価系タスクを扱う業務

- 高精度な判断や検証をAIに任せたいケース

- 他モデルの推論性能を底上げする蒸留用途

DeepSeek-R1は万能モデルではなく「推論性能の物差し」として位置づけることで、2026年以降も価値を発揮するモデルです。

④ Llama 4(Meta)

Llama 4は、性能面ではオープンソースLLMの最上位クラスに位置する一方、ライセンス制約が明確なモデルです。

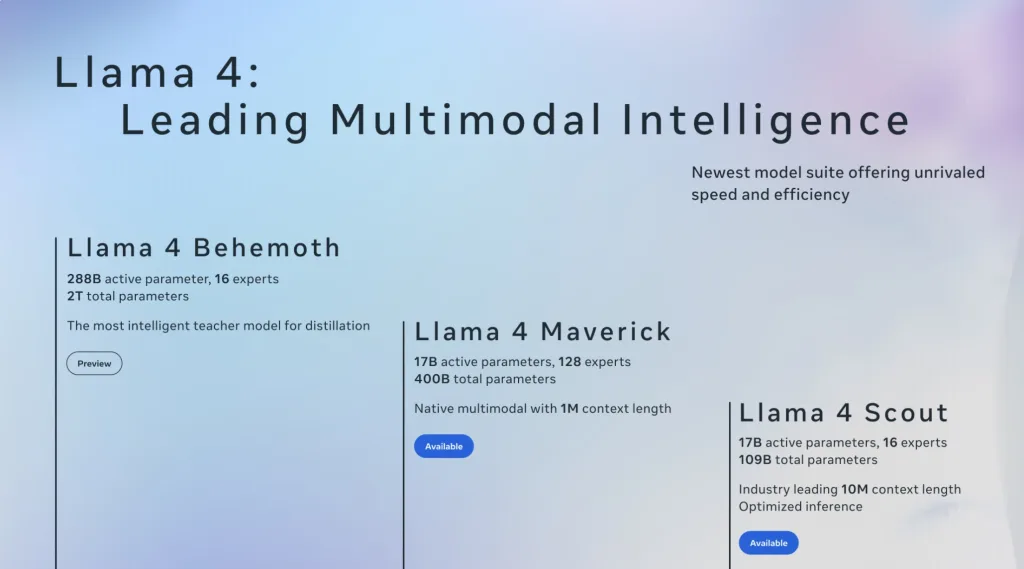

主な特徴

Llama 4はMixture of Experts構造を採用し、テキストだけでなく画像入力にも対応するマルチモーダルLLMです。モデルはScoutとMaverickの2系統があり、Maverickは総パラメータ数4000億級という非常に大規模な設計になっています。

とくに長文脈処理能力が特徴で、Scoutは数百万トークン級、Maverickも約100万トークンのコンテキストを扱えるとされています。大規模ドキュメントや複雑な履歴を一括処理したい用途では大きな強みになります。

性能の方向性

Llama 4は、文章生成、コード生成、画像理解まで幅広いタスクで高い性能を示します。一部評価では商用最先端モデルに迫る、あるいは上回る結果も報告されており、純粋な性能という観点ではトップクラスです。

ただし、ベンチマーク結果の一部は最適化された非公開構成によるものとされており、実運用では構成やチューニング次第で差が出やすい点には注意が必要です。

実運用のしやすさ

モデル規模が非常に大きいため、運用には相応のインフラが求められます。

- 高性能GPUを複数台用意する必要がある

- 小規模環境でのスモールスタートには不向き

- 研究用途や大規模プロジェクト向け

性能重視の一方で、導入ハードルは高めです。

ライセンスと商用利用

Llama 4はMeta独自のCommunity Licenseで提供されます。商用利用自体は可能ですが、月間アクティブユーザー数が一定規模を超えるサービスでは、追加の許諾が必要になります。

また、モデル出力を他モデルの学習に利用することが禁止されている点も、企業利用では重要な注意点です。性能が高い分、ライセンス条件を正確に理解した上での利用が不可欠です。

向いている企業や用途

- 性能を最優先する大規模プロジェクト

- 長文脈やマルチモーダル処理が必須の業務

- ライセンス管理を前提に運用できる組織

Llama 4は、性能最重視だが制約も受け入れられる企業向けの選択肢として位置づけられます。

⑤ Mistral Small 3.2(Mistral AI)

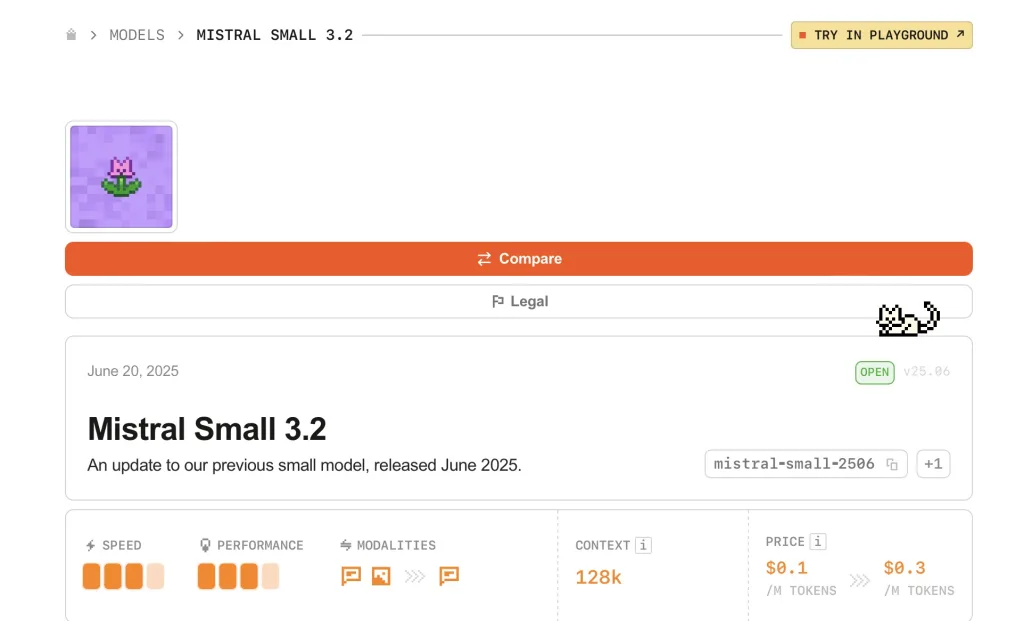

Mistral Small 3.2は、性能と運用コストのバランスが良い実務向けオープンソースLLMです。

2026年を見据えた比較では、巨大モデルや推論特化モデルとは別に、現場で回しやすい選択肢として価値があります。

主な特徴

Mistral Small 3.2はパラメータ数24B級の中型モデルで、長文脈処理(最大128k)と画像入力に対応します。指示追従性や安定性が改善され、関数呼び出しなどの実装面でも扱いやすさが意識されています。「大きすぎないモデルで、実務品質を出す」という思想がはっきりしており、業務利用での取り回しが良い点が特徴です。

性能の方向性

Mistral Small 3.2は、汎用的な文章生成や要約に加え、コード生成でも高い水準を狙えるモデルです。超大規模モデルのような圧倒的推論力ではなく、日常業務に必要な品質を安定して出す方向性に強みがあります。RAG構成で社内文書を扱う用途や、業務アシスタントのベースモデルとして相性が良いタイプです。

実運用のしやすさ

24B級は、企業がオンプレや閉域で運用する際に現実的なサイズ感です。

- 推論コストと品質のバランスが取りやすい

- PoCから本番までスケールしやすい

- RAGやツール連携の運用設計に乗せやすい

最先端の巨大モデルほどのインフラを必要とせず、導入ハードルが抑えられる点が評価ポイントになります。

ライセンスと商用利用

Apache 2.0ライセンスで公開されており、商用利用、改変、再配布に制限はありません。法務面の扱いやすさという点でも、企業が採用しやすいモデルです。

向いている企業や用途

- 社内文書の要約、検索、FAQなどを安定運用したい企業

- RAG型の社内アシスタントを作りたい組織

- 大規模GPU環境がなく、現実的なコストで始めたいケース

Mistral Small 3.2は、2026年の実務運用で最も扱いやすい候補の1つと言えます。

5つのモデルをわかりやすく比較

| モデル | 強み | 注意点 | ライセンス | 商用利用 | こんな企業におすすめ |

|---|---|---|---|---|---|

| gpt-oss 120b 20b | 汎用力が高く社内AIの基準になりやすい | 120bは計算資源が必要 | Apache 2.0 | 可 | ChatGPTが使えず、まず失敗しない土台が欲しい企業 |

| Qwen 3 | 推論の深さと速度を使い分けやすい万能型 | 提供形態や運用ポリシーは事前確認が必要 | Apache 2.0 | 可 | 用途が広く、部署ごとに使い分けたい企業 |

| DeepSeek-R1 | 推論特化で数学や検証系に強い | 汎用チャット用途では過剰になりやすい | Apache 2.0 | 可 | 推論精度が最優先で、評価や検証タスクが多い企業 |

| Llama 4 | 高性能、長文脈や画像対応も視野に入る | ライセンス制約とインフラ負荷が重い | Community License | 条件付き | 性能最重視で、ライセンス管理も出来る大規模企業 |

| Mistral Small 3.2 | 実務で回しやすいサイズ感と安定性 | 最上位の推論力を求める用途には不向き | Apache 2.0 | 可 | まず社内活用を現実的コストで定着させたい企業 |

まとめ:2026年のオープンソースLLM選定で重要なこと

2026年を見据えたオープンソースLLM選定では、単純な性能比較よりも、どのモデルをどの業務に使うかという整理が重要になります。最先端性能を持つモデルが増えた一方で、すべての企業にとって最適な万能モデルは存在しません。企業利用では、以下の視点がとくに重要です。

- 社外にデータを出さずに運用できること

- 商用利用や将来運用に不安のないライセンスであること

- 自社のインフラや体制で無理なく回せること

本記事の比較を参考に、2026年以降も継続して使える生成AI基盤を検討していきましょう。