2025年最新オープンソースLLM完全ガイド:性能・ライセンス・実用性を徹底比較

本記事では、2025年に登場した代表的なオープンソースLLMを徹底比較します。各モデルの技術的特徴や性能指標はもちろん、実際の開発現場で重要となるライセンス条件や商用利用の可否まで、意思決定に必要な情報を網羅的に解説するので、最適なモデル選択を行うための実践的ガイドとしてご活用ください。

- ①Meta社 Llama 4:大規模コンテキスト処理と画像認識を実現

- ②Mistral AI社 Mistral Small 3.2:小型でも驚異的な効率と精度を両立

- ③Google DeepMind社 Gemma 3:軽量かつ多言語対応の汎用モバイルLLM

- ④Alibaba社 Qwen 3:思考モードを切り替える“ハイブリッド推論”AI

- ⑤DeepSeekチーム DeepSeek-R1:オープンLLMで初のGPT-4級推論力

- ⑥OpenAI gpt-oss-120b / gpt-oss-20b:完全オープンなApacheライセンス版GPT

- ⑦Microsoft Phi-4 ファミリー:軽量・高推論・MITライセンスの万能モデル

- オープンソースのLLMモデルの比較表

- まとめ: オープンソースLLM

①Meta社 Llama 4:大規模コンテキスト処理と画像認識を実現

Meta社のLlama 4シリーズではアーキテクチャにMixture-of-Experts(MoE)を採用し、テキストだけでなく画像入力にも対応するマルチモーダル機能を備えています。

Llama 4の主な特徴

Llama 4はMeta社が公開した最新世代のLLMで、アーキテクチャにMixture-of-Experts(MoE)を採用し、テキストと画像入力に対応するマルチモーダル機能を備えています。

モデルは2種類あり、総パラメータ1090億(アクティブ約170億)の「Scout」と、総パラメータ4000億(アクティブ約170億)の「Maverick」が存在します。Maverickは最大約100万トークン、Scoutはさらに長い1000万トークンものコンテキスト処理が可能とされ、大規模なドキュメントや複雑な対話履歴も一度に処理できます。

Llama 4の性能

Meta社は一部ベンチマークでLlama 4がOpenAIのGPT-4oを上回ったと発表しています。とくに「LMArena」評価ではGPT-4oを凌駕したとされますが、これは会話最適化された非公開版での結果であり、公開モデルとの差異が指摘されています。

とはいえ4000億パラメータ級モデルをオープン提供した点は画期的で、コード生成や数学問題など幅広い領域でGPT-4に迫る高い実力を発揮しています。

Llama 4のライセンスと商用利用

Llama 4はMeta独自の「Community License」で提供されます。月間アクティブユーザー7億人を超えるサービスでの商用利用は制限されているため、別途許諾が必要です。

また、出力を他モデルの学習に用いることは禁止されており、中小規模の開発者にとっては利用しやすい一方、大規模プラットフォーム企業には制約が課される仕組みになっています。

②Mistral AI社 Mistral Small 3.2:小型でも驚異的な効率と精度を両立

2025年6月に公開されたMistral Small 3.2はパラメータ数240億の比較的小型なモデルですが、独自の最適化により非常に高効率かつ高性能を実現しています。

Mistral Small 3.2の主な特徴

Mistral Small 3.2はフランスのMistral AI社が公開したパラメータ数240億の中型モデルです。前身のMistral 3.1はLlama 3.3(700億パラメータ)と同等の品質を示しつつ応答速度で勝る性能を持っていました。

3.2では指示追従性や安定性が改善され、関数呼び出しの信頼性も向上。HumanEvalベンチマークで正解率92.90%を達成し、プログラミング性能も強化されています。最大128kトークンの長文脈処理と画像入力対応も備え、RAGやマルチモーダルエージェント用途にも適しています。

Mistral Small 3.2の性能

3.1からの改良により、無限ループ的応答の緩和や指示従順度の向上が確認されています。さらに軽量ながらOpenAI GPT-4o miniと比べても品質と応答速度で優位性を持ち、効率性と性能の両立が特徴です。

Mistral Small 3シリーズのライセンスと商用利用

Apache 2.0ライセンスで公開され、商用・非商用問わず自由に利用可能です。改変や再配布も制限されないため、中小企業やスタートアップにとってコスト効率の高い選択肢となっています。

③Google DeepMind社 Gemma 3:軽量かつ多言語対応の汎用モバイルLLM

Google DeepMindのGemma 3ファミリーはGoogle社内の最先端モデル「Gemini」の技術を活用しつつ、軽量で効率的なモデルとして設計されています。

Gemma 3の主な特徴

Gemma 3はGoogle DeepMindが公開したオープンモデル群で、軽量かつ効率性を重視した設計です。テキストに加えて画像入力に対応するマルチモーダルモデルで、パラメータ規模は2.7億〜270億まで複数ラインナップ。最大モデルでも単一GPU/TPUでリアルタイム動作可能な効率性を実現しています。

コンテキスト長は最大128kトークン、多言語対応は約140言語と広範囲で、翻訳や国際的なQAシステムに適しています。モバイル向け「Gemma 3n」も提供され、エッジデバイスでも利用可能です。

Gemma 3の性能

270億モデルは14兆トークンで訓練され、同規模の他モデルを上回る効率性を発揮。テキスト生成、要約、推論に加え、画像分析や説明も可能です。Googleは効率と精度の両立を強調しており、開発者コミュニティから高い評価を受けています。

Gemma 3のライセンスと商用利用

「Gemma License」というGoogle独自のライセンスで提供され、商用利用は可能ですが、Googleが不正利用を検知した場合に利用を停止する権利を保持しています。中小規模の利用には大きな問題はありませんが、ミッションクリティカルな用途ではリスク管理が求められます。

④Alibaba社 Qwen 3:思考モードを切り替える“ハイブリッド推論”AI

中国Alibaba Cloud(阿里云)が2025年4月に公開したQwen 3シリーズは、「ハイブリッド推論」能力を特徴とする最新世代のオープンソースLLMです。

Qwen 3の主な特徴

Alibaba Cloudが公開したQwen 3シリーズは、0.6億〜2350億パラメータまで8種類のモデルを一挙公開した大規模ファミリーです。MoEと密結合モデルが含まれ、フラッグシップのQwen3-235B-A22Bはコード生成や数学タスクで最先端モデルに匹敵。思考モードを切り替え可能な「ハイブリッド推論」が特徴で、迅速な応答と段階的な内省型推論を使い分けられます。

Qwen 3の性能

複雑な課題では思考モードを活用し精度を向上、簡単な質問には高速応答する柔軟性を持ちます。119言語で学習され、翻訳や多言語QAに強みを発揮。36兆トークン規模の学習データを背景に、中国国内では最強クラスのオープンモデルと評価されています。

Qwen 3のライセンスと商用利用

Apache 2.0ライセンスで提供され、商用利用・改変・再配布が自由です。Alibabaは公式に商用利用を認め、Hugging Faceなどで重みを配布しています。なお一部高度モデルは規制のためAPI限定ですが、全体として純粋なオープンソースとして世界的にも注目されています。

⑤DeepSeekチーム DeepSeek-R1:オープンLLMで初のGPT-4級推論力

DeepSeek-R1DeepSeek-R1は、2025年初頭にDeepSeekと呼ばれる研究チーム(おそらく中国発のスタートアップ)から公開されたオープンソースLLMです。

DeepSeek-R1の主な特徴

DeepSeekチームが公開したオープンソースLLMで、論理的推論力を強化するため独自の強化学習「GRPO」を導入。ベースモデルはMoE構造のDeepSeek-V3で、自己検証型の学習を通じて高度な思考力を獲得しました。

DeepSeek-R1の性能

AIME 2024で79.8%の高スコアを記録し、GPT-4やClaudeを上回る結果を示しました。MATH-500やSWE-benchでもOpenAIの推論特化モデル「o1」に匹敵し、「GPT-4並みの推論力を持つ初のオープンLLM」として注目されました。また、小型モデルへの知識蒸留にも活用され、オープンコミュニティ全体の性能向上に寄与しています。

DeepSeek-R1のライセンスと商用利用

当初はMITライセンスで公開され、現在はApache 2.0に移行。商用利用や改変・再配布が完全に自由で、企業によるサービス組み込みも可能です。実際にR1を基盤とした小型モデルがコンテストに登場するなど、幅広い応用が進んでいます。

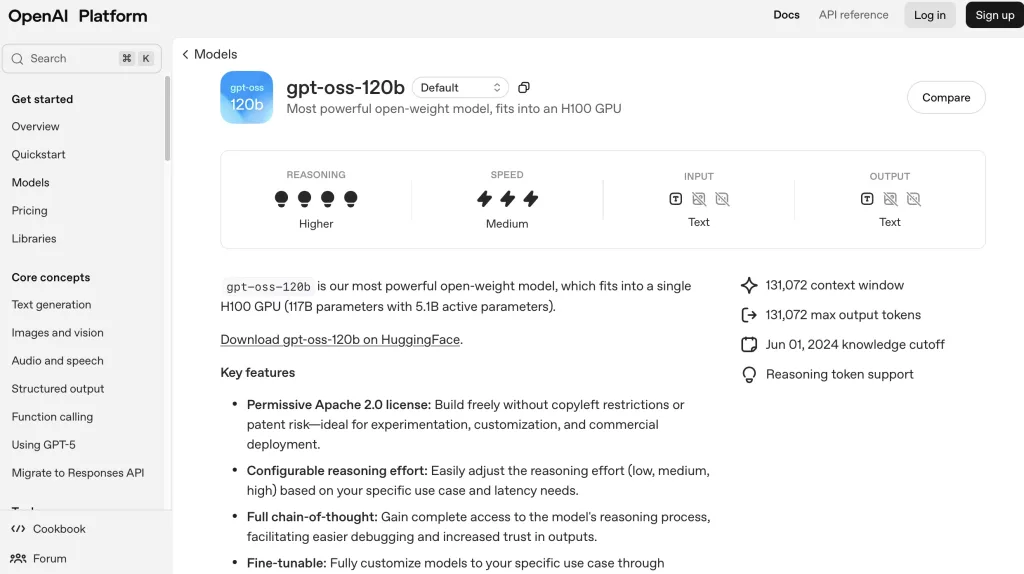

⑥OpenAI gpt-oss-120b / gpt-oss-20b:完全オープンなApacheライセンス版GPT

gpt-ossシリーズのラインナップには、大規模な「gpt-oss-120b」と軽量な「gpt-oss-20b」が用意されています。

gpt-ossの主な特徴

gpt-oss-120bは約1170億パラメータを持つMixture-of-Experts(MoE)構造のモデルで、最大128Kトークンの長文脈処理が可能です。計算効率の高さから、単一の80 GB GPU上でも動作できるよう最適化されています。

一方、gpt-oss-20bは約210億パラメータの軽量モデルで、16 GBメモリを搭載したノートPCやスマートフォンでも動作可能な省リソース設計が採用されています。

gpt-ossの性能

性能面では、gpt-oss-120bがOpenAIの自社モデル「o4-mini」に匹敵する実力を示し、数学(AIME 2024/25)、一般問題(MMLU、HLE)、コード生成(Codeforces)、医療情報(HealthBench)といった多様なベンチマークで高い評価を獲得しました。

また、gpt-oss-20bも「o3-mini」と同等、あるいはそれ以上の性能を発揮しており、小規模環境でも先端的なAI処理を可能にしています。

gpt-ossシリーズのライセンスと商用利用

完全オープンなApache 2.0ライセンスで提供され、商用・非商用問わず自由に利用できる点が大きな特徴です。

⑦Microsoft Phi-4 ファミリー:軽量・高推論・MITライセンスの万能モデル

Microsoft Researchが開発したPhi-4シリーズは、軽量かつ高効率でありながら高度な推論性能を備えたオープンソースLLMファミリーです。

Phi-4(基本モデル)

Phi-4は14Bパラメータ規模の基盤モデルで、コンテキスト長は16kトークンに対応しています。合成データや高品質なパブリックドメインデータ、学術書・Q&Aを組み合わせたデータセットでトレーニングされ、SFT(教師あり微調整)とDPO(直接的選択最適化)により安全性と指示追従性を強化。MMLU(84.8)、MATH(80.4)、HumanEval(82.6)といったベンチマークで高い性能を記録しており、汎用モデルとして優れた基盤を提供します。

Phi-4-Reasoning / Phi-4-Reasoning-Plus

推論特化型のモデル群で、前者はPhi-4をベースにSFTで調整されたもの、後者はさらにRLを導入して強化されています。AIMEや科学分野の難問ベンチマークにおいて、DeepSeek-R1系の大規模モデルを上回る性能を発揮。計算資源の限られた環境でも高い推論力と効率を両立できる点が強みです。

Phi-4-Mini-Reasoning

3.8Bパラメータの軽量モデルながら、128kトークンという超長文脈処理に対応。DeepSeek-R1などの高性能モデルからの蒸留と合成データを活用することで、小型ながら高度な数学推論能力を実現しています。教育用途やモバイル・エッジ向け推論アプリケーションに適しており、省リソース環境でも活躍します。

Phi-4-Mini-Instruct

同じく3.8Bパラメータ・128kトークン対応の軽量モデルですが、こちらは指示追従性能を重視した設計です。合成データとパブリックドメインデータを用いたSFT・DPOによって安全性と安定性が高められ、MMLU-Pro、GPQA、ARC、BoolQなど多様なベンチマークで、Llama 3.2-3BやMistral-3Bなどの同規模モデルに競合あるいは優位な成績を収めています。

ライセンスと商用利用

Phi-4ファミリーはすべてMITライセンスで公開されており、商用利用に制限はありません。軽量から推論特化まで幅広いバリエーションを持つため、教育分野からエッジ環境、研究開発、商用アプリケーションまで幅広い用途に展開できるのが特徴です。

オープンソースのLLMモデルの比較表

以下の表に、各モデルの主な特徴、性能面のポイント、ライセンス形態、および商用利用可否をまとめます。

| モデル名(公開元) | 主な性能・特徴 | ライセンス形態(制限) | 商用利用 |

|---|---|---|---|

| Llama 4(Meta) | MoE構造、最大10Mコンテキスト、画像対応、GPT-4級の性能 | Community License(重い制限あり:7億MAU超は要許諾、流用制限あり) | 制限付き |

| Mistral Small 3.2 | 24B、画像対応、128K長文、優れた応答・コード生成性能 | Apache 2.0(制限なし) | 可能 |

| Gemma 3(Google DeepMind) | 最大27B、画像対応、128K長文、多言語対応、効率良好 | Gemma License(Googleが利用停止可能) | 条件付き (実質可) |

| Qwen 3(Alibaba) | 0.6B~235B MoE、ハイブリッド推論モード、119言語対応、最先端性能 | Apache 2.0(制限なし) | 可能 |

| DeepSeek-R1(DeepSeek) | MoEベース、RL強化で推論力高、数学・コード性能GPT-4超、蒸留応用も成功 | MIT(制限なし) | 可能 |

| gpt-oss-120b / 20b(OpenAI) | MoE構造、20B/117B規模、128K長文、ツール対応、超高効率&高性能 | Apache 2.0(制限なし) | 可能 |

| モデル名(公開元) | 特性・性能概要 | ライセンス形態 | 商用利用 |

|---|---|---|---|

| Phi-4(Microsoft) | 14B、16K文脈、数学・コード・推論性能高 → MMLU 84.8/HumanEval 82.6など | MIT ライセンス(完全寛容) | 可 |

| Phi-4-Reasoning / Plus | 推論特化、AIME や科学難問で 70B/671B の大モデルを上回る性能 | MIT(完全寛容) | 可 |

| Phi-4-Mini-Reasoning | 3.8B、128K文脈、小型・省資源ながら数学推論◎ | MIT(完全寛容) | 可 |

| Phi-4-Mini-Instruct | 3.8B、128K文脈、指示追従・多ベンチマークで高性能 | MIT(完全寛容) | 可 |

まとめ: オープンソースLLM

急速に進化するLLMのオープンソース領域では、性能と実用性で選択肢が広がる一方、ライセンスの内容にも注意が欠かせません。技術者や研究者は、自身のプロジェクトに適したモデルを性能面とライセンス面の双方から検討することが重要です。それぞれのモデルの特色を踏まえ、オープンソースLLMを賢く活用していきましょう。