自社データを漏らさない、ローカル環境で動く最先端の生成AI

お困りですか ?

✓ 生成AIで顧客データを活用したいがデータ漏洩は大丈夫?

✓ 入力データは生成AIの学習に利用されるのでは?

ローカルLLMに関して音声で理解したい方は以下の音声をご利用ください(再生ボタンをクリックすると音声が流れ始めます。音量にご注意ください)。

知財とセキュリティを守りながら、ビジネスを加速する

Microcosmならセキュリティとコストパフォーマンスを両立します

オープンソースの大規模言語モデル(LLM)を使って社内完結型のAI環境を構築

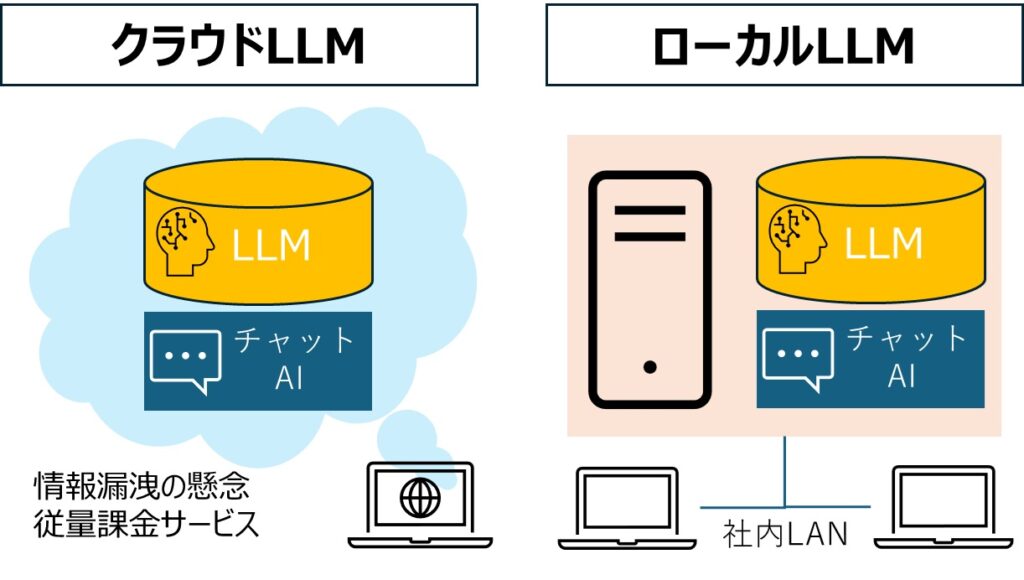

なぜいま、ローカルLLMなのか?

ローカルLLMとはインターネットを介さず、社内ネットワーク内で稼働する生成AIです

① 機密データの完全保護

- 社内ネットワークで完結

情報漏洩リスクを最小限に抑え、セキュリティ体制を強化。 - 高度なプライバシー保護

顧客データだけではなく、医療や金融など、機密性の高いデータを取り扱う企業に最適。

② 社内データの活用が容易

- RAGで社内データを直接活用

自社のドキュメントやデータを外部に渡すことなく、社内の生成AIへ組み込み可能。

社内固有の知識をモデルに反映し、高精度な回答を得られる。 - 業界別規制に対応

業界規制やコンプライアンスを遵守した運用がしやすく、信頼性を担保。

RAG(Retrieval Augmented Generation):LLMに外部情報の検索を組み合わせる技術

③ コスト最適化

- API利用料ゼロ

ChatGPTなどの外部APIを使用すると年々コストが増加するが、ローカル環境では不要。 - 利用状況に応じた柔軟な運用

必要な利用者アカウント分だけを導入でき、無駄な支出を抑えられる。

④ 出力内容のコントロール

- 出力フォーマットの指定

議事録や稟議書など、既定のフォーマットを登録して、出力内容を指定可能。

※開発中の機能です

鉄壁のセキュリティで自社データを守る

特許取得のセキュリティ技術

- ハッキングや中間者攻撃を遮断する独自技術

- データ改ざんを検知・防止する仕組み

情報漏洩リスクを極小化

- 堅牢なネットワーク構築と暗号化技術

- 社内完結型のシステム設計で、外部の脅威からデータを守る

※特許技術に関しましては、現状はMicrocosomのデスクトップアプリ版では適用しておらず、WEB版でセキュリティを通常よりも強固にしたいというご要望があった際に、カスタマイズ対応となります。

ローカルLLM活用のユースケース

① 製造業

製造業のノウハウ継承

課題: 熟練技術者のノウハウ継承

ソリューション: 設計図、報告書、技術文書を学習させ、若手技術者をサポート

効果: ベテランの思考プロセスを可視化し、安定した品質と生産性向上を実現

② 金融

金融業の顧客対応

課題: 多様化する顧客ニーズへの対応

ソリューション: ローカルLLMで顧客属性・取引履歴・市場動向を学習し、セグメント毎の最適提案を自動化

効果: One-to-Oneマーケティングを強化し、顧客満足度向上と収益拡大を同時に実現

③ 医療

医療データの活用

課題: 症例データや論文情報の分析に膨大な時間が必要

ソリューション: 機密性の高い医療データをローカルLLMで安全に解析

効果: 疾患予測・創薬ターゲット探索を加速し、医療イノベーションに貢献。患者のプライバシーも徹底保護

貴社の状況に応じた柔軟なスタートが可能

- カスタマイズ性の高さ

- 大規模言語モデルを貴社専用に調整可能

- 業種・規模・目的に合わせた最適化で高い精度を実現

- 柔軟な開発体制

- PoCから本格導入までを一貫してサポート

- 短期の検証から長期運用まで、段階的に構築可能

- 最適なサーバー設計

- 必要最小限のリソースから始め、スモールスタートが可能

- 大規模データ処理に耐えうる拡張性のあるGPUサーバー構築

導入までのステップ

①要件ヒアリング

- オンライン会議で現在の課題やご要望を詳細にお伺いします

- お見積のご提示

②PoCの実施

- スモールスタートでの試験導入、効果測定

- 定期的なモデルアップデート

③本格導入設計

- サーバー構築、モデル最適化、運用保守体制の確立

- 必要に応じた追加カスタマイズとメンテナンス

お問合せ方法

まずは、ローカルLLM導入の可能性を一緒に探りませんか?

ローカル環境でのAI活用は、機密データを外に出さずにビジネスを変革する大きなチャンスです。セキュリティ面での不安やコスト面の悩みを解決しながら、自社独自のナレッジを最大限に活用しましょう。

販売:フィクスドスター株式会社 開発:株式会社ナンバーワンソリューションズ

【よくある質問】

Q1: ローカルLLMの導入費用は、どのくらいかかりますか?

A: 初期費用120万円~でご提供しております。ただし、システム規模、機能、データ量、カスタマイズの程度によって異なります。まずは御社の課題やご要望を伺い、最適なプランとお見積もりをご提示いたします。お気軽にお問い合わせください。

Q2: 機密性の高いデータも、安心して扱えますか?

A: はい。当社のローカルLLMは、御社のサーバー内に構築するため、データは社外に一切流出しません。また、特許取得のセキュリティ技術で、情報漏洩リスクを最小限に抑えますのでご安心ください。

Q3: 開発期間はどのくらいかかりますか?

A: システム規模や機能、データ量にもよりますが、通常3ヶ月~6ヶ月程度が目安となります。ただし、PoC (概念実証) など、短期間で効果検証を行うことも可能です。まずはお気軽にご相談ください。

Q4: 導入後のサポート体制はどうなっていますか?

A: システムの安定稼働を支援するため、導入後の運用サポートも万全です。定期的なシステムメンテナンス、トラブルシューティング、技術的なお問い合わせなど、お気軽にご相談ください。

Q5: 自社のデータで、LLMを学習させることはできますか?

A: はい。御社の業務データや専門知識を学習させることで、より精度の高い、業務に特化したローカルLLMを構築できます。データの種類や量、学習方法など、お気軽にご相談ください。

Q6: クラウドLLMと比べて、どのようなメリットがありますか?

A: 主なメリットは、セキュリティの高さ、コンプライアンス遵守、出力内容の制御、独自データによる最適化、コスト最適化などです。御社の課題や目的に最適なLLM導入を支援いたします。

Q7: まずは、簡単な検証から始めたいのですが可能ですか?

A: もちろんです。小規模なPoCを通じて、御社環境におけるローカルLLMの効果や実現可能性を検証できます。お気軽にご相談ください。