AIの進化により、最新の大規模言語モデル(LLM)を自分のパソコンで動かせる時代になりました。プライバシーを守りながら、インターネット接続なしでAIの力を活用したい方にとって、ローカルLLMは理想的な選択肢です。

本記事では、人気の高い2つのローカルLLMツール「Ollama」と「LM Studio」の特徴、対応モデル、使い方を徹底比較し、あなたに最適なツールを選ぶための情報を提供します。

この記事の内容は上記のGPTマスター放送室でわかりやすく音声で解説しています。

OllamaとLM Studioの基本比較

OllamaとLM Studioはどちらもローカル環境でLLMを実行できるツールですが、設計思想や対象ユーザーに違いがあります。主要な違いを以下の観点から比較します。

ユーザーインターフェースと操作性

Ollama: コマンドラインを中心とした操作方法を採用しており、シンプルで軽量なインターフェースが特徴です。技術者やコマンドに慣れたユーザーにとって効率的な操作が可能です。

LM Studio: 直感的なグラフィカルユーザーインターフェース(GUI)を提供し、マウス操作だけでモデルの検索、ダウンロード、チャット機能の利用ができます。視覚的な操作を好むユーザーや初心者に適しています。

モデルの互換性と選択肢

- Ollama: 主要なオープンソースのLLMモデルをサポートしています。

- LM Studio: Hugging Faceなどから多様なモデルを検索・ダウンロードでき、幅広いモデルに対応しています。

プラットフォーム対応

- Ollama: macOS、Linux、Windows(プレビュー版)に対応しています。

- LM Studio: M1/M2/M3 Mac、Windows(AVX2対応プロセッサ搭載)、Linux(ベータ版)に対応しています。

Ollamaで利用可能なモデル

Ollamaは、独自のモデルや特定のオープンソースモデルに対応しています。具体的には、以下のようなモデルが利用可能です。

- Llama 2: Meta社が開発した大規模言語モデルで、テキスト生成や会話応答に優れています。

- Gemma 2: 特定分野に特化したモデルで、専門的なテキスト解析に適しています。

- Mistral: 高精度な言語理解を提供するモデルで、テキスト解析に強みがあります。

- Moondream 2: 感情分析や創造的なテキスト生成に適したモデルです。

- Neural Chat: 自然な対話を生成することが可能な会話特化型モデルです。

- Starling: 大規模データセットを用いた汎用モデルで、質問応答や知識検索に適しています。

- Code Llama: コード生成やバグ修正に特化したモデルです。

- LLaVA: 画像とテキストのマルチモーダル対応モデルで、視覚情報を処理可能です。

- Solar: 情報検索や質問応答に優れたモデルで、効率的な情報抽出が得意です。

これらのモデルは、Ollamaのプラットフォーム上で選択・ダウンロードして利用することができます。

LM Studioで利用可能なモデル

LM Studioは、Hugging Faceなどのプラットフォームから多様なモデルを検索・ダウンロードして利用できます。具体的には、以下のようなモデルが利用可能です。

- Swallow: 日本語対応のモデルで、13Bや70Bなどのパラメータサイズが選択可能です。

- Gemma 2: 27Bなどの大規模モデルが利用可能で、専門的なテキスト解析に適しています。

- Mistral-nemo: Mistral社とNVIDIA社が開発したモデルで、日本語チューニング版も存在します。

- その他のHugging Faceモデル: Hugging Face上で公開されている多様なモデルを検索・ダウンロードして利用できます。

LM Studioのユーザーインターフェースを通じて、これらのモデルを簡単に検索・ダウンロードし、利用することが可能です。

以下の記事では、小さくても優秀と言われるSakana AIの日本語モデルをLM Studioで動かす手順を説明しています。

Ollamaのインストール方法と使い方

Ollamaは、ローカル環境で大規模言語モデル(LLM)を実行できるツールです。以下に、Ollamaの基本的な使い方をステップバイステップでご紹介します。

ステップ1:Ollamaのインストール

- 公式サイトからダウンロード:Ollamaの公式ウェブサイトにアクセスし、使用しているオペレーティングシステム(Windows、macOS、Linux)に適したバージョンをダウンロードします。

- インストール:ダウンロードしたインストーラーを実行し、画面の指示に従ってインストールを完了させます。

ステップ2:モデルのダウンロード

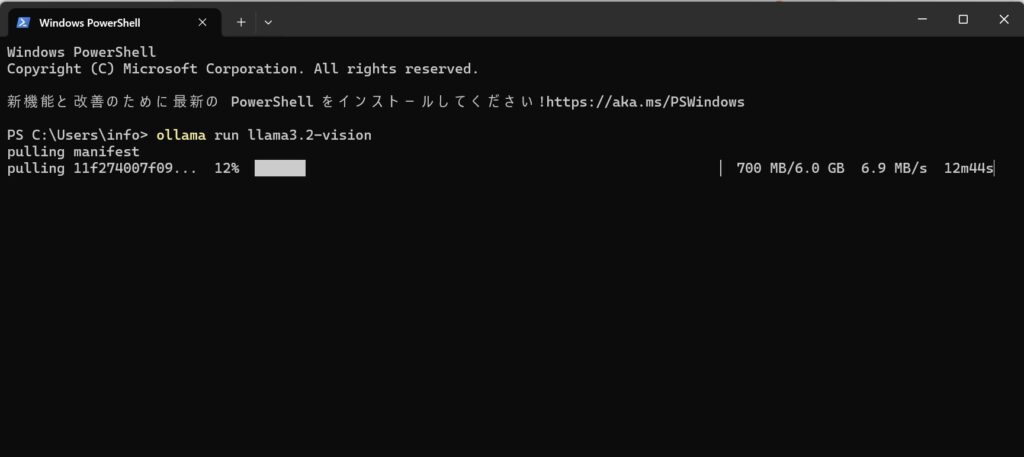

- ターミナルまたはコマンドプロンプトを開く:Ollamaがインストールされたことを確認したら、ターミナル(macOS、Linux)またはコマンドプロンプト(Windows)を開きます。

- モデルをプルする:以下のコマンドを入力して、使用したいモデルをダウンロードします。

ollama pull <モデル名>

例えば、Llama 3.2モデルをダウンロードする場合:ollama pull llama3.2-vision

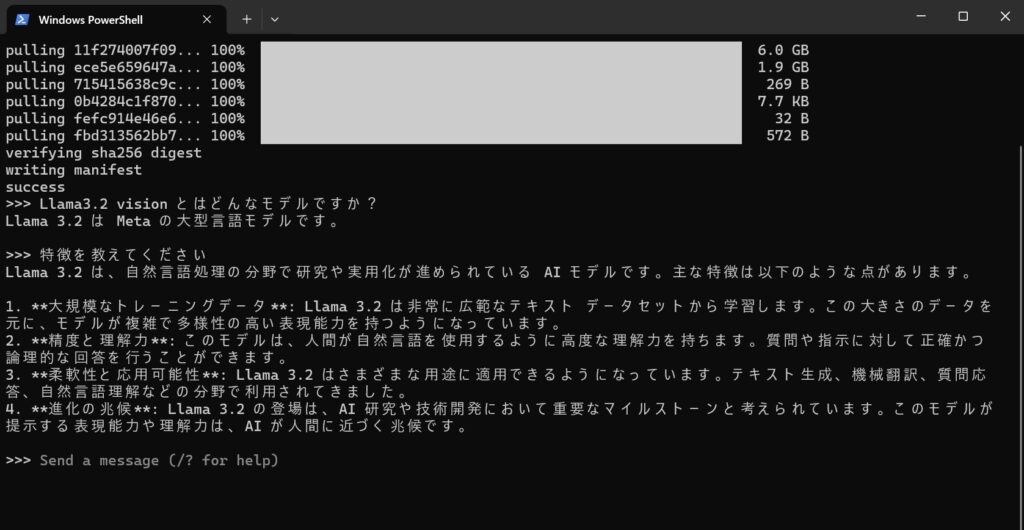

ステップ3:モデルの実行

- モデルを実行する:ダウンロードが完了したら、以下のコマンドでモデルを実行します。

ollama run <モデル名>

例えば、Llama 3.2モデルを実行する場合:ollama run llama3.2-vision - プロンプトを入力:モデルが起動すると、プロンプトが表示されます。ここで、モデルに対して質問や指示を入力し、応答を得ることができます。

LM StudioでDeepSeekを動かす方法

DeepSeek R1を日本語で追加学習させたモデルがありますので、そちらを使ってローカルLLMを構築する手順をまとめました。コマンドなどは必要なく、すべてマウスでクリックしてインストールできるので初心者向けです。

どちらを選ぶべき? OllamaとLM Studioの選択ガイド:まとめ

両ツールの特徴を比較した結果、あなたの状況に応じた最適な選択肢は以下のように考えられます:

OLLAMAがおすすめな方

- シンプルで軽量なツールを求めている方

- コマンドライン操作に抵抗がない方

- システムリソースを最小限に抑えたい方

- 厳選された高品質モデルだけを使いたい方

LM STUDIOがおすすめな方

- 視覚的で直感的な操作を好む方

- 多様なモデルを試してみたい探究心のある方

- Hugging Faceの豊富なモデルライブラリを活用したい方

- GUIベースの使いやすさを重視する方

どちらのツールも無料で利用でき、必要に応じて使い分けることも可能です。まずは自分の用途や好みに合わせて一方を試し、必要に応じてもう一方も検討してみるとよいでしょう。