医療業界での生成AI活用の背景

近年、ChatGPTをはじめとする生成AIが大きく注目を集めています。これらのAIは大規模な言語モデルを基盤とし、自然言語での入力に対して高度なテキスト生成、要約、質問応答などを行うことができます。医療現場では、電子カルテの情報整理や研究論文の検索・要約、医療従事者と患者とのコミュニケーションサポートなど、さまざまな活用が期待されています。

2. 生成AIの具体的な活用方法

2-1. 文献の要約と検索サポート

- 研究論文やガイドラインの要約

医療従事者は膨大な量の論文やガイドラインを参照する必要があります。生成AIを活用することで、論文や文献の要約を短時間で作成し、必要な情報を素早く得ることが可能になります。 - 類似ケースの検索サポート

過去に発表された症例や治療法を迅速に検索し、その内容をわかりやすくまとめることで、臨床判断の一助とすることができます。

2-2. カルテなどの医療文書の整理

- 電子カルテの入力支援

音声入力や自然言語入力で、患者の主訴やバイタル情報などを自動的に整理し、カルテに反映させるシステムが考えられます。これにより医師の入力時間が短縮され、診療効率が向上します。 - テキストマイニングによるインサイト抽出

病院で蓄積される多量の医療データから有用なインサイト(例えば患者ごとに最適な治療の示唆など)を抽出するために、生成AIと組み合わせたテキストマイニング手法が活用されることがあります。

2-3. 対話型アシスタント(患者向け・医療従事者向け)

- 患者向けチャットボット

症状や受診方法など、患者からの問い合わせに対して一次対応を行うAIチャットボットは、既に多くの病院やヘルスケア企業が導入を進めています。生成AIを活用することで、より自然でわかりやすい回答が提供可能になります。 - 医療従事者向けサポート

疑問点の照会やマニュアルの要約など、医療従事者が日常業務で必要とする情報に瞬時にアクセスできるようなアシスタントとしての利用も期待されています。

生成AI導入時の注意点

1. 個人情報保護・セキュリティ対策

医療情報は高度な個人情報にあたります。生成AIを導入する際は、個人情報保護法やGDPRなど国内外の規制に対応できるデータ管理体制が求められます。患者のデータをAIの学習に使用する場合は匿名化やセキュアなデータ転送を徹底し、外部クラウドと連携する際にも暗号化やアクセス制御などセキュリティ対策を十分に講じることが重要です。

2. 出力内容の正確性と監督

生成AIが出力する情報には誤りも含まれる可能性があります。医療分野の重要な判断は必ず医師や専門家が行う必要があり、AIの出力は参考情報として位置付けるのが基本です。

- AIのバイアス:学習データの偏りや不足により、診断や提案内容に偏りが生じる可能性があります。

- 最終的な責任の所在:AIの回答を鵜呑みにせず、医師や専門家が必ずレビューするフローを設けることが重要です。

3. 規制や倫理的側面への配慮

医療業界には薬機法や医師法など、多くの法的規制や業界規制があります。生成AIの利用シーンによっては、従来の医療システムと同様に規制当局の審査や届出が必要になる場合があります。また、患者に対して説明責任を果たすため、AIの活用方法や限界点を明確に伝え、医療の信頼性を損なわないよう配慮が求められます。

4. 運用コストと保守

生成AIの運用には、クラウド上のGPUリソースやオンプレミスの高性能サーバなどが必要になる場合があります。性能要件やセキュリティ要件を満たすためには、環境構築・運用コストやメンテナンス要員の確保も重要な検討ポイントです。

ローカル環境で動くLLM(生成AI)の例

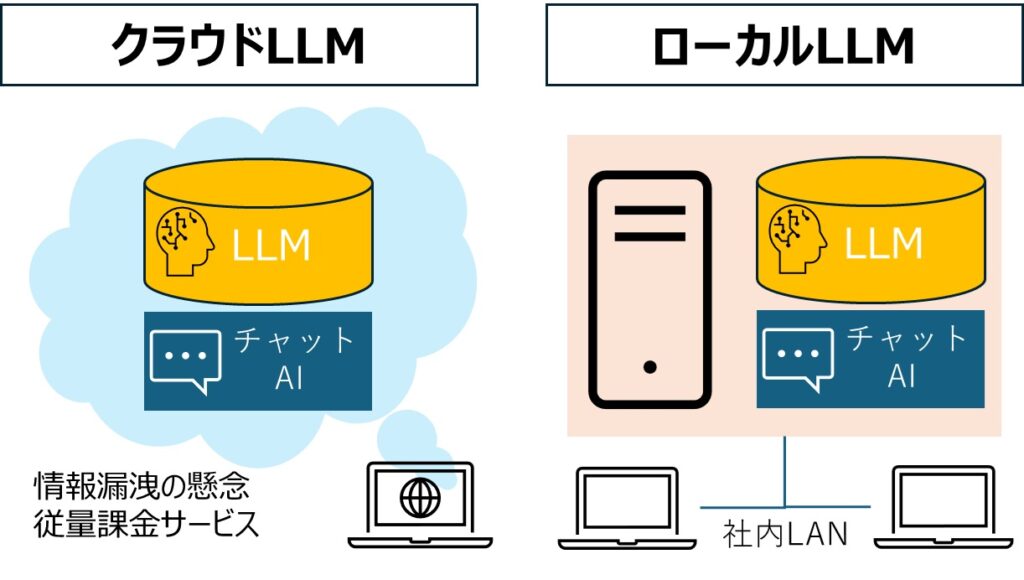

生成AIは多くの場合、クラウド上の強力なGPUサーバで動かされますが、近年はハードウェア性能の進歩や小型化されたモデルの登場により、ローカル環境で動作可能なLLMも増えてきました。以下では、その中の一例を紹介します。

1. LLaMA(Meta社が研究目的向けに公開)

- 概要:

- Meta(旧Facebook)が研究目的で公開した大規模言語モデルです。学習済みモデルの重みは研究申請を行うことでアクセス可能になります。商用目的の利用には制約がありますが、小規模モデルの場合はローカルPCでも動作が試せる点が特徴です。

- 特徴:

- GPT系モデルに近いアーキテクチャを採用し、比較的小規模パラメータのバージョンでも高い言語処理性能を発揮します。

2. GPT-Neo / GPT-J / GPT-NeoX(EleutherAI)

- 概要:

- オープンソースの大規模言語モデルを開発しているEleutherAIが公開している一連のモデル群です。Hugging FaceのTransformersライブラリなどと組み合わせてローカル環境で動かすことができます。

- 特徴:

- コードがオープンソースであり、学習済みモデルも公開されているため、研究やプロトタイプ開発に活用しやすいです。

3. Dolly 2.0(Databricks)

- 概要:

- Databricksがオープンソースとして公開した比較的コンパクトなLLMです。商用利用可能なライセンスで提供されているため、企業での利用もしやすいです。

- 特徴:

- ベースのモデルサイズは中規模ですが、日常的なQAタスクなどに十分対応可能とされます。ローカル環境でも動作しやすいように調整されています。

このように、情報漏洩のリスクを最小限にするため、ローカル環境(オンプレミス)で稼働する生成AIが進んでいます。WindowsやMacでも稼働するローカルLLMの導入も検討してみてはいかがでしょうか。

まとめ

医療業界で生成AIを活用することで、膨大な文献やデータの要約、患者対応の効率化、医療従事者向けアシスタントなど多岐にわたるメリットが期待されます。一方で、医療情報は秘匿性が高く重要な個人データを含むため、個人情報保護やセキュリティ対策の徹底が欠かせません。また、生成AIの出力をそのまま診断などに用いず、必ず専門家が監督する運用体制が必要です。

最後に、クラウド環境だけでなく、ローカル環境でも実行可能なLLMが存在する点を紹介しました。Dolly 2.0やLLaMAなどは、モデルサイズによっては個人のPCでも動作を試せる場合があり、データを外部に出さずに実験できるメリットがあります。医療分野ではプライバシーやセキュリティ面でローカル環境の活用が注目される可能性も大いにあります。今後、生成AIのさらなる進化とともに、医療業界での利活用も一層広がっていくでしょう。