「最新の社内データにアクセスできないAIモデル」「システムごとに必要な個別開発と煩雑な保守」――企業のAI導入現場では、こうした壁に直面するケースが急増しています。大規模言語モデル(LLM)の性能は飛躍的に向上していますが、それらを社内情報と安全かつ効率的に接続する方法が、今まさに喫緊の経営課題となっているのです。

そこで業界の注目を集めているのが、Anthropic社が提唱する「Model Context Protocol(MCP)」です。MCPは”AIと現実をつなげる標準規格”として、複雑だったAIと外部システムの連携を劇的に簡素化する可能性を秘めています。本記事では、MCPの仕組みや実装ノウハウを深掘りし、なぜこれが企業のAI戦略において重要な役割を果たすのかを探っていきます。

🎧この記事のポッドキャスト風の音声解説はこちら↓

MCPとは何か?—AIと外部システムを結ぶ共通言語

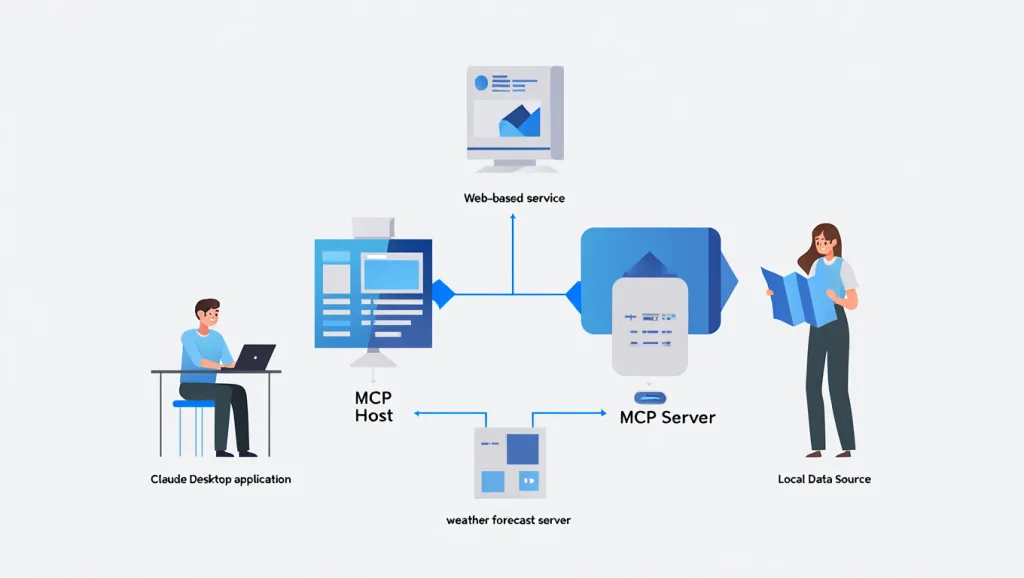

MCPとは、AIエージェント用のツール接続規格のようなものです。MCPにおいては、「AIを使う側(利用者)に近い立ち位置」がMCPホストで、「データや機能を提供する立ち位置」がMCPサーバーです。具体的には以下のイメージになります。

- MCPホスト(クライアント側)

- 大規模言語モデル(LLM)やAIエージェントを実行している環境

- MCPサーバーに対して「データを読みたい」「ツールを使いたい」とリクエストを送る側

- 例)AnthropicのClaude、MicrosoftのCopilotエージェント、あるいは社内のAIアプリケーション本体

- MCPサーバー(データ・ツール提供側)

- 外部サービスや社内システムを、MCP規格にもとづいて「接続先」として公開する仕組み

- AIエージェントからのリクエストに応じて、必要なデータを返したり、操作を実行したりする

- 例)Slack MCPサーバー、GitHub MCPサーバー、ファイルシステムのMCPサーバー、データベース用MCPサーバーなど

「共通言語」の提供で課題を解決

これまでツールやデータソースをAIモデルに繋げるには、それぞれ個別にカスタムAPIの実装や認証管理を行わなければならず、接続手段の乱立や保守コストの増大が大きな課題となっていました。

そこでAnthropic社が提唱したModel Context Protocol(以下MCP)は、こうした問題を解決するための「共通言語」を提供する仕組みとして生まれました。MCPはオープンソースで公開されており、LLMと外部リソースを同じルールで接続できるように統一規格を定めています。

具体的には、クラウドストレージやリレーショナルデータベース、ソースコード管理ツールなど、さまざまなデータソースやサービスを“サーバー”として定義し、LLMがそれらにアクセスしやすい標準化されたインターフェースを用意しているのです。

MCPを支える3つの核心要素

MCPによる外部データ連携は、明確に定義された3つの要素によって成り立っています。

- 1. リソース(情報提供機能):読み取り専用のデータをLLMに提示するための仕組み。例: ファイルの内容、データベースのクエリ結果、APIからの情報取得

- 2. ツール(操作実行機能):書き込みや変更を伴うアクションを実行するための仕組み。例: Slackへのメッセージ送信、GitHubへのコミット、検索エンジンの利用

- 3. プロンプト(指示提供機能):定型指示やコンテキスト情報をLLMに与えるための仕組み。例:操作マニュアル、応答形式のテンプレート、業務フロー情報

これら3要素が有機的に連携することで、AIは単なる会話モデルから、実世界のシステムと相互作用できる「エージェント」へと進化します。

LLMと外部リソースの橋渡し

MCPサーバー側では、これら3つの要素を定義した上で、LLM(あるいはAIエージェント)からのリクエストに応じて必要なデータを返したり、ツールを実行したりします。

たとえば「SlackのMCPサーバー」では、指定されたチャンネルの履歴を取得してリソースとして返すこともできますし、逆にツールとして「Slackにメッセージを投稿する」アクションを実行することも可能です。

大事な点は、すべての連携が同じインターフェース規格――つまりMCP――に準拠しているため、エージェント側から見れば違うサービス同士でも同じ手順で呼び出せるということです。

MCP導入のメリット

メリット1:ツール連携の標準化による開発・保守コストの削減

従来のAI開発では、こんな課題がありました。

- データベース、コードリポジトリ、社内チャットツールなど、各サービスごとに個別の接続実装が必要

- 接続先が増えるたびに、開発負担と保守コストが雪だるま式に増大

- 異なるシステムとの接続ごとにセキュリティ対策を講じる必要があり、リスク管理が複雑化

MCP(Model Context Protocol)を導入すれば、これらのツール連携を共通のプロトコルで標準化できます。AIエージェントやLLMは、MCP形式に準拠したインターフェースだけ理解すればよく、接続のたびに個別対応する必要がなくなるため、開発スピードの向上とコスト削減を同時に実現できます。

メリット2:既存コンポーネントの再利用と柔軟な拡張性

MCPはオープンソースであるため、すでに開発されたサーバー実装やSDKを**“車輪の再発明”なしに再利用可能**です。これにより、自社でゼロからすべてを作る必要がなくなり、開発効率が大幅に向上します。

さらに、ツールの使用シナリオ追加も容易です。例えば次のような業務改善が、MCPサーバーを追加登録するだけで実現可能になります。

- 開発部門:GitHubのプルリクエストを自動検知し、AIがコードレビューを実施して指摘事項をまとめる

- 営業部門:Slackで顧客から寄せられた要望を自動で検知し、内容を分析してOffice365の提案書テンプレートに反映

- サポート部門:問い合わせ内容をAIが理解し、社内ナレッジベースから最適な回答を自動生成

メリット3:LLM・ツール切り替えの自由度が高い

ある時点ではAnthropic社のLLMを使用していたとしても、将来的に別のLLMへ切り替える必要が生じるかもしれません。その際、MCPを導入していれば、接続部分の再実装は不要で、エージェント側を変更するだけでスムーズに移行できます。

一方で、特定ベンダーのAPIに依存したプラグイン方式の場合、接続先の再構築が必要になり、切り替えが困難になります。MCPはこの点において高い柔軟性と将来性を備えています。

メリット4:オンプレミスとクラウド、両方に対応できる柔軟性

企業の中には、機密情報を社内ネットワーク(オンプレミス)で厳格に管理したいケースもあります。MCPでは、自社環境でMCPサーバーを稼働させることで、データを外部に出さずにAI活用が可能になります。

また、クラウド環境との接続も、プロトコルレベルでアクセス制御や認証が整備されているため、セキュリティポリシーに沿った設計が容易です。

オンプレとクラウドにまたがる運用でも、AIエージェントからは共通の手順でアクセスでき、企業の運用方針に合わせて柔軟な構成が可能となります。

Step式で理解する:MCP導入の手順と実装例

Step 1:目的と連携ツールの整理

- まずはユースケースを明確にする

- 例:Slackと社内ファイルサーバーを連携したい

- 例:GitHubからコードを読み込んでレビューさせたい

- 例:社内DBにクエリをかけて結果を取得したい

Step 2:既存のMCPサーバーを調査

- オープンソースのMCPサーバーを探す

- GitHubやAnthropicが公開しているものをチェック

- 例:Filesystem用、PostgreSQL用、GitHub用、Slack用 など

Step 3:MCPサーバーの導入とテスト

- 最初はローカルでシンプルに

- DockerでMCPサーバーを起動

- 同じマシン上にAIエージェントを配置してテスト

- 例:Slack連携 → ローカルで通知確認

- 次にクラウド環境へ展開

- 社内ネットワークやクラウド上で実運用テスト

- 複数のMCPサーバーを組み合わせて利用可

Step 4:AIエージェントとの接続設定

- AIエージェント(例:Claude、Semantic Kernelなど)にMCPサーバーのエンドポイントを登録

- 例:「このリポジトリのファイル一覧を取得してコードレビューをして」などの指示を送信

Step 5:カスタムMCPサーバーの開発(必要に応じて)

- OSSで対応できない場合は自社で実装

- Python/TypeScript/C#向けSDKが用意されている

- Python + FastAPI + uvicorn でAPIを構築するのが一般的

Step 6:セキュリティと運用ポリシーの設計

- トークン認証、VPN、アクセス制御を組み合わせて安全設計

- 権限管理・監査ログの記録も重要

- 特に機密データを扱う業種(金融・公共など)では必須

AIとデータを結びつけるための新たな共通規格MCP:まとめ

総じて、MCPは「AIとデータを結びつけるための新たな共通規格」としての地位を確立しつつあります。オープンソースによるエコシステム拡大が続いており、導入ハードルも着実に下がっています。

AIエージェントを本格的に活用したい開発者や企業にとって、MCPはこれからますます無視できない存在となるでしょう。業界標準となる可能性を秘めたこのプロトコルを理解し、いち早く導入しやすいユースケースから試してみることが、これからのエージェント時代をリードする大きな一歩になるはずです。