Llama APIが20倍速で描く生成AIの未来図

生成AIの実装でいちばんのボトルネックは「待ち時間」だと感じたことはありませんか? メタがCerebras Systemsと組んで公開したLlama APIは、その常識を根底から覆します。GPU ベースで約100トークン/秒が当たり前だった推論速度を、一気に 2,600トークン/秒まで引き上げ、しかも“開発者がクリック2回で使える”という手軽さ。この記事では、APIの技術的ブレークスルーとメタの事業転換、そのインパクトを詳しく解説し、「なぜ速度こそが次世代AIの本質なのか」を読み解きます。

この記事の内容は上記のGPTマスター放送室でわかりやすく音声で解説しています。

過熱する推論API市場にメタが本格参入

メタは開発者向けイベント「LlamaCon」で、オープンソースとして人気を博してきたLlamaシリーズをついに自社クラウドで提供する Llama API を発表しました。Cerebras製ハードウェアを採用することで、従来のGPUサービス比で最大18倍という推論スループットを実現し、OpenAI・Anthropic・Googleが先行して築いた「トークン販売ビジネス」へ本格参入します。これにより、数十億単位でトークンを購入してきた企業開発者の選択肢が一気に拡大することになります。

ウェハスケールエンジンが生む桁違いの速度

鍵を握るのは、Cerebrasが独自設計した“ウェハスケール・エンジン”です。最新ベンチマークによれば、Llama 4 Scoutモデルは 2,648トークン/秒 を記録し、SambaNova(747)、Groq(600)、一般的GPUベース(100前後)を大きく引き離しました。ChatGPTが約130トークン/秒、DeepSeekが約25トークン/秒にとどまる現状では、複雑な多段推論や長文生成をリアルタイム近い感覚で扱えるのはLlama APIだけと言っても過言ではありません。

高速化が解き放つ新しいユースケース

速度が20倍になれば、単純に応答が速くなるだけではありません。複数モデルを連鎖させて実行するエージェント系ワークフロー、対話型の低遅延音声アシスタント、1クリックでのインタラクティブなコード生成、さらにはリアルタイム意思決定を伴うロボティクス制御など、これまで「遅すぎて現実的でない」とされた応用領域が一気に実用段階へ入ります。開発者は“何を作るか”ではなく“どこまで高速に動かせるか”を議論するフェーズに突入したのです。

“オープン”から“ビジネス”へ―メタの収益化戦略

Llama APIは、まず Llama 3.3 8B のファインチューニング機能から提供を開始し、モデルを別クラウドへエクスポート可能という“開かれた”方針を維持します。同時に「顧客データを自社モデル学習に使わない」ことを明言し、閉鎖的な競合との違いをアピール。これにより、オープンソースで築いた巨大コミュニティをスムーズに有料サービスへ誘導し、広告以外の新たな収益柱を確立する狙いが透けて見えます。

北米5拠点で稼働するインフラの舞台裏

推論を支えるCerebrasのデータセンターは、ダラス、オクラホマ、ミネソタ、モントリオール、カリフォルニアの 北米5拠点 に設置され、メタ向けに計算ブロックを確保した“ハイパースケーラーモデル”で運用されます。負荷は全拠点に分散され、開発者がAPIフラグを切り替えるだけで巨大なウェハスケール・エンジンを利用できる仕組みです。この大胆なアウトソースにより、メタ自身はソフトウェア層に集中しつつ、超高速推論をサービスとして提供する体制を整えました。

覇権争いの行方:GPU依存から専用シリコンの時代へ

今回の提携は、AIインフラ競争の潮目を「GPU一辺倒」から「用途特化型シリコン」へと明確に動かしました。NVIDIAは依然として学習領域で圧倒的ですが、推論という“量産フェーズ”では CerebrasやGroq のような専用チップが優位を示し始めています。メタが複数の専用プロバイダーを並列採用したことは、今後のAIクラウド市場が“マルチシリコン戦略”に移行するシグナルと受け取るべきでしょう。

まとめ:スピードは機能ではなく本質

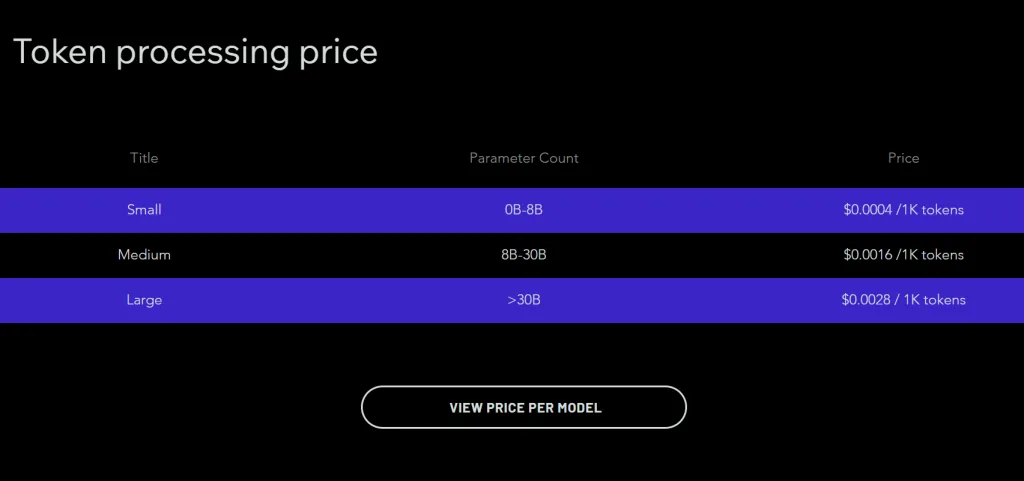

メタが掲げた「モデルが何を知っているかではなく、どれだけ速く考えられるか」というメッセージは、生成AIの次の競争軸を端的に示しています。2,600トークン/秒という数値は単なる性能指標ではなく、開発者が“構想を即時に形にできる”世界への扉です。今後はAPIの一般公開に合わせて価格体系や対応モデルが拡充される見通しで、エンタープライズからスタートアップまで、AIプロダクト開発のロードマップを再設計する必要が出てくるでしょう。速度こそがユーザー体験を決定づける時代、その最前線をLlama APIが切り拓いています。