国産vs海外:日本で利用可能なGPUクラウドサービス最新動向

生成AIやディープラーニングが急速に普及する中、多くの企業が自社のAIプロジェクトに取り組もうとしています。しかし、高性能なAIモデルの開発・運用には強力なGPUリソースが必要であり、その初期投資額は決して小さくありません。「自社でGPUサーバーを構築すべきか、クラウドサービスを利用すべきか」—この悩みを抱える企業担当者は多いのではないでしょうか。

実は、日本国内にも世界レベルのGPUクラウドサービスが続々と登場しており、初期投資ゼロで最新のGPUパワーを活用できる環境が整ってきています。さらに意外なことに、日本発のGPUクラウドサービスが世界的な性能ランキングで上位に食い込むなど、国内サービスの競争力も高まっています。

本記事では、日本で利用可能な主要GPUクラウドサービスを徹底比較し、AIプロジェクトを成功に導くための最適な選択肢を探ります。コスト削減、開発スピードの向上、柔軟なリソース管理を実現したい方は、ぜひ最後までお読みください。

日本のAI開発を加速させるGPUクラウドサービス6選

1. Amazon Web Services (AWS)

概要:

クラウドサービスの王者AWSは、日本においても東京リージョンを中心に充実したGPUインスタンスを提供しています。G2、G4、G5などのインスタンスタイプがあり、特に最新のG5インスタンスではNVIDIA A10G Tensor Core GPUを搭載し、AI/ML処理からグラフィックス集約型アプリケーションまで幅広く対応しています。

主なGPUタイプ: NVIDIA A10G、T4など

日本のデータセンター: 東京リージョン

AWSのGPUクラウドの特徴

- 豊富なインスタンスタイプと柔軟な課金体系

- 包括的なAI/MLサービスエコシステムとの連携

- 充実したドキュメントと日本語サポート

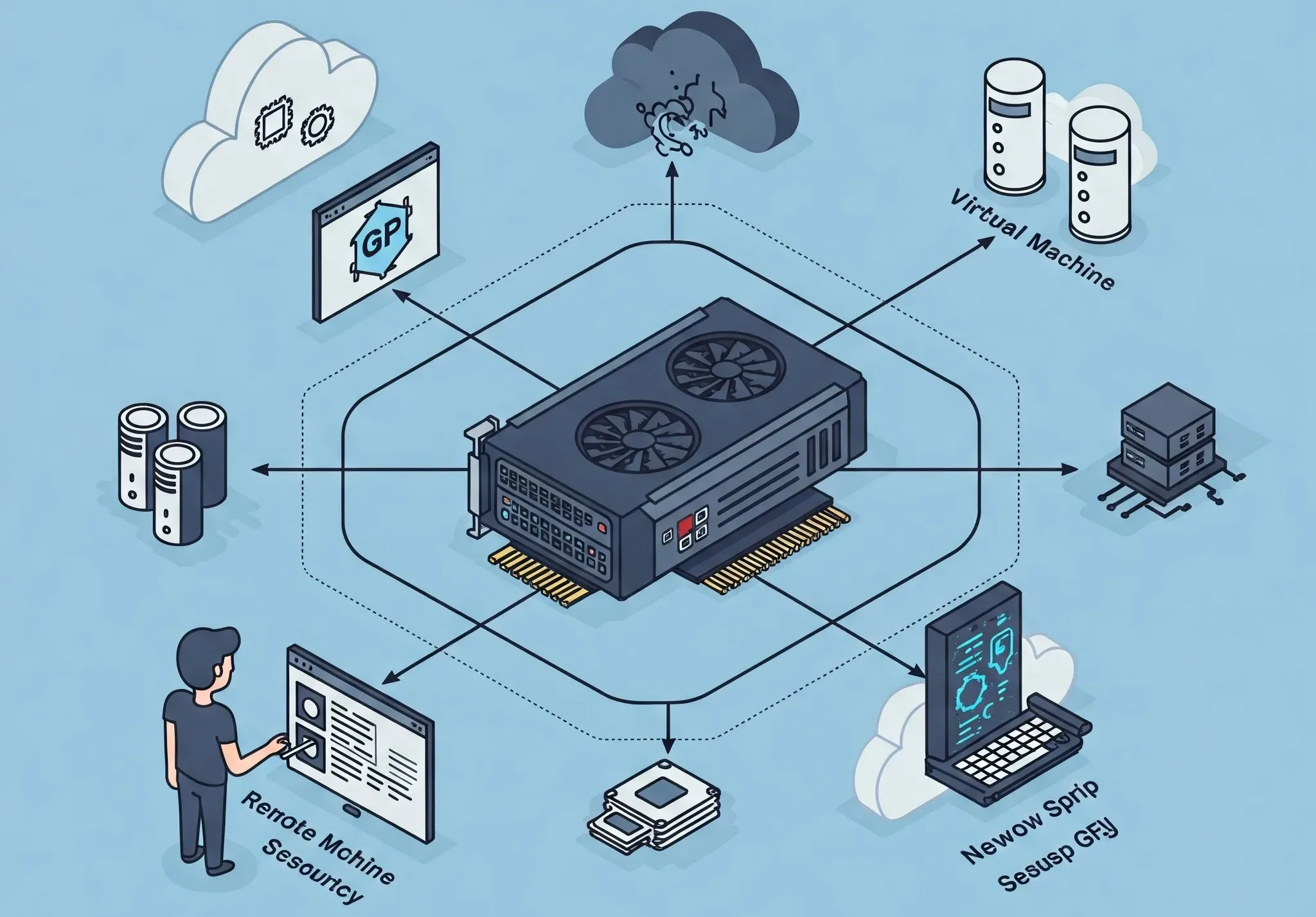

- Elastic GPUサービスによる柔軟なリソース割り当て

向いている用途

- 様々な規模のAI/ML開発プロジェクト

- スケーラブルなAIサービスの本番運用

- グラフィックス処理や3Dレンダリング

2. Google Cloud Platform (GCP)

概要:

Googleの強みであるAI技術を背景に、GCPは東京と大阪の両リージョンで高性能GPUを提供しています。特筆すべきは最新のNVIDIA H100、A100、L4、T4などの豊富なラインナップと、生成AI向けの最適化されたサービス群です。2023年3月には、さらに高性能なNVIDIA H200 GPUも導入されました。

主なGPUタイプ: NVIDIA H100、A100、L4、T4

日本のデータセンター: 東京、大阪

GCPのGPUクラウドの特徴:

- TPU(Tensor Processing Unit)も選択可能

- AutoMLなど独自のAI開発支援ツールが充実

- Vertex AIプラットフォームによる統合的な開発環境

- 大規模データ処理との連携が容易

向いている用途:

- 大規模なディープラーニングモデルのトレーニング

- 最新のジェネレーティブAI開発

- Google製AIサービスとの連携を活かしたプロジェクト

3. Microsoft Azure

概要:

Microsoftの包括的なクラウドサービスであるAzureは、日本東(埼玉)と日本西(大阪)リージョンでGPUインスタンスを提供しています。NVIDIA A100やH100をサポートし、AIインフラストラクチャやHPC(高性能コンピューティング)に強みを持っています。2024年時点で、日本市場におけるAIチップ投資も積極的に拡大しています。

主なGPUタイプ: NVIDIA A100、H100

日本のデータセンター: 埼玉、大阪

Microsoft AzureのGPUクラウドの特徴:

- Azure OpenAIサービスとの連携が容易

- エンタープライズ向けのセキュリティと管理機能

- Microsoft製品エコシステムとの統合

- ハイブリッドクラウド環境の構築がしやすい

向いている用途:

- エンタープライズAIソリューションの開発

- Microsoft製品と連携したAI機能の実装

- セキュリティ要件の厳しい業界向けのAI開発

4. GMO GPU Cloud

概要:

日本発のGPUクラウドサービスとして注目を集めるGMO GPU Cloudは、NVIDIA H200 Tensor Core GPUを8枚搭載した高性能クラスタを提供しています。2024年11月のNVIDIAニュースでは、国内最速レベルの商用クラウドサービスとして位置付けられ、TOP500(スーパーコンピュータ性能ランキング)で世界37位を記録するなど、その性能は国際的にも評価されています。

主なGPUタイプ: NVIDIA H200、Tesla V100

日本のデータセンター: 国内複数拠点

GMO GPUクラウドの特徴:

- 国内最速レベルの計算性能

- 日本語による手厚いサポート体制

- 国内データセンターによる低レイテンシー

- AI開発に特化したチューニング

向いている用途:

- 国内企業の大規模生成AIプロジェクト

- 低レイテンシーが求められるAIサービス

- 日本語サポートを重視するAI開発チーム

5. Alibaba Cloud

概要:

中国発のグローバルクラウドプロバイダーであるAlibaba Cloudも日本にデータセンターを持ち、Elastic GPU Serviceを通じてNVIDIA Tesla P100、V100などのインスタンスを提供しています。アジア市場を重視する企業や、中国市場との連携を視野に入れたAI開発に適したサービスとなっています。

主なGPUタイプ: NVIDIA Tesla P100、V100

日本のデータセンター: 東京

AlibabaのGPUクラウドの特徴:

- アジア圏での豊富なデータセンター展開

- コスト競争力の高い料金体系

- 中国市場向けAIサービスとの親和性

- PAI(Platform for AI)による統合環境

向いている用途:

- アジア市場向けAIサービスの開発

- コスト効率を重視するAIプロジェクト

- 中国市場も視野に入れたグローバルAI展開

6. Linode

概要:

Akamaiの一部となったLinodeは、東京に2つのデータセンターを持ち、NVIDIA RTX 4000 AdaやQuadro RTX 6000を搭載したGPUインスタンスを提供しています。シンプルな料金体系と使いやすさで知られ、中小企業やスタートアップ向けにコスト効率の良いGPUリソースとして評価されています。

主なGPUタイプ: NVIDIA RTX 4000 Ada、Quadro RTX 6000

日本のデータセンター: 東京(2拠点)

LinodeのGPUクラウドの特徴:

- シンプルで透明性の高い料金体系

- 使いやすい管理コンソール

- スタートアップフレンドリーなサポート

- SSDストレージと高速ネットワーク

向いている用途:

- スタートアップのAI実験・プロトタイピング

- 中小規模の機械学習プロジェクト

- グラフィックス処理やゲーム開発

GPUクラウドサービス選択の重要ポイント

1. コストパフォーマンス

GPUクラウドサービスを選ぶ際、最も重要な検討ポイントの一つがコストパフォーマンスです。各サービスには様々な課金モデルがあり、従量課金、リザーブドインスタンス、スポットインスタンスなど、プロジェクトの性質に合わせた選択が可能です。

例えば、AWS、GCP、Azureなどの大手プロバイダーは様々な割引オプションを提供していますが、基本料金はやや高めです。一方、GMO GPU Cloudは日本国内向けに最適化された料金体系を持ち、Linodeはシンプルで予測しやすい料金設定で中小規模のプロジェクトに適しています。

重要なのは、単純なGPU時間あたりの料金だけでなく、ストレージコスト、データ転送料金、管理オーバーヘッドなども含めた総所有コスト(TCO)で比較することです。

2. GPUタイプと性能

AI開発プロジェクトの要件に合ったGPUタイプを選ぶことも重要です。最新のNVIDIA H100やA100は最高レベルの性能を提供しますが、すべてのユースケースでそのような高性能GPUが必要とは限りません。

多くの推論ワークロードではT4やRTXシリーズで十分であり、コスト削減にもつながります。ディープラーニングのトレーニングでは、メモリ容量とバンド幅が重要な選択基準となります。

各サービスが提供するGPUの世代や数量、メモリ容量、相互接続(NVLink対応など)を確認し、プロジェクトの要件に合ったインスタンスを選択しましょう。

3. レイテンシーとデータロケーション

日本国内でのAIサービス運用を前提とする場合、レイテンシー(応答遅延)の観点から国内データセンターの利用が推奨されます。特にリアルタイム推論やインタラクティブなAIサービスでは、低レイテンシーが重要な要素となります。

また、データ主権や規制遵守の観点からも、データの保存場所は重要な検討事項です。金融や医療などの規制の厳しい業界では、データロケーションに関する制約が課せられることがあります。

本記事で紹介した6つのサービスはすべて日本国内にデータセンターを持ちますが、サービス間でリージョンの数や場所、ネットワーク性能に違いがあるため、具体的な利用シナリオに合わせて選択することが重要です。

4. エコシステムと統合性

GPUリソースだけでなく、周辺サービスとの統合性も重要な選択基準です。例えば、AWSはSageMaker、GCPはVertex AI、AzureはAzure Machine Learningなど、包括的なAI開発環境を提供しています。

これらのマネージドサービスを活用することで、インフラ管理の負担を軽減し、開発者はモデル開発に集中できるというメリットがあります。一方、より柔軟なカスタマイズが必要な場合は、Linodeなどの汎用クラウドサービスが適している場合もあります。

既存のクラウド環境との親和性や、利用中の開発ツールとの統合のしやすさも考慮すべき重要な要素です。

業界別・ユースケース別推奨サービス

大企業のエンタープライズAI開発

大規模な組織でセキュリティや管理機能を重視する場合は、AWS、Azure、GCPなどの大手グローバルプロバイダーが適しています。特に既存のMicrosoft製品エコシステムを使用している企業はAzureとの親和性が高く、Google WorkspaceとGCP、AWS環境を持つ企業はそれぞれの既存環境との統合性を活かせます。

また、日本企業が手掛けるGMO GPU Cloudは、国内企業のニーズに特化したサービスとサポートを提供しており、日本語環境での開発・運用を重視する企業にとって魅力的な選択肢となっています。

AIスタートアップ・研究開発

コスト効率と柔軟性を重視するスタートアップや研究プロジェクトでは、LinodeやAlibaba Cloudなど、比較的低コストで始められるサービスが適しています。また、スポットインスタンスを効果的に活用できるAWSやGCPも、コスト最適化を図りつつ高性能GPUにアクセスする方法として検討する価値があります。

短期間の実験や検証には、時間単位の課金モデルを持つサービスが費用対効果に優れています。GMO GPU Cloudも国内スタートアップ向けに特別プログラムを提供しており、日本発のAIスタートアップを支援する取り組みを行っています。

大規模言語モデル(LLM)の開発・微調整

大規模言語モデル(LLM)のトレーニングや微調整には、NVIDIA H100やA100を搭載した高性能インスタンスが必要です。この点では、GCPやAzure、GMO GPU Cloudが提供する最新GPU搭載インスタンスが適しています。

特にGMO GPU Cloudの国内最速レベルのGPUクラスタは、日本語LLMの開発に取り組む企業にとって強力な選択肢となるでしょう。また、AWSやAzureが提供する分散トレーニング機能も、大規模モデルの効率的な開発に貢献します。

実事例に見るGPUクラウド活用の成功パターン

事例1:金融テック企業の不正検知システム

ある国内金融テック企業は、リアルタイム不正検知システムの開発にAWS G4インスタンスを活用しました。トランザクションデータを分析する深層学習モデルを開発し、SageMakerを用いてモデルのデプロイと運用を自動化。結果として、従来のルールベースシステムと比較して不正検知率が30%向上し、誤検知率は25%低減することに成功しました。クラウドGPUの活用により、自社GPUサーバーの構築・運用コストを削減しつつ、柔軟なスケーリングを実現しています。

事例2:製造業の品質検査AI

大手製造業企業は、生産ラインの視覚検査システムにGCP上のNVIDIA T4 GPUインスタンスを活用し、リアルタイム画像処理による不良品検出システムを構築しました。Vertex AIを活用したモデル開発と運用により、開発期間を従来の半分に短縮。さらに、インスタンスの自動スケーリングにより、生産ピーク時の処理能力を確保しつつ、コスト最適化を実現しました。導入後、検出精度は95%以上に向上し、人的コストの削減にも貢献しています。

事例3:スタートアップの日本語生成AIサービス

日本語に特化した生成AIサービスを開発するスタートアップは、GMO GPU Cloudの高性能GPUクラスタを活用して日本語特化型の大規模言語モデルを開発しました。国内データセンターの低レイテンシーによりユーザー体験を向上させつつ、日本語データセットでの効率的なモデル訓練を実現。結果として、グローバルモデルと比較して日本語処理精度が15%向上し、レスポンス時間も40%短縮されました。国内サービスならではの手厚いサポートも、開発スピード向上に貢献したと報告されています。

まとめ:最適なGPUクラウド選択のための5つのステップ

- プロジェクト要件の明確化

必要なGPU性能、メモリ容量、ストレージ要件、処理するデータ量などを事前に明確にしましょう。 - 予算とコスト分析

総所有コスト(TCO)の観点から各サービスを比較し、長期的なコスト最適化を図りましょう。 - サービスの技術的適合性評価

必要なGPUタイプ、インスタンスサイズ、利用可能なフレームワークやツールとの互換性を確認しましょう。 - セキュリティとコンプライアンス要件の検討

データ保存場所、暗号化、アクセス制御などのセキュリティ機能がプロジェクト要件を満たしているかを確認しましょう。 - 小規模テストの実施

本格導入前に、各サービスの小規模テストを実施し、実際のパフォーマンスやユーザビリティを評価することをお勧めします。

AIプロジェクトの成功は、適切なGPUリソースの選択から始まります。日本国内でも多様なGPUクラウドサービスが利用可能となった今、自社のニーズに最適なサービスを選択し、コスト効率と開発スピードの両立を実現しましょう。