動きがリアル!MetaのVideoJAMが拓く生成AI動画

「AIが生成する動画はまだどこかぎこちない」と感じたことはありませんか?

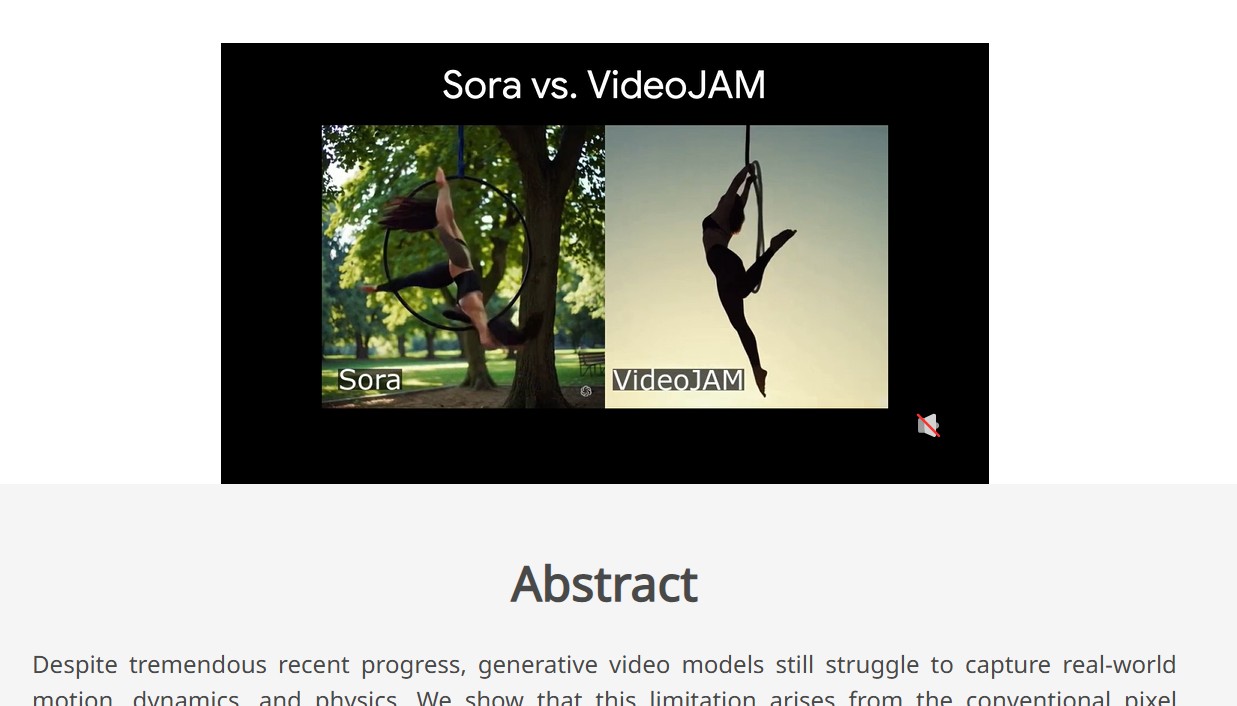

そんな悩みを解決する新技術が、Meta(旧Facebook)の研究チームから登場しました。VideoJAMは、自然でリアルな動きを生み出す動画生成の最新フレームワークです。

本記事では、VideoJAMがいかにして“モーションの不自然さ”を克服するのか、その技術背景や競合モデルとの比較、今後の展望をわかりやすく解説します。これを読めば、映像制作やAI技術の最前線について驚きと納得が得られるはずです。

VideoJAMとは

Meta社のAI研究チームが開発したVideoJAM(ビデオジャム)は、「Joint Appearance-Motion(外観と動きの統合)」をコンセプトとする新しい動画生成フレームワークです。従来の動画生成モデルが苦手としていた“モーションの不自然さ”や“動きの一貫性不足”を劇的に改善し、よりリアルでスムーズな動画を生成できるよう設計されています。

VideoJAMの主な特徴

- モーション一貫性の向上

従来のAI動画生成では、高速運動で手足が増えたり、物体が歪んだりといった不自然な動きがしばしば見られました。VideoJAMはフレーム間のつながりを重視し、滑らかなモーションを実現することで映像のリアリティを大幅に高めます。 - 高い視覚品質と両立

動きがリアルであっても、画質が粗ければ魅力は半減してしまいます。VideoJAMはモーションを重視しつつ、解像感やディテールもしっかり保持する設計となっており、研究段階の指標では既存の最新モデルを上回る結果を示しています。 - 既存モデルへの組み込み容易性

大幅なデータセットの追加やモデルの大規模化を必要とせず、汎用的に他の動画生成モデルに導入しやすいのが強みです。つまり、研究から実用へ移行する際の障壁が比較的低く、幅広い領域で採用が期待できます。 - Inner-Guidance(内側誘導)機構

推論(生成)過程でモデル自身がモーション予測を参照し、生成を逐次的に最適化する「Inner-Guidance」という独自機構を導入。外部から固定的な制約を与えなくても、「今の動きは現実的か?」とモデルが自らチェックするため、フレーム間に整合性のある自然な映像が出力されます。

技術的なポイント:外観と動きの統合表現

VideoJAMの要は「外観(静止画的要素)と動きの情報を同時に学習させる」点にあります。従来の動画生成AIは、フレームごとの見た目再現に重きを置きすぎてモーション情報が軽視されがちでした。

学習(トレーニング)段階

- フレーム画像(ピクセル)と、そのフレーム間のモーション情報(例:光学フロー)を同時にノイズ付き潜在ベクトルとしてエンコード。

- 拡張した拡散モデル(Diffusion Model)の出力側に「ピクセル再構成用」と「モーション予測用」の2つのヘッドを持たせる。

- 1つの内部表現(潜在ベクトル)から「見た目」と「動き」を同時に再現する学習を行い、外観の精密さと動きの一貫性を両立する。

生成(推論)段階

- 学習済みモデルに対し、Inner-Guidanceという内部誘導手法を適用。

- フレームごとにモデルが予測する次の動きを参照し、結果に応じて次のフレームを微調整しながら生成を進める。

- フレーム間でブレの少ない連続的な動きが得られ、外部制約を細かく設定しなくても自然な動画を作り出せる。

市場への影響と競合比較

ここ数年、生成AIを用いた動画制作技術は急速に発展していますが、依然として“動きのリアルさ”が課題でした。いくら外観がきれいでも、手足が増えたり物体が瞬間的に消えたりすると没入感は損なわれます。VideoJAMは、この「モーション不自然問題」を正面から解決しようとする点で大きな注目を集めています。

- エンターテインメントや広告分野:

- AIが作る短編映像やアニメーションの品質向上に役立つと期待され、プロの映像制作者が取り入れやすくなる。

- バーチャルプロダクションやゲーム・VR:

- リアルな物理挙動が求められるコンテンツ制作において、AI生成が活躍する領域が広がる。

- 競合との比較:

- Googleの「Veo 2」やRunway社の「Gen-2」、OpenAIがうわさされる動画生成プロジェクトなどと比較しても、VideoJAMはフレーム間モーションの安定性・リアリティで優位性を示すと報告されています。

今後の展望

- リリース時期と研究公開:

- 2025年2月上旬に研究論文(プレプリント)とデモ映像が公開されたばかりで、一般向けサービスとして提供される予定は未定。Metaの過去の事例から考えると、数か月から1年ほどのうちにデモサイトや開発者向けAPIなどで試用が可能になる可能性があります。

- 拡張の方向性:

- 音声生成との統合や、長尺動画・インタラクティブ動画への応用、さらに複雑な物理法則や環境シミュレーションへの発展も視野に入っているとのことです。

- Metaのプラットフォームへの組み込み:

- InstagramやFacebook、VRプラットフォームなどでの活用シナリオもあり、世界的にVideoJAMを触れる日が来るかもしれません。

まとめ

VideoJAMは、AI動画生成における大きな課題だった“モーションの不自然さ”を解消する新技術として、2025年に登場しました。外観と動きを統合的に学習し、モデル自身が動きの妥当性を逐次チェックするInner-Guidanceで、自然かつ高品質な動画生成を実現します。

まだ研究段階で一般ユーザーが直接試せる状況ではありませんが、今後の展開次第では、映像制作やエンタメ産業のみならず、私たちの日常コンテンツ体験にも大きな変化をもたらす可能性があります。