大規模言語モデル(LLM)をクラウドではなく自分のパソコンで動かしたいと考えたことはありませんか?プライバシーを守りながら、インターネット接続なしでAIの力を活用できる方法があります。

LM Studioは、ローカル環境でLLMを直感的に操作できるオープンソースソフトウェアです。本記事では、高性能な日本語対応モデル「DeepSeek R1」をLM Studioで構築・実行する方法を詳しく解説します。ここでの内容を実行すれば、プログラミング知識などがなくても、数ステップで最先端のAIを自分のパソコンで動かせるようになります。

LM StudioでローカルLLMを構築

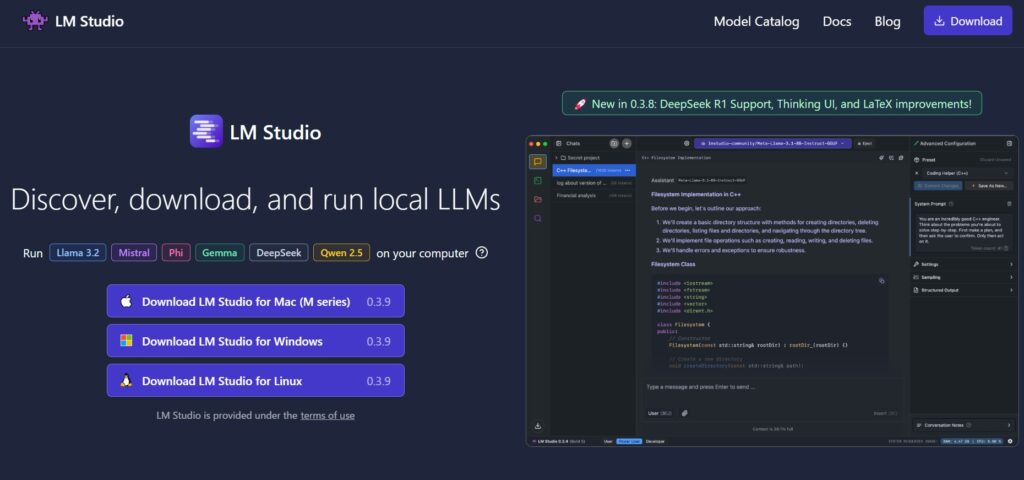

LM Studioは、ローカル環境で大規模言語モデル(LLM)を簡単に探索、ダウンロード、実行できるオープンソースのソフトウェアです。LM Studioには以下のような特徴があり、個人ユーザーからプロフェッショナルまで幅広く活用されています。

- 直感的な操作性:グラフィカルユーザーインターフェース(GUI)により、コマンドラインやプログラミングの知識がなくても簡単に操作できます。

- 完全オフライン対応:インターネット接続なしで動作するため、機密情報を扱う場面でも安心して利用できます。

- プライバシー保護:データがローカル環境内で処理されるため、クラウドサービスのような情報漏洩リスクがありません。

- 多様なモデル対応:Hugging Faceなど様々なソースから提供されるオープンソースモデルを幅広くサポートしています。

- 日本語モデル対応:DeepSeek R1を含む高性能な日本語対応モデルを利用できるため、日本語での自然な対話が可能です。

DeepSeek R1をローカル環境で構築する手順

①LM Studioのインストール

- LM Studio公式サイトにアクセスします。

- お使いのオペレーティングシステム(Windows、macOS、Linux)に対応したインストーラーをダウンロードします。

- ダウンロードしたインストーラーを実行し、画面の指示に従ってインストールを完了させます。

ヒント:インストール時に「不明な開発元」という警告が表示される場合がありますが、公式サイトからダウンロードした場合は安全に進めることができます。

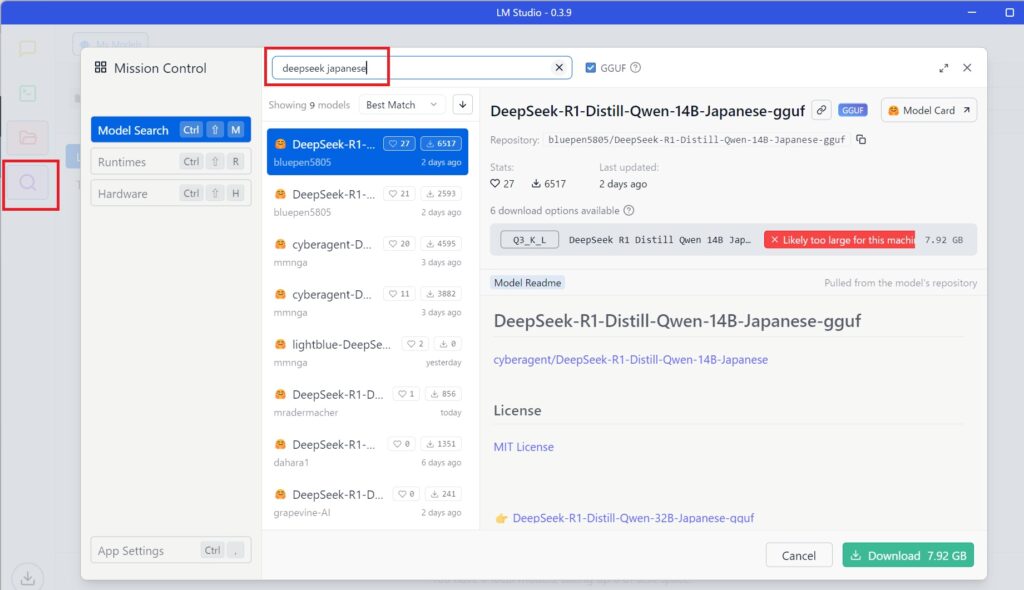

②DeepSeek R1モデルのダウンロード

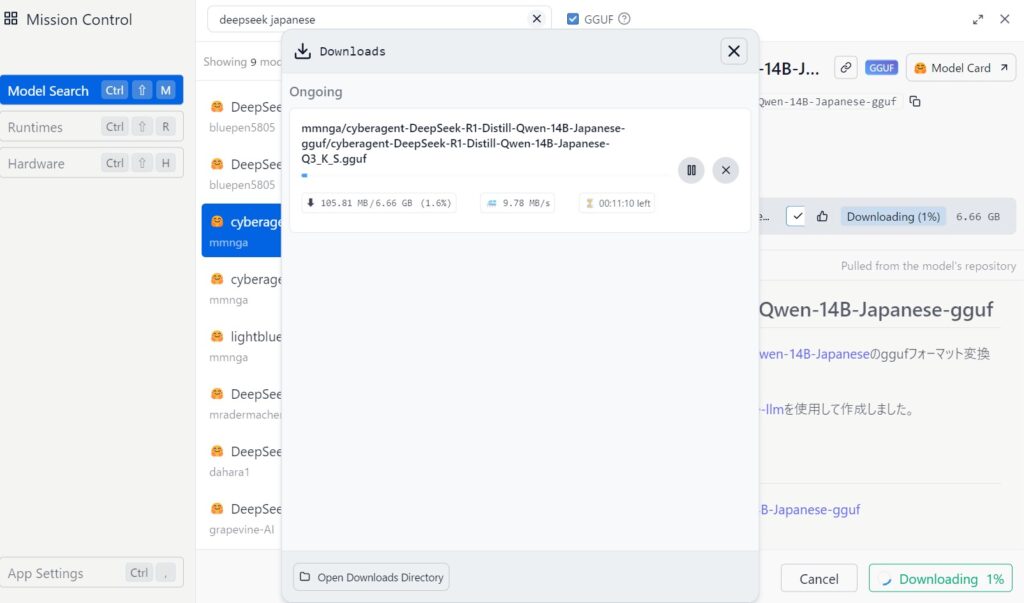

- LM Studioを起動し、左側のナビゲーションから「探索」アイコン(虫眼鏡マーク)をクリックします。

- 検索バーに「DeepSeek R1 Japanese」と入力し、検索を実行します。

- 検索結果から「cyberagent-DeepSeek-R1-Distill-Qwen-14B-Japanese-gguf」モデルを見つけて選択します。

(注意:このモデルは約6.6GBのサイズがあるため、十分なストレージ容量があることを確認してください) - モデル詳細画面で「Download」ボタンをクリックし、ダウンロードを開始します。ダウンロード進捗はステータスバーで確認できます。

選択のポイント:日本語に特化した「Japanese」モデルを選ぶことで、より自然な日本語での対話が可能になります。

GGUFとは?

DeepSeek R1は「GGUF」形式で提供されています。GGUFとは「GPT生成統合フォーマット」の略で、LLMをローカル環境で効率的に実行するために最適化されたファイル形式です。従来のGGML形式の後継として開発され、より少ないメモリ消費でモデルを動作させることができます。

③モデルのロード

ダウンロードが完了したら、左側の「チャット」アイコン(吹き出しのマーク)をクリックします。画面上部の「Select a model to load」から、先ほどダウンロードしたDeepSeek R1モデルを選択します。モデルがロードされると、チャットインターフェースが利用可能になります。

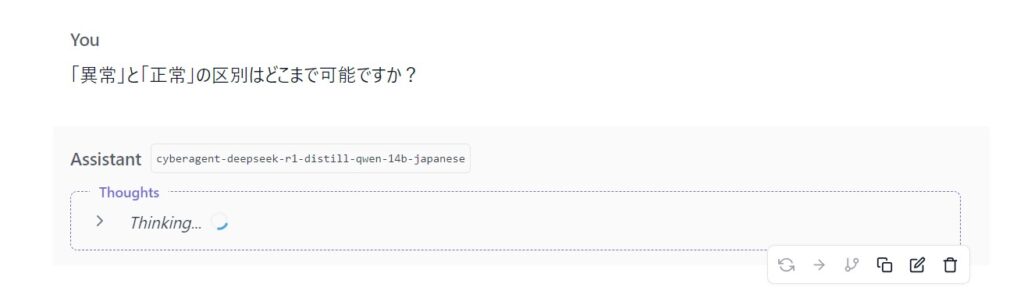

④モデルの実行

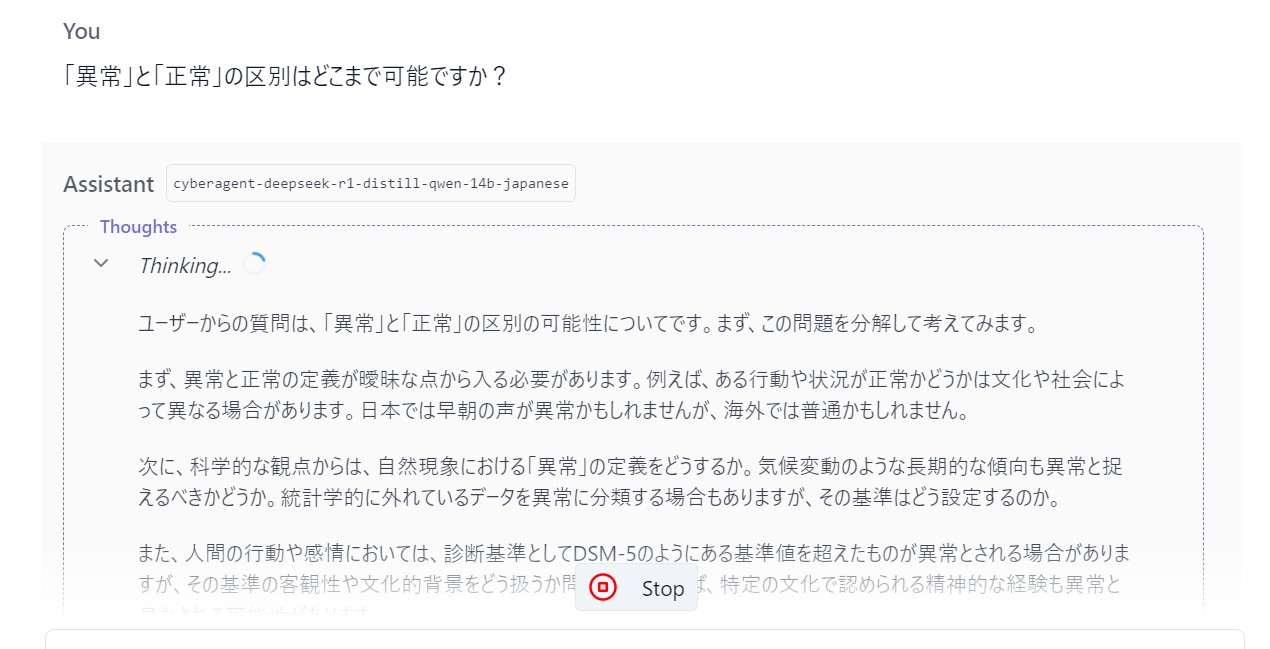

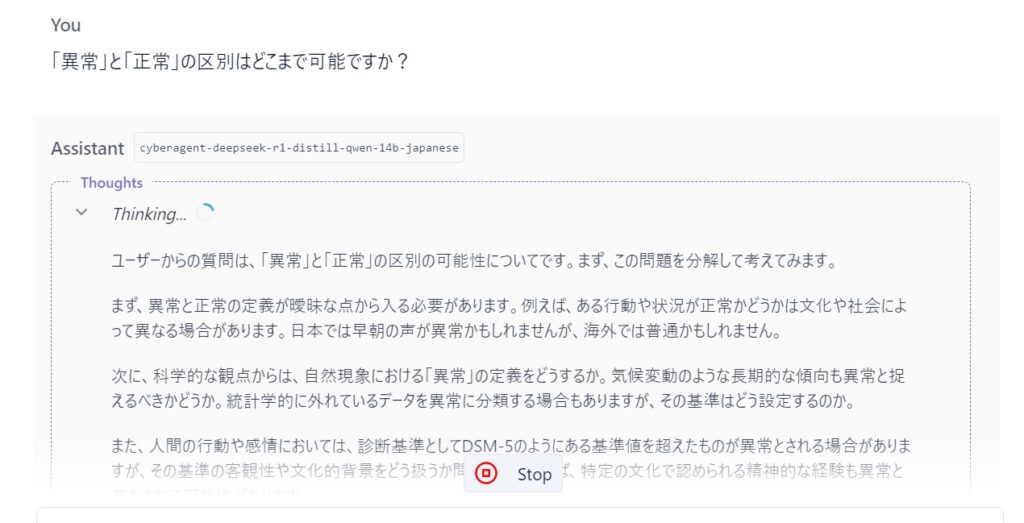

チャット画面の下部にある入力フォームに質問や指示を入力し、エンターキーを押すと、モデルからの応答が表示されます。日本語での質問にも対応しており、さまざまなトピックについて会話が可能です。質問を入れると、しばらく考えてから答えてくれます。

以下のように、思考過程は日本語で表示されています。

以上の手順で、LM Studioを使用してローカル環境でDeepSeek R1を構築し、利用することができます。

この方法により、インターネット接続がない環境でもAIモデルを活用でき、データのプライバシーを保護しながら自然言語処理を行うことが可能です。

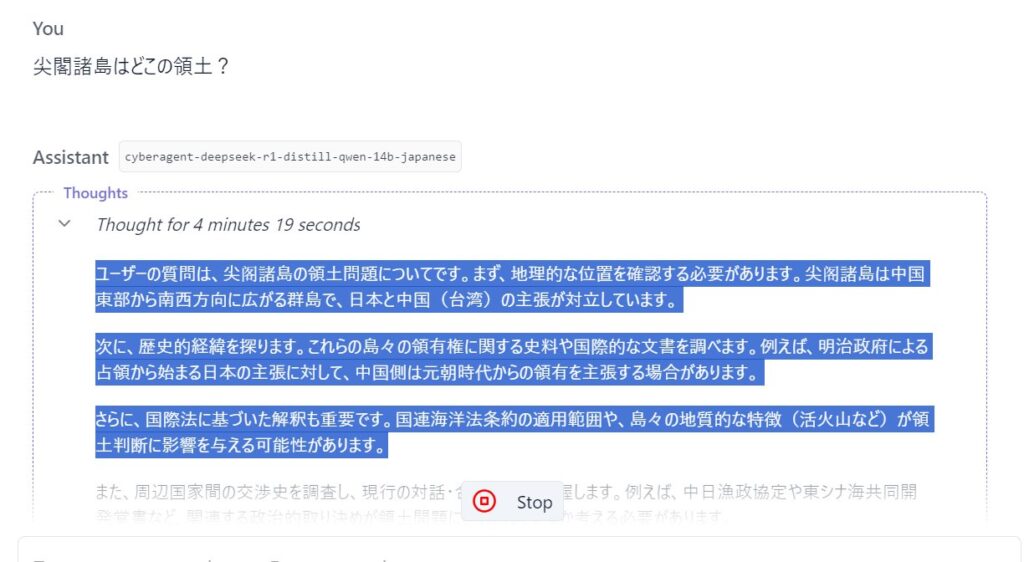

DeepSeekの政治的なバイアスについて

政治的な意見がわかれる質問をしてみたところ、Web版のDeepSeekとは違って、日本語で追加学習されたモデルは多面的に質問を分析して考えてくれます。

(思考時間が長いのはGPUを積んでいないノートPCでローカルLLMを動かしているからです)

サーバーとしての機能もある

さらに、LM Studioは言語モデルをサーバーとして利用する機能も備えており、他のアプリケーションからAPI経由でアクセスすることも可能です。

LM StudioでDeepSeekをローカル環境で動かす:まとめ

この記事では、LM Studioのインストール方法からDeepSeek R1モデルのダウンロード・ロード手順までを解説し、チャット形式での利用方法を紹介しました。

LM Studioを使用してDeepSeekをローカル環境で動かす際には、是非参考にしてください。

参考)公式サイト(lmstudio.ai)