「AIが長文を理解できない」「大量のデータを一度に処理できない」—こうした大規模言語モデル(LLM)のの課題に革命的な解決策をもたらす新モデルが登場しました。

中国のAIスタートアップMiniMaxが発表した「MiniMax-M1」は、100万トークンという驚異的な文脈理解能力を持ち、しかも完全オープンソースで公開されたのです。AI業界に激震を与えるこの技術革新は、私たちのAI活用の可能性をどこまで広げるのでしょうか。

この記事の内容は上記のGPTマスター放送室でわかりやすく音声で解説しています。

MiniMax-M1:100万トークンがもたらす文脈理解の革命

AIの性能を評価する重要指標として、近年特に注目されているのが「コンテキストウィンドウ」の大きさです。これは、AIが一度に処理できる情報量を示す「トークン数」で表されます。

トークンとは何でしょうか? 簡単に言えば、AIがテキストを理解・処理する際の最小単位です。日本語では大体1文字が1トークン、英語では単語の一部や短い単語が1トークンに相当します。たとえば、「こんにちは」は5トークン、”Hello”は1トークンとして扱われることが多いのです。従来の主流モデルと比較すると、その差は歴然としています。

- OpenAIのGPT-4o:最大12万8,000トークン

- GoogleのGemini 2.5 Pro:最大100万トークン

- MiniMax-M1:100万トークン(オープンソースモデルとしては初)

100万トークンになるとどのくらい性能が変わるのか

この100万トークンという数字が意味するものは、小説一冊分(約10万トークン)どころか、シリーズ全巻や複数の専門書を一度にAIが理解できるということです。

- 膨大な法律文書や契約書の全体を一度に分析

- 学術論文の全文を踏まえた詳細な要約と考察

- 長期間の会話履歴を記憶した一貫性のある対話

- 複数の情報源を横断した総合的な分析

トークン数が100万になることで上記のような革新的な応用が可能になります。

オープンソースモデルの本当の価値

もう1つのMiniMax-M1の画期的な特徴は、「Apache 2.0ライセンス」による完全オープンソース化です。これまで最先端AIモデルの多くは、API経由の限定的な利用しか許可されず、内部構造は「ブラックボックス」のままでした。対照的に、MiniMax-M1はHugging FaceとGitHubで全コードが公開され、企業や開発者は以下のことが可能になりました。

- ライセンス料なしでの商用利用

- モデルの内部構造の分析と理解

- 特定業界や言語向けのカスタマイズ

- 自社製品への完全統合

この透明性により、世界中の技術者コミュニティが改良や検証に参加でき、AIの発展を加速させる協働環境が生まれています。

低コスト化を実現した二つの革新技術

MiniMax-M1の驚異的な低コスト開発を可能にした技術的ブレイクスルーは、主に二つあります。

1. CISPO:効率的な強化学習の新手法

MiniMaxが独自開発した「CISPO(Clipped Importance Sampling Policy Optimization)」は、AIの学習効率を根本から変革しました。従来の強化学習では、すべてのデータに対して同じ重みで学習を行うため、無駄な計算リソースが発生していました。

CISPOでは、学習過程で特に重要なデータポイントを識別し、その「重要度」に基づいて学習の優先順位をつけます。さらに、極端に高い重要度を持つデータの影響を適切に制限(クリッピング)することで、学習の安定性も確保しています。

この「選択と集中」のアプローチにより、学習効率を最大25%向上させながら、計算リソースの無駄を大幅に削減することに成功しました。

2. MOE構造:「専門家の集合体」としてのAI

もう一つの革新が「Mixture-of-Experts(専門家の混合)」と呼ばれる構造です。従来のAIモデルがすべての質問に対して同じニューラルネットワーク全体を使用するのに対し、MoE構造では複数の「専門家」(サブネットワーク)を内部に持ち、入力内容に応じて最適な専門家だけを活性化させます。

例えるなら、一人の万能な教授がすべての質問に答えるのではなく、数学、歴史、科学など各分野の専門家チームから、質問に応じて最適な専門家だけが回答する以下のような仕組みです。

- 総パラメータ数:4560億(従来モデルの数倍)

- 実際に活性化されるパラメータ:約45.9億(全体の約1%)

この「必要な部分だけを使う」設計により、巨大な知識ベースを持ちながらも、実行時の計算負荷と消費電力を劇的に削減することに成功しています。

アーキテクチャの進化とバリエーション

MiniMax-M1は、同社の従来モデル「MiniMax-Text-01」を基盤に設計されており、その規模は4560億パラメータ(うち1トークンごとに活性化されるのは45.9億)と、トップクラスの巨大モデルとなっています。

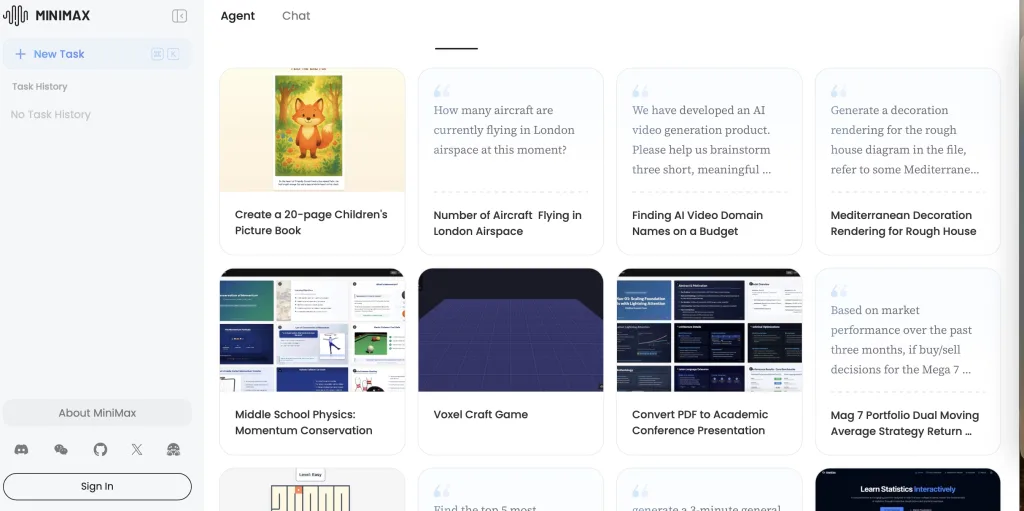

注目すべきは、アウトプット長の異なる2つのバリエーション、「MiniMax-M1-40k」「MiniMax-M1-80k」が用意されている点です。これは、用途やコストに応じて「思考予算=出力トークン長」を選択できる柔軟性を持たせた設計です。

また、ハイブリッド型のMoE構造によって、計算負荷を抑えつつも大量のパラメータを活用できる点が特徴的です。これは、複雑なタスクや長文処理でも性能を維持しつつ、計算コストを抑制する理想的なバランスを目指したものです。今後、さらに用途別や軽量版の派生モデルが追加されることで、あらゆる規模・業界のニーズに対応できるプラットフォームへと成長することが期待されています。

ベンチマーク試験と実用性の検証

MiniMax-M1は、リリース直後からさまざまな標準ベンチマーク試験で高い評価を得ています。とくに、複雑な推論(Reasoning)、ソフトウェアエンジニアリング、ツールの利用能力など、実務レベルでのAI活用に直結する指標で優れたパフォーマンスを示しています。具体的な試験結果では、既存の大手モデルと比較しても遜色ない、あるいはそれ以上の成績が報告されています。

MiniMax-M1の登場:まとめ

AIの進化は、常に「どこまで賢くできるか」「どこまで人間の役に立つか」というチャレンジの連続です。MiniMax-M1の登場は、技術的ブレイクスルーとともに、AIをより多くの人が自分のものとして活用できる「民主化」の時代を切り開くものです。

今後は企業だけでなく、自治体や教育分野、スタートアップなど、多様なプレイヤーがAIの恩恵を手にすることで、日本発の新しい価値創造や社会課題の解決にもつながっていくでしょう。AI活用の次なる一手を模索する皆さんにとって、MiniMax-M1は必見の選択肢となるはずです。