革命到来:Mac Mini×Exo Labsで実現する低コスト高性能LLM環境

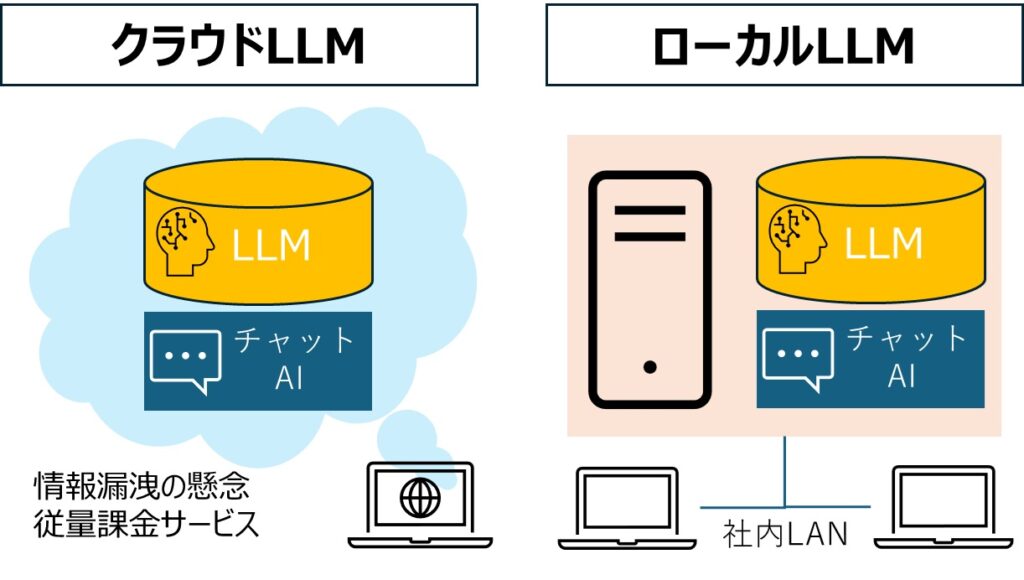

生成AIを本格導入したいものの、「GPUサーバーは高いし、クラウドに機密データを置くのは不安」──そんな悩みを抱える企業や開発者に朗報です。

Appleの最新チップ「M4」を積んだMac MiniとMacBook Proを、英国スタートアップExo Labsのオープンソースソフトで束ねれば、Meta Llama‑3.1 405BやQwen 2.5 Coder‑32Bといった最上位クラスのLLMを自宅やオフィスで―しかも合計5,000ドル未満で―動かせる時代が到来しました。

この記事では、MacM4を活用したローカルLLMの具体的な構成・性能・コスト比較から企業導入のヒントを徹底解説します。

この記事の内容は上記のGPTマスター放送室でわかりやすく音声で解説しています。

革新的基盤技術: Apple M4チップがもたらすGPU依存からの解放

2024年10月発表のM4チップが、AI推論の世界に新たな選択肢をもたらしています。M4チップが持つ以下の特性をExo Labsが巧みに活用しました。

- 最大10コアCPUと革新的な新設計GPU

- 優れた電力効率と単一スレッド性能

- 高速メモリ帯域幅と専用ニューラルエンジン

その結果、驚くべきことにわずか600ドル前後のMac Miniで、NVIDIA H100に匹敵するトークン生成速度を実現しています。しかも消費電力はわずか「数ワット級」という圧倒的な効率性を誇ります。

「高価なGPUをクラウドでレンタルする」という従来のAI開発の常識が、今まさに覆されようとしています。

Exo Labsとは何者か?オープンソース×分散AIへの挑戦

Exo Labsは2024年3月創業の分散コンピューティング企業です。共同創業者のAlex Cheema氏はオックスフォード大学で物理学を学び、Web3系企業で分散システムを手掛けた経歴をもつエンジニア。

同社が公開する「Exo」はGNU GPLライセンスで誰でも無償利用でき、複数デバイス間に自動でワークロードを分散。ネットワーク帯域やレイテンシを隠蔽しつつ、単一マシンには載り切らない30B〜400B級モデルを走らせられる点が特徴です。コミュニティ主導で改良が進み、GitHubスターは公開4か月で1万を突破しました。

4台のMac Mini+1台のMacBook Proで32Bモデルが動く衝撃

Cheema氏はM4 Mac Mini×4+M4 Max MacBook Pro×1の合計約5,000ドル構成で、Alibaba製Qwen 2.5 Coder‑32Bを毎秒18トークン、Nvidia Nemotron‑70Bを毎秒8トークンで推論するデモをXに投稿しました。コスト効率の衝撃的な比較は以下のとおりです。

コスト効率比較

| システム構成 | 価格 | 性能特性 |

|---|---|---|

| NVIDIA H100単体 | 25,000ドル超 | 最高速だが初期投資が膨大 |

| Mac Mini×4 + MacBook Pro | 約5,000ドル | H100の1/4〜1/3の速度、コストは約1/5 |

| M3 MacBook Pro×2台 | さらに低コスト | Llama-3.1 405B級モデルでも毎秒5トークン超 |

特筆すべきは、旧世代のM3 MacBook Proでさえ、405B規模の大型モデルを実用的な速度で動作させられる点です。

ローカルLLM導入がもたらす3大メリット

1. コスト最適化

クラウドGPUの利用料(H100で1時間15〜25ドル)と比較すると、長期利用での優位性は明らかです。社内での継続的な推論やPoC(実証実験)では、わずか1か月で数千ドル規模のコスト差が生じます。

2. データセキュリティの確保

機密性の高い設計図や顧客データを外部APIに送信する必要がなく、GDPR(欧州一般データ保護規則)や改正個人情報保護法へのコンプライアンスリスクを大幅に低減できます。データ主権を自社内に保持したまま、先進的AIを活用できる点は経営層にとって大きな安心材料となります。

3. 応答速度の向上

社内LANで完結するため、200ミリ秒以下の高速応答が可能です。これにより以下が実現されます。

- チャットボットが「待たせない」ユーザー体験を提供

- コーディングアシスタントがリアルタイムに近い支援を実現

- 特に医療・金融など即時性が求められる業界での活用に最適

分散処理の壁を突破する技術的イノベーション

ローカルLLM最大の課題は「台数を増やすとネットワーク通信がボトルネックになる」ことです。

Exo Labsは高速通信規格「gRPC」をベースにした独自プロトコルを開発をしました。モデル間で送受信されるデータを「8ビット量子化」(精度をやや落として容量を削減する技術)で圧縮し、さらに過去の計算結果を記憶する「ステートフル」な”トークン先読み”アルゴリズムを実装しています。これにより通信帯域を最大60%削減し、一般的なネットワーク環境でも快適な分散処理を実現しました。

このためThunderbolt 5接続のMac Miniクラスタでも線形近似のスケールアウトを維持し、高精度を保ったまま推論速度を稼げます。分散DBで培われたReplica管理手法を応用し、ノード障害時の自動リカバリもサポートしています。

企業導入の展望――RegTechから生成AI開発まで

既に欧州のフィンテック企業が、顧客のKYC書類を社内ネットワーク内でOCR・要約する用途でExoをテスト中とのこと。ヘルスケアでは電子カルテを外部に出さずに症状推論を行うPoCが進行中です。

また、ゲーム開発会社がNemotron‑70Bをローカルクラスタで走らせ、ストーリー自動生成を高速化する事例も報告されています。クラウド禁止の規制業界やGPU不足に悩む中小企業にとって、Mac+Exo構成は手頃でスケーラブルな選択肢となり得ます。

導入時は①10GbE以上のネットワーク、②1500W程度の電源容量、③LLM量子化ツール(GGUF/MLX)の知識がポイントです。

次の一手:ベンチマーク公開とエンタープライズ版

Exo Labsは今後、無料のハードウェアベンチマークサイトを公開予定です。単機M4から128台規模クラスタまでの実測値を共有し、ユーザーが目的と予算に合う構成を比較検索できる仕組みを提供。

さらに2026年初頭には、Macハード込みの「Exo Enterprise Kit」をサブスクリプション販売する計画も明かしています。オンサイト設置・運用支援に加え、モデルのセーフティ監査やパッチ配信を担うマネージドサービスを準備中とのこと。国内SIerとの提携が実現すれば、日本企業の“生成AI内製化”のハードルは一気に下がるでしょう。

M4 MacでのローカルLLM運用:まとめ

M4 MacとExo Labsの組み合わせは、「GPUクラウド一択」というAIインフラの常識を覆す可能性を秘めています。

5,000ドル前後の投資で、400B級モデルさえオフラインで動かせる――この事実は、AIの民主化を加速させるだけでなく、データ主権やコスト最適化の観点からも企業戦略を根底から再考させる契機になるはずです。あなたの組織が「生成AIをどう運用するか?」を検討する際、本記事が具体的な第一歩となれば幸いです。