生成AIの企業利用が広がるにつれ、「モデルの性能」だけでなく「どれだけのコストで安定して動かせるか」が重要な論点になっています。とくに業務でのチャット利用や社内ツール連携が進む現在、学習よりも推論処理にかかる負荷とコストが、AI基盤全体の設計を左右するようになりました。

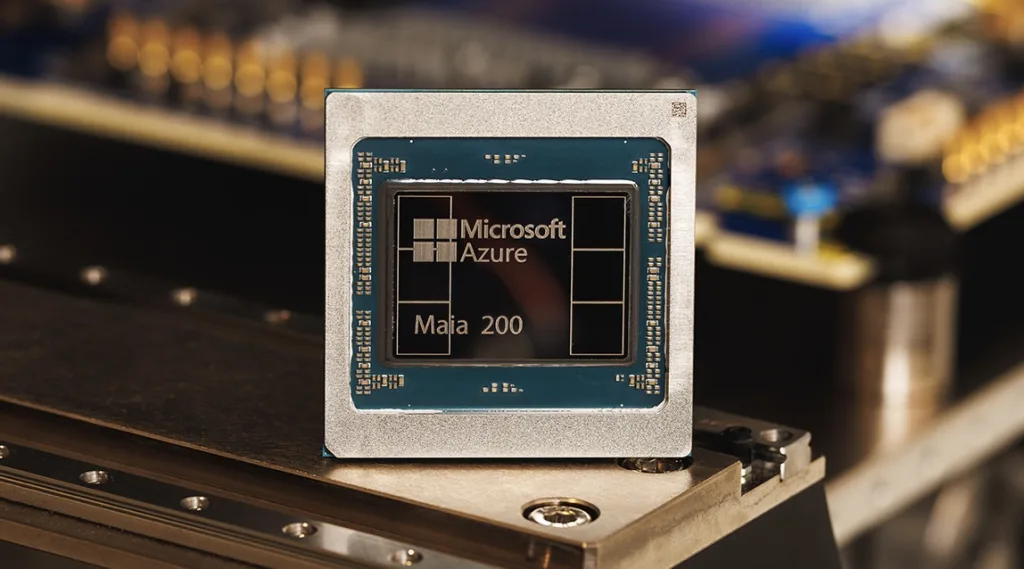

こうした背景の中、Microsoft はAI推論に特化した新しい自社チップMaia200を発表しました。従来のGPU依存から一歩進み、推論処理を効率化するための専用設計を打ち出した点が特徴です。本記事では、Microsoftの新AIチップがどのような位置づけにあり、なぜ「推論特化」が重視されているのかを整理します。そのうえで、情シス部門が今後のAI基盤設計を考える際に、どのような視点を持つべきかを解説します。

Microsoftが発表した新AIチップMaia200

Microsoftが発表した新しいAIチップMaia200はモデルの学習ではなく、推論処理を主な用途として設計されている点が最大の特徴です。大規模言語モデルの学習には依然として高性能GPUが不可欠ですが、企業の実運用では「学習より推論」の比重が圧倒的に高くなっています。

たとえば、社内チャットボットや問い合わせ対応、検索補助、文章要約など、多くの業務系AIはすでに学習済みモデルを使い、日常的に推論を繰り返しています。このとき問題になるのが、推論コストの積み重なりです。利用者が増えるほど処理回数が増え、クラウド利用料が膨らみやすくなります。

Microsoftはこの課題に対し、汎用GPUだけに頼らず、推論処理に最適化した自社チップをクラウド基盤に組み込む戦略を取っています。これは、Amazon や Google が独自チップを開発してきた流れとも重なりますが、Microsoftの場合は生成AIの業務利用を前提とした設計思想が色濃く出ています。

この新チップは、単に性能を競うものではなく、安定した推論処理をより低コストで提供することを目的としています。クラウド事業者として、AIの利用が増えれば増えるほどインフラ効率が重要になるため、推論特化という方向性は極めて合理的だと言えます。

なぜ今 推論特化が重視されているのか

生成AIの話題では、これまでモデルの規模や学習性能に注目が集まりがちでした。しかし、企業利用が本格化した現在、関心は次第に「どう学習するか」から「どう使い続けるか」へと移っています。その中心にあるのが、推論処理の効率です。

企業の現場で使われる生成AIの多くは、すでに学習済みのモデルを前提としています。社内FAQ、業務文書の要約、問い合わせ対応、検索補助など、日常業務では大量のリクエストが継続的に発生します。ここで重要になるのは、一回あたりの処理速度や消費電力よりも、長期間にわたって安定して処理できるコスト構造です。

汎用GPUは高い性能を持つ一方で、推論用途ではオーバースペックになりやすく、コスト効率の面で課題が残ります。とくに利用者が増え、24時間稼働が前提になると、クラウド利用料の増加が避けられません。この問題は、生成AIを「実験」から「業務インフラ」へと位置づける企業ほど顕在化します。

推論特化チップは、こうした課題に対する現実的な解決策として登場しています。学習に必要な柔軟性をある程度割り切ることで、推論処理に必要な演算を効率化し、消費電力やコストを抑える設計が可能になります。これは、生成AIを大量に使うクラウド事業者にとっても、利用企業にとっても利点が大きい方向性です。

推論特化が重視される背景

また、推論特化が重視される背景には、AI活用の質的変化もあります。単発の質問応答ではなく、業務アプリや社内システムと連携し、常時動作するAIが増えているため、推論処理は断続的ではなく連続的に行われます。このような使い方では、わずかなコスト差が全体では大きな差になります。

この流れを踏まえると、推論特化チップは単なるインフラの話ではなく、生成AIをどこまで業務に組み込めるかを左右する要素だと言えます。次章では、こうしたMicrosoftのアプローチを、他のクラウド事業者の動きと比較しながら整理します。

AmazonやGoogleとの違い

MicrosoftのAI推論チップ戦略は、他のクラウド事業者と共通点がありつつも、狙いどころに違いがあります。AmazonやGoogleも独自チップを開発していますが、それぞれ自社サービスへの最適化を強く意識した設計です。

一方でMicrosoftは、生成AIを業務アプリや社内システムに組み込む利用シーンを重視しています。クラウド基盤単体ではなく、AIを実際に使う現場まで含めた全体最適を狙っている点が特徴です。この違いは、今後のAI基盤選定において、単なる性能比較以上に重要な判断材料になります。

企業のAI基盤とコストへの影響

推論特化チップの登場は、企業のAI基盤設計に直接的な影響を与えます。とくに変わるのは、生成AIを「一部の実験用途」ではなく、「常時稼働する業務基盤」として使う前提でのコスト設計です。

これまで推論処理は汎用GPUに依存するケースが多く、利用量の増加に比例してクラウド費用が膨らみやすい構造でした。推論特化チップがクラウド側に組み込まれることで、同じ処理をより低コストで安定的に実行できる可能性が広がります。

その結果、AI活用の対象を一部の部署に限定するのではなく、全社的に展開しやすくなる点は大きな変化です。チャットボットや検索補助、業務支援AIを「使わせない理由」が減り、活用範囲の拡大を検討しやすくなります。

一方で、インフラの詳細が見えにくくなる分、コスト構造を正しく理解しないと想定外の利用増加につながるリスクもあります。推論コストが下がるからこそ、利用設計とモニタリングの重要性はむしろ高まります。

情シスが検討すべきポイント

Microsoftの推論特化チップMaia200は、情シス部門にとってAI基盤を見直す好機になります。ただし、性能やコストの改善だけに注目すると、運用面での課題を見落としがちです。

まず重要なのは、生成AIをどの業務に、どの規模で使うのかを明確にすることです。推論コストが下がると利用が急増しやすいため、対象業務と利用範囲をあらかじめ整理しておく必要があります。

次に、クラウド事業者のAI基盤に依存しすぎない視点も欠かせません。特定のサービスに最適化された構成は便利ですが、将来的なコストや移行の自由度を考えると、設計段階で選択肢を残しておくことが重要です。

また、推論処理が増えるほど、ログ管理や利用状況の可視化が重要になります。誰がどのAIをどれだけ使っているかを把握できなければ、コスト管理やガバナンスが追いつきません。推論特化チップは、生成AIを本格的に業務へ組み込むための土台です。情シスとしては、技術進化を前向きに捉えつつ、運用と管理をセットで設計することが求められます。

Microsoftが発表したAI推論特化チップMaia200:まとめ

Microsoftが発表したAI推論特化チップは、生成AIを企業の業務基盤として定着させるための重要な一歩です。学習性能を競う段階から、推論処理をいかに効率よく、安定して回すかという段階へ、AI基盤の焦点が移りつつあります。

推論コストの最適化は、生成AIの利用範囲を広げる大きな要因になります。一部の部門や実験用途にとどまっていたAI活用を、全社的な業務支援へ展開しやすくなる点は、情シスにとって大きなメリットです。

一方で、コストが下がるからこそ、利用設計やガバナンスを後回しにすると、想定外の利用増加や管理負荷につながる可能性もあります。推論特化チップは万能な解決策ではなく、運用とセットで価値を発揮する技術です。

情シス部門としては、クラウド基盤の進化を単なる性能向上として受け取るのではなく、生成AIをどの業務にどう組み込むかを見直す機会として捉えることが重要です。推論を前提とした設計に目を向けることが、これからのAI活用を支える基盤になります。